KI in der Cybersicherheit: Wie sich KI auf den Kampf gegen Cyberkriminalität auswirkt

Inhalt

Der Einsatz von KI-Cybersicherheit im Kampf gegen digitale Schwachstellen

Die Zunahme von KI-Cyberangriffen: Wie Hacker KI nutzen, um die Sicherheit zu kompromittieren

Wie Bot-Betreiber KI nutzen, um sich nach der Erkennung schneller anzupassen

Durch maschinelles Lernen unterstützte Malware und Ransomware

Die dynamische Entwicklung der KI-Cybersicherheit

Künstliche Intelligenz (KI) verändert beinahe jede Branche mit rasanter Geschwindigkeit – und Cybersicherheit ist dabei keine Ausnahme. KI wirkt sich in diesem Bereich in zweifacher Hinsicht aus: Einerseits nutzen Cyberkriminelle KI, um raffiniertere und gezieltere Cyberangriffe durchzuführen; andererseits treibt KI bedeutende Fortschritte bei Abwehrmaßnahmen und Cybersicherheit voran, sodass Sicherheitsteams schneller und präziser denn je Angriffe erkennen und darauf reagieren können.

In diesem Blogbeitrag befassen wir uns mit dieser Transformation in der Cybersicherheit. Wir wollen uns einmal genauer ansehen, wie Cybersicherheitsexperten KI einsetzen, um auf komplexere und gezieltere Angriffe zu reagieren.

Der Einsatz von KI-Cybersicherheit im Kampf gegen digitale Schwachstellen

Cyberschwachstellen haben in den letzten Jahren deutlich zugenommen, und die rasante Entwicklung der künstlichen Intelligenz spielt eine wichtige Rolle bei diesem exponentiellen Wachstum. Mithilfe von KI können Cyberkriminelle und Hacker Schwachstellen effektiver ausnutzen, Erkennung vermeiden, raffiniertere Angriffe ausführen und ihre Aktivitäten skalieren.

Die Zunahme von KI-Cyberangriffen: Wie Hacker KI nutzen, um die Sicherheit zu kompromittieren

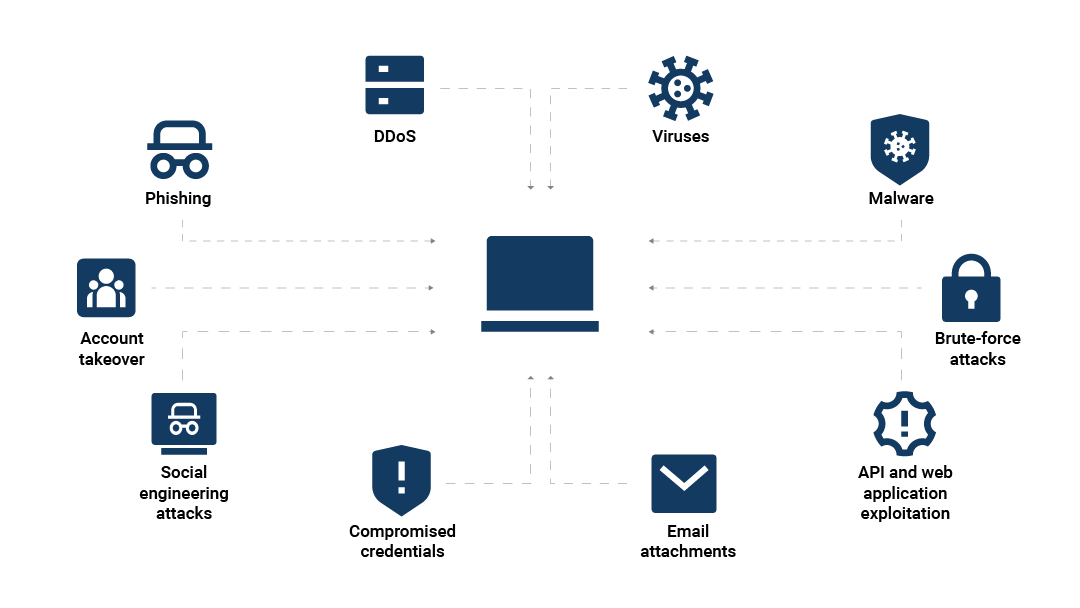

Abbildung 1 zeigt die wichtigsten Möglichkeiten, wie KI Cyberangriffe verstärken kann, wie zum Beispiel:

KI-basierte Phishing-Angriffe

Durch maschinelles Lernen unterstützte Malware und Ransomware

KI für Social Engineering

KI-basierte Phishing-Angriffe

Ein Phishing-Angriff ist eine Art von Cyberangriff, bei dem ein Cyberkrimineller eine Person dazu verleitet, sensible Informationen preiszugeben, indem er sich als vertrauenswürdige Quelle ausgibt.

KI-gestützte Techniken wie Deepfakes und komplexer, KI-gesteuerter Identitätsbetrug haben zur Folge, dass Phishing-Angriffe heute realistischer, persönlicher und schwerer zu erkennen sind. So kennt man beispielsweise schon seit Jahrzehnten Anrufe, bei denen sich Anrufer als jemand anderes ausgeben. Mit KI jedoch kann der Angreifer persönliche Informationen von Menschen aus dem näheren Umfeld des Opfers einfließen lassen.

Bei KI-Phishing-Angriffen verwenden Cyberkriminelle verschiedene KI-Trainingsmodelle wie Verhaltensanalyse, nachgebildete Stimmen und NLP-Modelle (Natural Language Processing), um hyperrealistische, KI-generierte Cyberangriffe zu erzeugen. Mit diesen Technologien können Angreifer das Erscheinungsbild, die Stimme und sogar den Schreib- und Sprechstil von Freunden und Kollegen des Opfers überzeugend nachahmen. Das erleichtert es den Kriminellen, die ins Visier genommenen Personen zu täuschen und ihre Erfolgsquote zu erhöhen.

Deepfakes sind die neuesten Tools für KI-gesteuertes Phishing

Eine zunehmend verbreitete Anwendung von KI in der Cyberkriminalität ist der Einsatz von maschinellem Lernen zur Erstellung von Medien wie Videos, Bildern und Audios, die authentisch erscheinen, aber vollständig gefälscht sind. Das Aufkommen von Deepfake-Technologien in der Cyberkriminalität stellt eine zunehmende Bedrohung dar, und die Folgen, die sich ergeben, wenn man Opfer eines Deepfake-Phishing-Betrugs wird, können verheerend sein.

Anfang 2024 nahm ein Angestellter in Hongkong an einer Videokonferenz mit Betrügern teil, die Deepfake-Darstellungen seiner Kollegen verwendeten und ihn dazu brachten, Gelder seines Unternehmens in Höhe von 25 Millionen US-Dollar an die Betrüger zu überweisen.

Wie Bot-Betreiber KI nutzen, um sich nach der Erkennung schneller anzupassen

Bot-Management war schon immer ein Katz-und-Maus-Spiel: Sicherheitsunternehmen entwickeln bessere Erkennungslösungen. Bot-Betreiber lernen, wie sie eine Erkennung umgehen können. Die Sicherheitsunternehmen entwickeln neue Erkennungsmethoden, und so geht es immer weiter.

Mithilfe von KI können Bot-Betreiber das Verhalten auf raffiniertere Weise steuern und die Zeit verkürzen, die erforderlich ist, um neue Erkennungen zu umgehen, anpassungsfähigere Angriffsmethoden zu verwenden und menschliche Interaktionen genauer nachzuahmen. Die folgenden Anzeichen deuten auf einen Bot-Betreiber hin, der KI nutzt:

Schnelle Entwicklung von Taktiken: Angriffsmethoden ändern sich schnell als Reaktion auf die Erkennung.

Zunehmende Verhaltensvariationen: KI-gesteuerte Bots können Techniken wie automatisiertes Fuzzing verwenden, um Permutationen zu untersuchen und Abwehrmechanismen zu umgehen.

Nachahmung menschlicher Interaktion: Dies umfasst avancierte Formen der Nachahmung des Verhaltens echter Nutzer, einschließlich randomisierter Muster bei Klicks, Tastenanschlägen oder Mausbewegungen.

Durch maschinelles Lernen unterstützte Malware und Ransomware

KI-gesteuerte Cyberbedrohungen gibt es in vielen Formen. In den letzten Jahren hat die rasante Entwicklung von KI-Malware Hackern ermöglicht, schwerer zu detektierende, anpassungsfähigere Malware zu erstellen, die die Effektivität von Malware- und Ransomware-Angriffen deutlich erhöht.

Ransomware, eine Art von Malware, die die Daten eines Opfers verschlüsselt und ein Lösegeld für deren Freigabe fordert, ist durch die Integration von KI noch bedrohlicher geworden. Cyberkriminelle können KI nun bei Ransomware-Angriffen verwenden, um Erkennung zu vermeiden und schnellere, komplexere Angriffe durchzuführen.

Mit KI-gestützter adaptiver Malware können Hacker Sicherheitsmechanismen effektiver umgehen. Durch die Analyse des Netzwerk-Traffics lernt diese Art von Malware, wie sie legitimes Nutzerverhalten nachahmt und ihre Aktionen, ihren Kommunikationsstil und Code ändern kann, um eine Erkennung durch herkömmliche Sicherheitssysteme zu vermeiden.

Darüber hinaus ermöglichen Algorithmen für maschinelles Lernen Angreifern, Schwachstellen in Sicherheitssystemen genauer zu identifizieren, die wertvollsten Daten anzuvisieren und Verschlüsselungsmethoden an die spezifischen Eigenschaften eines Systems anzupassen, wodurch die Entschlüsselung gestohlener Informationen erschwert wird. Manche Ransomware-Angreifer nutzen KI auch, um bestimmte Aufgaben wie Verschlüsselung zu automatisieren und so Angriffe zu beschleunigen und Opfern weniger Reaktionszeit zu lassen.

KI für Social Engineering

Bei Social-Engineering-Angriffen verlassen sich Angreifer auf psychologische Manipulation und Täuschung, um sensible Informationen oder Vermögenswerte von ihren Zielen zu erhalten. Durch den Einsatz von KI für Social Engineering können Angreifer stärker personalisierte Betrugsstrategien entwickeln, die für Einzelpersonen schwieriger zu erkennen sind.

Mithilfe von KI-Analysen können Cyberkriminelle hochgradig personalisierte Social-Engineering-Betrugsmethoden entwickeln. Durch die Anreicherung von Phishing-E-Mails und anderen Phishing-Kanälen mit persönlichen Details, aktuellen Ereignissen und emotionalen Triggern, die aus der digitalen Präsenz des Opfers gewonnen werden, können Angreifer Nachrichten erstellen, die erstaunlich echt und vertrauenswürdig erscheinen.

Angreifer nutzen zunehmend auch Konversations-KI für ihre kriminellen Zwecke, um ihre Aktivitäten zu skalieren, wodurch sich Cyberbedrohungen wie KI-gestützte Chatbot-Scams noch weiter ausbreiten. KI-Chatbot-Modelle können nun menschliche Gespräche mit beeindruckender Genauigkeit imitieren, indem sie überzeugende Argumente formulieren und lernen, emotionale Signale auszunutzen. Durch die Nutzung von KI-Chatbots für Cyberangriffe können Angreifer Interaktionen automatisieren und haben so mehr Zeit zur Verfügung, um eine größere Anzahl von Opfern ins Visier zu nehmen, ohne sich selbst auf direkte Konversationen einlassen zu müssen.

Die Rolle von KI bei Bedrohungserkennung und Sicherheit

Es ist wahr, dass KI das Potenzial hat, Cyberbedrohungen zu verstärken. Sie bietet jedoch in gleicher Weise das Potenzial, die Cybersicherheit zu verbessern. Da KI-Technologien zur Bedrohungserkennung das Potenzial von maschinellem Lernen nutzen, können sie Unternehmen besser als herkömmliche Maßnahmen dabei unterstützen, Bedrohungen schnell und präzise zu erkennen und abzuwehren.

Zu den Anwendungsfällen für KI bei der Verbesserung von Sicherheitssystemen gehören:

Verbesserung der Bedrohungserkennung mit KI

KI-gesteuerte Cybersicherheits-Tools, die durch maschinelles Lernen angetrieben werden, können riesige Datenmengen in Echtzeit analysieren, Muster erkennen und Anomalien identifizieren, die auf potenzielle Bedrohungen hinweisen könnten. Die Geschwindigkeit dieser Analyse ermöglicht es Cybersicherheitsexperten, Sicherheitsvorfälle schneller und genauer als je zuvor zu erkennen.

Fortschrittliche, auf maschinellem Lernen basierende KI-Tools können Sicherheitsexperten auch dabei unterstützen, notorisch schwer zu entdeckende Bedrohungen wie laterale Netzwerkbewegungen zu erkennen. Laterale Bewegung ist die Taktik, mit der Angreifer unentdeckt durch ein Netzwerk navigieren, um hochwertige Ziele zu identifizieren und ihren Zugriff auszuweiten.

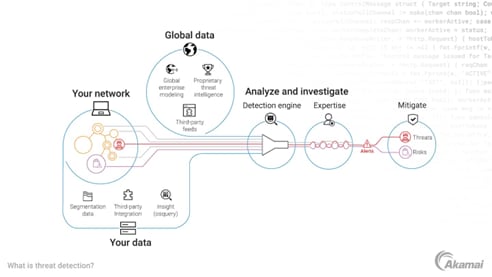

Akamai verwendet beispielsweise Graph Neural Networks (GNNs), um potenzielle laterale Bewegungen innerhalb eines Netzwerks zu entdecken. GNNs lernen zunächst die typischen Interaktionen zwischen den Assets eines Netzwerks und nutzen dieses Wissen dann, um zukünftige Interaktionen vorherzusagen. Wenn das Verhalten eines Assets erheblich vom etablierten Muster abweicht, wird dies als potenzieller Indikator für laterale Bewegungen gemeldet.

Abbildung 2 zeigt, wie Akamai KI in seinen Cybersicherheitsdiensten Akamai Guardicore Segmentation und Akamai Hunt verwendet.

Priorisierung von Bedrohungen und Automatisierung der Reaktionen

Eine weitere wichtige Rolle spielt KI bei der Verbesserung von Sicherheitsvorgängen, indem sie automatisierte Vorfallsreaktionen ermöglicht, was die Reaktionszeiten im Vergleich zu manuellen Eingriffen erheblich verkürzt. Die mit KI automatisierte Vorfallsreaktion beschleunigt die Reaktion auf Bedrohungen und minimiert den potenziellen Schaden in Unternehmen, bevor ein Problem eskaliert.

Das funktioniert so: Sobald eine Bedrohung erkannt wird, führen KI-basierte Systeme automatisch vordefinierte Aktionen aus, um das Risiko zu neutralisieren. Beispiele hierfür sind die Isolierung von betroffenen Assets oder die Blockierung von schädlichem Traffic, der nicht ins Netzwerk eindringen darf. Darüber hinaus bewerten und bestimmen die auf maschinellem Lernen basierenden KI-Algorithmen den Schweregrad von Bedrohungen und priorisieren die Reaktionen nach Dringlichkeit.

Dank ihrer unglaublichen Geschwindigkeit und ihrer Fähigkeit, mehrere Bedrohungen gleichzeitig zu bewältigen, bieten KI-Systeme Unternehmen einen effizienteren und effektiveren Ansatz für das Risikomanagement, da sie neue Bedrohungen in Echtzeit und in einem großen Maßstab angehen können.

Verbesserung der vorausschauenden Threat Intelligence

Cybersicherheitsexperten können künstliche Intelligenz nutzen, um potenzielle Bedrohungen basierend auf historischen Trends vorherzusagen und zu verhindern, was die Genauigkeit ihrer Bedrohungserkennungsfunktionen erhöhen kann.

KI-Modelle für maschinelles Lernen analysieren große Datensätze aus einer Vielzahl von Quellen. Mithilfe dieser Analyse von Informationen, die unter anderem aus früheren Vorfallsberichten, Sicherheitsprotokollen und Netzwerktraffic-Mustern stammen, können Cybersicherheitsteams Trends und Gesetzmäßigkeiten erkennen und so ihr Verständnis häufiger Cyberbedrohungen vertiefen.

Die KI-Systeme können diese Trends dann nutzen, um vorherzusagen, wann und wie zukünftige Bedrohungen auftreten werden, und sie können Automatisierung als vorbeugende Maßnahme einrichten, schon bevor eine Bedrohung eingetreten ist.

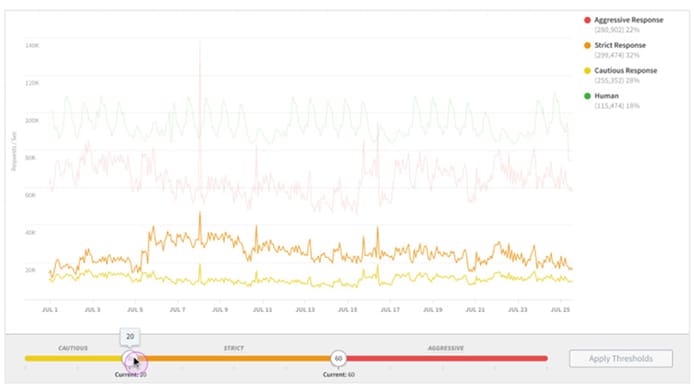

Akamai Bot Manager verwendet beispielsweise ein KI-Framework zur Überwachung des Bot-Traffics und zur Erkennung von Bedrohungen am Netzwerkrand, skalierbar und in Echtzeit (Abbildung 3).

Grenzen verstehen: Wann bietet KI unter Umständen keine Antwort

Obwohl KI erhebliche Verbesserungen der Cybersicherheit bietet, ist es wichtig, sich ihrer Grenzen bewusst zu sein.

KI-Systeme lernen ausschließlich aus den Daten, die ihnen zur Verfügung gestellt werden, und sie verfügen nicht über die Fähigkeit des Menschen, den breiteren Kontext zu betrachten. Aus diesem Grund können KI-Systeme in differenzierten, komplexen Situationen Schwierigkeiten mit der Entscheidungsfindung haben. Wenn ein KI-System mit unvollständigen oder verzerrenden Daten trainiert wird, spiegelt sich die Unvollständigkeit oder Verzerrung auch in den resultierenden Entscheidungen entsprechend wider.

Dieser Mangel an Nuancierung kann auch dazu führen, dass KI-Systeme gelegentlich legitimen Traffic als potenzielle Bedrohung markieren, was zu falsch positiven Ergebnissen führt. Falsch positive Ergebnisse können legitime Nutzer daran hindern, Transaktionen durchzuführen, was für Unternehmen Geschäftseinbußen oder eine abnehmende Kundenzufriedenheit zur Folge haben kann.

Und da KI zum Lernen auf große Datenmengen angewiesen ist, sind Datenschutz und Sicherheit gefährdet. Ohne angemessene Sicherheitsmaßnahmen riskieren Unternehmen, dass Angreifer im Falle einer Datenschutzverletzung unbefugten Zugriff auf potenziell große Mengen sensibler Daten erhalten.

Es ist davon auszugehen, dass der Einsatz von KI branchenübergreifend zunehmen wird. In einer aktuellen McKinsey-Umfrage zum Stand der KI gaben 71 % der Befragten an, ihr Unternehmen nutze generative KI regelmäßig in mindestens einer Geschäftsfunktion. Im vergangenen Jahr waren es dagegen nur 65 % und 2023 sogar nur 33 %.

Da KI-Systeme immer leistungsfähiger werden, werden sie in den kommenden Jahren voraussichtlich eine noch größere Rolle bei der Cyber-Abwehr einnehmen. KI wird mit hoher Wahrscheinlichkeit weitere Fortschritte bei der Erkennung und Abwehr von Bedrohungen ermöglichen, sodass Cybersicherheitsteams ihre Bemühungen kontinuierlich skalieren und schneller auf Bedrohungen reagieren können.

Einsatz von KI für eine sicherere digitale Welt

KI spielt bei Cyberangriffen und Cybersicherheit in immer stärkeren Maße eine entscheidende Rolle. Angesichts eines sich stetig ausweitenden, äußerst komplexen Bedrohungsszenarios ist Akamai Vorreiter bei der strategischen und transparenten Implementierung von KI, um die Sicherheit zu verbessern.

Die KI-basierten Cybersicherheits-Tools von Akamai erfüllen eine Vielzahl wichtiger Aufgaben. Innovative KI-basierte Lösungen wie Akamai Hunt ermöglichen es Unternehmen, Bedrohungen schneller und genauer als je zuvor zu erkennen und darauf zu reagieren. Akamai Guardicore Platform kombiniert modernste KI-Technologie mit der Expertise von Akamai, damit Kunden Zero Trust erreichen, Ransomware-Risiken reduzieren und Compliance-Anforderungen erfüllen können.

Stärken Sie die Sicherheit in Ihrem Unternehmen mit Cybersicherheitslösungen, die KI verantwortungsbewusst und effektiv nutzen.