La IA en ciberseguridad: cómo afecta la IA a la lucha contra la ciberdelincuencia

Contenido

Luchar en la batalla continua de las vulnerabilidades digitales con la ciberseguridad de la IA

El auge de los ciberataques con IA: Cómo utilizan los hackers la IA para vulnerar la seguridad

Los operadores de bots utilizan la IA para reaccionar más rápidamente después de ser detectados

Malware y ransomware basados en tecnología de aprendizaje automático

El papel de la IA en la detección de amenazas y la seguridad

El cambiante panorama de la ciberseguridad de la IA

La inteligencia artificial (IA) está transformando rápidamente casi todos los sectores, y la ciberseguridad no es una excepción. El impacto de la IA sobre el terreno es doble: por un lado, los ciberdelincuentes utilizan la IA para llevar a cabo ciberataques más sofisticados y dirigidos; por otro lado, la IA está impulsando avances significativos en las defensas de ciberseguridad, lo que permite a los equipos de seguridad identificar y responder a los ataques con mayor velocidad y precisión que nunca.

En esta entrada del blog, exploraremos esta transformación de la ciberseguridad profundizando en las formas en que los expertos en ciberseguridad utilizan la IA para responder a ataques más sofisticados y dirigidos.

Luchar en la batalla continua de las vulnerabilidades digitales con la ciberseguridad de la IA

Las vulnerabilidades cibernéticas han aumentado significativamente en los últimos años, y la rápida evolución de la inteligencia artificial está desempeñando un papel clave en este crecimiento exponencial. La IA permite a los ciberdelincuentes y hackers aprovechar las vulnerabilidades de forma más eficaz, evitar la detección, ejecutar ataques más sofisticados y ampliar sus operaciones.

El auge de los ciberataques con IA: Cómo utilizan los hackers la IA para vulnerar la seguridad

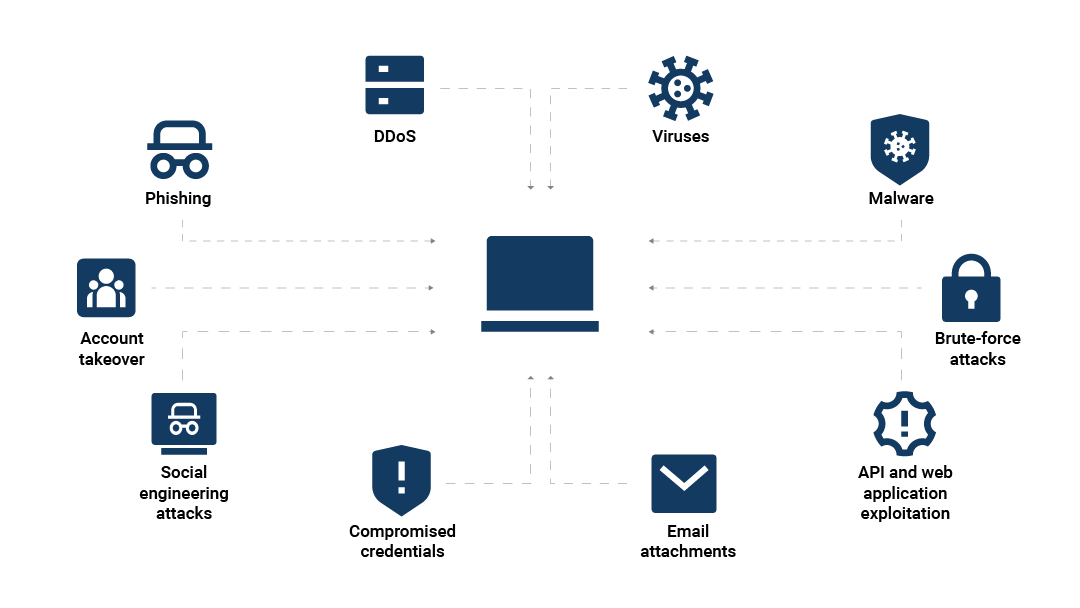

La Figura 1 muestra las principales formas en las que la IA puede amplificar los ciberataques, entre las que se incluyen:

Ataques de phishing basados en IA

Malware y ransomware basados en tecnología de aprendizaje automático

IA en ingeniería social

Ataques de phishing basados en IA

Un ataque de phishing es un tipo de ciberataque en el que un ciberdelincuente engaña a una persona para que revele información confidencial haciéndose pasar por una fuente fiable.

Las técnicas basadas en IA, como los deepfakes y las suplantaciones avanzadas basadas en IA, han hecho que los ataques de phishing sean más realistas y personales, y cada vez más difíciles de detectar. Por ejemplo, las llamadas telefónicas en las que la persona que llama suplanta a otra persona se han producido durante décadas, pero con la IA, el atacante puede incluir la información personal de alguien cercano al objetivo.

En los ataques de phishing por IA, los ciberdelincuentes utilizan varios modelos de aprendizaje por IA, como el análisis de comportamiento, la clonación de voz y los modelos de procesamiento del lenguaje natural (NLP), para crear impresiones cibernéticas hiperrealistas generadas por IA. Mediante el uso de estas tecnologías, los atacantes pueden imitar de forma convincente el aspecto, la voz o incluso los estilos de escritura y expresión oral de amigos y compañeros, lo que facilita engañar a sus objetivos y aumentar sus índices de éxito.

Los deepfakes son la herramienta más reciente en phishing basado en IA

Una aplicación cada vez más común de la IA en la ciberdelincuencia es el uso del aprendizaje automático para crear contenidos multimedia más profundos, como vídeos, imágenes y audio que parecen auténticos, pero que están completamente fabricados. El aumento de la tecnología deepfake en la ciberdelincuencia es una amenaza cada vez mayor, y las consecuencias de ser víctima de una estafa de phishing de deepfake pueden ser devastadoras.

A principios de 2024, un empleado de Hong Kong se unió a una videollamada con estafadores que utilizaron representaciones deepfake de sus compañeros de trabajo para convencerlo de que transfiriera 25 millones de dólares en fondos de la empresa a los estafadores.

Los operadores de bots utilizan la IA para reaccionar más rápidamente después de ser detectados

La gestión de bots siempre ha sido el juego del gato y el ratón: las empresas de seguridad crean mejores detecciones; los operadores de bots aprenden a evadir esas detecciones; las empresas de seguridad crean nuevas detecciones; y el patrón se repite continuamente.

La IA permite a los operadores de bots impulsar el comportamiento de formas más sofisticadas para reducir la cantidad de tiempo necesario para evadir nuevas detecciones, utilizar metodologías de ataque más adaptables y replicar más de cerca la interacción humana. Entre los indicadores de un operador de bots que aprovecha la IA se incluyen:

Rápida evolución de las tácticas: los métodos de ataque cambian rápidamente en respuesta a la detección.

Más cambios en el comportamiento: los bots basados en IA pueden utilizar técnicas como el fuzzing automatizado para explorar permutaciones y evitar las defensas.

Interacción similar a la interacción humana: implica una imitación avanzada del comportamiento real del usuario, incluidos patrones aleatorios en clics, pulsaciones de teclas o movimientos del ratón.

Malware y ransomware basados en tecnología de aprendizaje automático

Las ciberamenazas basadas en IA se presentan de muchas formas. En los últimos años, la rápida evolución del malware de IA ha permitido a los hackers desarrollar malware más evasivo y adaptable, lo que mejora significativamente la eficacia de los ataques de malware y ransomware.

El ransomware, un tipo de malware que cifra los datos de una víctima y exige un rescate para su liberación, se ha vuelto aún más potente con la integración de la IA. Los ciberdelincuentes ahora pueden utilizar la IA en los ataques de ransomware para evitar la detección y ejecutar ataques más rápidos y complejos.

El malware adaptativo basado en IA permite a los hackers eludir las medidas de seguridad de forma más eficaz. Mediante el análisis del tráfico de red, este tipo de malware de aprendizaje automático aprende a imitar el comportamiento legítimo del usuario y puede alterar sus acciones, estilo de comunicación y código para evitar la detección por parte de los sistemas de seguridad tradicionales.

Además, los algoritmos de aprendizaje automático permiten a los atacantes identificar con mayor precisión las vulnerabilidades en los sistemas de seguridad, dirigirse a los datos más valiosos y adaptar los métodos de cifrado a las características específicas de un sistema, lo que dificulta el descifrado de la información robada. Algunos atacantes de ransomware también utilizan la IA para automatizar determinadas tareas, como el cifrado, con el fin de acelerar los ataques y dejar a las víctimas menos tiempo para responder.

IA en ingeniería social

En los ataques de ingeniería social, los atacantes confían en la manipulación psicológica y el engaño para obtener información o activos confidenciales de sus objetivos. Al utilizar la IA en la ingeniería social, los atacantes pueden crear estafas más personalizadas que son más difíciles de identificar para las personas.

El análisis de IA permite a los ciberdelincuentes inventarse estafas de ingeniería social muy personalizadas. Al rellenar los correos electrónicos de phishing y otras comunicaciones con datos personales, eventos recientes y estímulos emocionales obtenidos de la huella digital del objetivo, los atacantes pueden crear comunicaciones que parezcan significativamente genuinas y puedan ganarse la confianza con mayor facilidad.

Los atacantes también utilizan cada vez más la IA conversacional en la ciberdelincuencia para ampliar sus esfuerzos, lo que hace que las ciberamenazas, como las estafas con chatbots basados en IA, sean más comunes. Los modelos de chatbot de IA ahora pueden imitar la conversación humana con una precisión impresionante, creando argumentos persuasivos y aprendiendo a explotar las señales emocionales. Al apoyarse en los bots de chat de IA para los ciberataques, los atacantes pueden automatizar las interacciones y tener así más tiempo para dirigirse a un mayor número de víctimas sin tener que entablar conversaciones directas.

El papel de la IA en la detección de amenazas y la seguridad

Aunque es cierto que la IA tiene el potencial de mejorar las ciberamenazas, su potencial de mejorar la ciberseguridad es igualmente significativo. Al aplicar el potencial del aprendizaje automático, las tecnologías de IA de búsqueda de amenazas pueden ayudar a las organizaciones a detectar y responder a las amenazas con mayor precisión y velocidad que las medidas tradicionales.

Algunos casos de uso de la IA para mejorar los sistemas de seguridad son:

Mejorar la detección de amenazas con IA

Las herramientas de ciberseguridad basadas en IA, con algoritmos de aprendizaje automático, pueden analizar grandes cantidades de datos en tiempo real, aprender patrones e identificar anomalías que podrían indicar posibles amenazas. La velocidad de este análisis permite a los profesionales de la ciberseguridad detectar incidentes de seguridad de forma más rápida y precisa que nunca.

Las herramientas avanzadas de IA de aprendizaje automático también pueden ayudar a los profesionales de la seguridad a identificar amenazas notoriamente difíciles de detectar, como el movimiento lateral. El movimiento lateral es la táctica que utilizan los atacantes para moverse lateralmente por una red sin ser detectados, identificar objetivos de alto valor y ampliar su acceso.

Por ejemplo, Akamai utiliza redes neuronales gráficas (GNN) para detectar posibles movimientos laterales dentro de una red. Las GNN aprenden primero las interacciones típicas entre los activos de una red y luego utilizan este conocimiento para predecir interacciones futuras. Si el comportamiento de un activo se desvía significativamente del patrón establecido, se marca como un posible indicador de movimiento lateral.

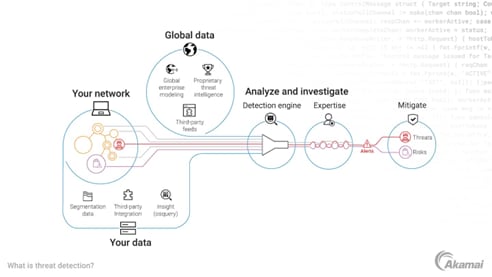

La Figura 2 ilustra cómo Akamai utiliza la IA en sus servicios de ciberseguridad Akamai Guardicore Segmentation y Akamai Hunt.

Priorizar las amenazas y automatizar las respuestas

Otro papel fundamental que desempeña la IA a la hora de mejorar las operaciones de seguridad es habilitar respuestas automatizadas a incidentes, lo que mejora significativamente los tiempos de respuesta en comparación con la intervención humana manual. Al acelerar la respuesta ante las amenazas, la respuesta a incidentes automatizada mediante IA ayuda a las organizaciones a mitigar los posibles daños antes de que un problema pueda agravarse.

Así es como funciona: Una vez que se detecta una amenaza, los sistemas basados en IA ejecutan automáticamente acciones predefinidas para neutralizar el riesgo, como aislar un activo afectado o bloquear el tráfico malicioso para que no entre en una red. Además, los algoritmos de IA de aprendizaje automático evalúan y determinan la gravedad de las amenazas y priorizan las respuestas en función de la urgencia.

Gracias a su increíble velocidad y capacidad para hacer frente a varias amenazas simultáneamente, los sistemas de IA ofrecen a las organizaciones un enfoque más eficiente y eficaz de la gestión de riesgos, ya que les permiten hacer frente a nuevas amenazas en tiempo real y a escala.

Mejorar la inteligencia predictiva contra ciberamenazas

Los profesionales de ciberseguridad pueden utilizar la inteligencia artificial para predecir y prevenir posibles amenazas en función de tendencias históricas, lo que puede aumentar la precisión de sus capacidades de detección de amenazas.

Los modelos de IA basados en aprendizaje automático analizan grandes conjuntos de datos de diversas fuentes. A través de este análisis de la información de informes de incidentes anteriores, registros de seguridad, patrones de tráfico de red y mucho más, los equipos de ciberseguridad pueden empezar a identificar tendencias y patrones, mejorando su comprensión de las ciberamenazas comunes.

Los sistemas de IA pueden utilizar estas tendencias para predecir cuándo y cómo se producirán las amenazas en el futuro, y pueden configurar la automatización como medida preventiva antes incluso de que una amenaza se materialice.

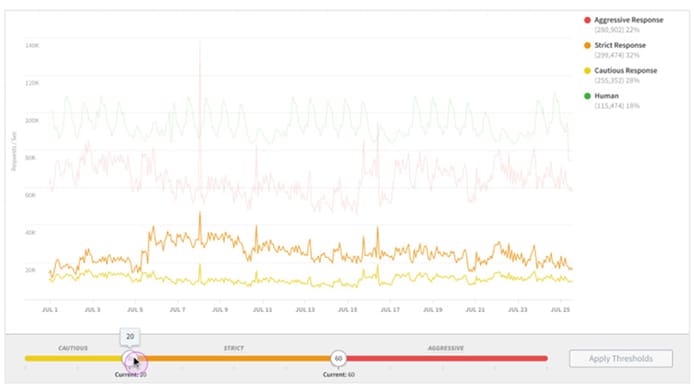

Por ejemplo, Akamai Bot Manager utiliza un marco de IA para supervisar el tráfico de bots y detectar amenazas en el edge de la red, a escala y en tiempo real (Figura 3).

Entender las limitaciones: cuando la IA puede no ser la respuesta

Aunque la IA ofrece potentes mejoras de ciberseguridad, es importante recordar sus limitaciones.

Los sistemas de IA aprenden únicamente de los datos que se les proporcionan y carecen de la capacidad humana para considerar un contexto más amplio. Debido a esto, los sistemas de IA pueden tener dificultades con la toma de decisiones en situaciones complejas y con matices. Si un sistema de IA recibe formación sobre información incompleta o sesgada, reflejará ese mismo sesgo o falta de contexto en su toma de decisiones.

Esta falta de matices también puede provocar que los sistemas de IA señalen ocasionalmente el tráfico legítimo como amenazas potenciales, lo que da lugar a falsos positivos. Los falsos positivos pueden impedir que los usuarios legítimos completen transacciones y hacer que las organizaciones pierdan negocio y disminuyan la satisfacción del cliente.

Por último, dado que la IA se basa en grandes cantidades de datos para aprender, la privacidad y la seguridad de los datos están en riesgo. Si no se adoptan las medidas de seguridad adecuadas, las empresas corren el riesgo de que los atacantes obtengan acceso no autorizado a cantidades potencialmente grandes de datos confidenciales en caso de producirse una filtración de datos.

Solo se espera que el uso de la IA crezca en todos los sectores. En una reciente encuesta de McKinsey sobre el estado de la IA, el 71 % de los encuestados afirma que sus organizaciones utilizan regularmente IA generativa en al menos una función empresarial, frente al 65 % del año pasado y un aumento significativo desde solo el 33 % en 2023.

A medida que los sistemas de IA se vayan haciendo más avanzados, se prevé que asuman un papel aún mayor en la ciberdefensa en los próximos años. Es probable que la IA aporte más avances en la detección y mitigación de amenazas, lo que permite a los equipos de ciberseguridad escalar continuamente sus esfuerzos y reaccionar ante las amenazas más rápido.

Adoptar la IA para un mundo digital más seguro

La IA desempeña cada vez más un papel crucial en los ciberataques y la ciberseguridad. Para responder a un panorama de amenazas altamente sofisticado y en continua expansión, Akamai se encuentra a la vanguardia de la implementación estratégica y transparente de la IA para reforzar la seguridad.

Las herramientas de ciberseguridad basadas en IA de Akamai realizan una serie de tareas críticas. Las innovadoras soluciones basadas en IA, como Akamai Hunt, permiten a las organizaciones detectar y responder a las amenazas de forma más rápida y precisa que nunca. La plataforma Akamai Guardicore combina la IA de vanguardia con la experiencia de Akamai para ayudar a los clientes a adoptar el Zero Trust, reducir el riesgo del ransomware y cumplir los requisitos de cumplimiento.

Mejore la estrategia de seguridad de su organización con soluciones de ciberseguridad que utilizan la IA de forma responsable y eficaz.