L'AI nella cybersecurity: come sta influenzando la lotta al crimine informatico

Sommario

Il mutevole scenario della cybersecurity dell'AI

L'intelligenza artificiale (AI) sta rapidamente trasformando praticamente ogni settore industriale e la cybersecurity non fa eccezione. L'impatto dell'AI su questo campo è duplice: da un lato, i criminali informatici stanno utilizzando l'AI per sferrare attacchi informatici più sofisticati e mirati; dall'altro lato, l'AI sta favorendo notevoli miglioramenti nei sistemi di difesa adottati nella cybersecurity, consentendo ai team addetti alla sicurezza di identificare e rispondere agli attacchi con un maggior livello di velocità e precisione che mai prima d'ora.

In questo blog, verrà descritta questa trasformazione nella cybersecurity analizzando i modi con cui gli esperti di cybersecurity stanno utilizzando l'AI per rispondere agli attacchi più sofisticati e mirati.

La continua battaglia della cybersecurity dell'AI contro le vulnerabilità digitali

Le vulnerabilità informatiche sono aumentate notevolmente negli ultimi anni e la rapida evoluzione dell'intelligenza artificiale sta svolgendo un ruolo fondamentale in questa crescita esponenziale. L'AI consente ai criminali informatici e agli hacker di sfruttare le vulnerabilità in modo più efficace, evitare il rilevamento, sferrare attacchi più sofisticati e scalare le loro attività.

L'aumento degli attacchi informatici basati sull'AI: come gli hacker utilizzano l'AI per violare i sistemi di sicurezza

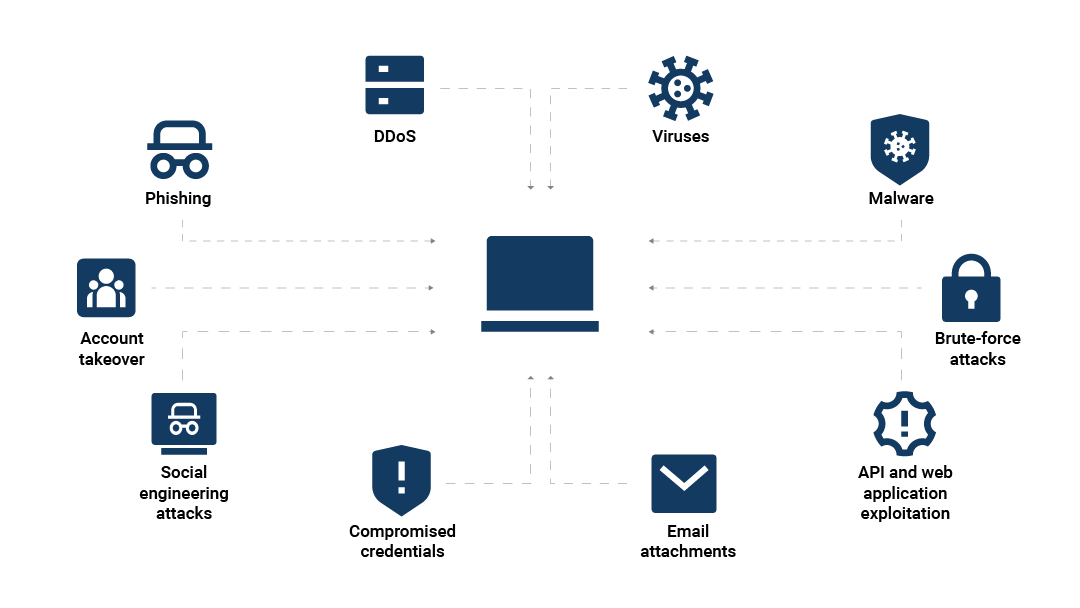

Nella Figura 1, vengono illustrati i modo principali con cui l'AI può amplificare gli attacchi informatici, tra cui:

Gli attacchi di phishing basati sull'AI

La combinazione di malware e ransomware con l'apprendimento automatico

L'AI nel social engineering

Gli attacchi di phishing basati sull'AI

Un attacco di phishing è un tipo di attacco informatico in cui i criminali riescono a mascherarsi per sembrare affidabili allo scopo di raggirare una persona portandola a divulgare informazioni sensibili.

Le tecniche basate sull'AI, come deepfake e impersonificazioni avanzate, hanno reso gli attacchi di phishing più realistici e personalizzati, nonché sempre più difficili da rilevare. Ad esempio, le chiamate telefoniche in cui il chiamante si spaccia per un'altra persona si susseguono da decenni, ma con l'AI, il criminale può includere informazioni personali che riguardano un parente o un conoscente della vittima.

Negli attacchi di phishing basati sull'AI, i criminali informatici utilizzano vari modelli di apprendimento dell'AI, come l'analisi del comportamento, la clonazione della voce e i modelli NLP (Natural Language Processing), per creare impression generate dall'AI. Utilizzando queste tecnologie, i criminali possono imitare in modo convincente l'aspetto, la voce o, persino, la calligrafia e il modo di parlare di amici e colleghi, rendendo più semplice raggirare le loro vittime e incrementando i tassi di successo.

I deepfake sono gli strumenti più recenti utilizzanti nel phishing basato sull'AI

Un'applicazione sempre più comune dell'AI nel crimine informatico consiste nell'utilizzo dell'apprendimento automatico per creare deepfake multimediali, come video, immagini e file audio, che sembrano autentici, ma, in realtà, sono interamente inventati. L'aumento della tecnologia dei deepfake nel crimine informatico è una minaccia crescente e le conseguenze derivanti dal cadere vittime di una truffa di deepfake nel phishing possono essere devastanti.

Agli inizi del 2024, un dipendente che lavora ad Hong Kong ha partecipato ad una videochiamata con alcuni truffatori che hanno utilizzato le tecniche di deepfake per impersonificare suoi colleghi in modo da convincerlo a trasferire 25 milioni di dollari di fondi aziendali nei conti dei criminali.

Gli operatori di bot utilizzano l'AI per sparire più rapidamente dopo un rilevamento

La gestione dei bot è sempre stata simile ad un gioco di inseguimento: le società che si occupano di sicurezza creano sistemi di rilevamento sempre migliori, che gli operatori di bot imparano ad eludere, quindi le società che si occupano di sicurezza creano nuovi sistemi di rilevamento e il ciclo ricomincia.

L'AI consente agli operatori di bot di influire sul comportamento in modo più sofisticato per ridurre la quantità di tempo necessaria per eludere i nuovi sistemi di rilevamento, utilizzare metodologie di attacco più adattive e replicare più da vicino un livello di engagement simile a quello umano. Tra i segni che indicano se un operatore di bot sta sfruttando l'AI, figurano i seguenti:

Rapida evoluzione delle tattiche utilizzate: i metodi di attacco cambiano rapidamente in risposta al rilevamento.

Maggiori variazioni del comportamento: i bot basati sull'AI possono usare varie tecniche, come il fuzzing automatizzato, per scoprire le varianti da poter provare per bypassare i sistemi di difesa.

Imitazione dell'interazione simile a quella umana: avanzata imitazione del comportamento degli utenti reali, tra cui modelli casuali nei clic, nelle sequenze di tasti o nei movimenti del mouse.

La combinazione di malware e ransomware con l'apprendimento automatico

Le minacce informatiche basate sull'AI si presentano in vario modo. Negli ultimi anni, la rapida evoluzione dei malware basati sull'AI ha consentito agli hacker di sviluppare malware più elusivi e adattabili, migliorando così notevolmente l'efficacia degli attacchi malware e ransomware.

I ransomware, un tipo di malware che crittografa i dati della vittima e richiede un riscatto per rilasciarli, sono diventati più sofisticati con l'integrazione dell'AI. I criminali informatici ora possono usare l'AI negli attacchi ransomware per evitare il rilevamento e sferrare attacchi più rapidi e complessi.

I malware adattivi basati sull'AI consentono agli hacker di bypassare le misure di sicurezza in modo più efficace. Analizzando il traffico di rete, questo tipo di malware con apprendimento automatico impara ad imitare il comportamento degli utenti legittimi e può alterare le azioni, lo stile di comunicazione e il codice che lo caratterizzano per evitare il rilevamento da parte dei tradizionali sistemi di sicurezza.

Inoltre, gli algoritmi di apprendimento automatico consentono ai criminali di identificare più accuratamente le vulnerabilità presenti nei sistemi di sicurezza, prendere di mira i dati più preziosi e personalizzare i metodi di crittografia in base alle specifiche caratteristiche di un sistema, rendendo più difficile decrittografare le informazioni rubate. Alcuni autori di attacchi ransomware utilizzano anche l'AI per automatizzare determinate attività, come la crittografia, allo scopo di velocizzare gli attacchi e dare meno tempo alle vittime per rispondere.

L'AI nel social engineering

Negli attacchi di social engineering, i criminali si basano sulla manipolazione psicologica e sull'inganno per ottenere informazioni o risorse sensibili dalle loro vittime. Utilizzando l'AI nel social engineering, i criminali possono personalizzare maggiormente le loro truffe per rendere più difficili da identificare.

L'analisi dell'AI consente ai criminali informatici di elaborare truffe di social engineering altamente personalizzate. Aggiungendo alle e-mail di phishing e ad altre comunicazioni dettagli personali, informazioni su eventi avvenuti di recente e stimoli emotivi ricavati dal contesto digitale della vittima possono creare comunicazioni che sembrano assolutamente autentiche e più facilmente attendibili.

I criminali, inoltre, utilizzano maggiormente l'AI conversazionale nel crimine informatico per ampliare la portata dei loro attacchi, rendendo le minacce informatiche come le truffe tramite chatbot basate sull'AI sempre più comuni. I modelli di chatbot basate sull'AI possono ora imitare la conversazione umana con straordinaria accuratezza, creando argomenti persuasivi e imparando a sfruttare i segnali emotivi. Utilizzando le chatbot basate sull'AI per i loro attacchi informatici, i criminali riescono ad automatizzare le loro interazioni in modo da poter dedicare più tempo per prendere di mira un maggior numero di vittime senza dover interagire con conversazioni dirette.

Il ruolo dell'AI nel rilevamento e nella sicurezza delle API

Anche se è vero che l'AI può potenziare le minacce informatiche, può migliorare in modo ugualmente significativo la cybersecurity. Applicando le funzionalità dell'apprendimento automatico, le tecnologie dell'AI per la ricerca delle minacce possono aiutare le organizzazioni a rilevare e a rispondere alle minacce con un maggior livello di accuratezza e velocità rispetto alla misure tradizionali.

Nell'intento di migliorare i sistemi di sicurezza, l'AI viene utilizzata anche per:

Migliorare il rilevamento delle minacce con l'AI

Gli strumenti di cybersecurity basati sull'AI, che utilizzano gli algoritmi di apprendimento automatico, possono analizzare enormi quantità di dati in tempo reale, apprendere i modelli e identificare le anomali che potrebbero indicare potenziali minacce. La velocità di questa analisi consente agli esperti di cybersecurity di rilevare gli incidenti di sicurezza più rapidamente e con maggiore accuratezza che mai prima d'ora.

Anche gli avanzati strumenti basati sull'AI con apprendimento automatico possono aiutare gli addetti alla sicurezza ad identificare le minacce più difficili da individuare come il movimento laterale, che è la tattica adottata dai criminali per esplorare una rete senza essere rilevati, identificando gli obiettivi più interessanti ed espandendo il loro accesso.

Ad esempio, Akamai utilizza le reti neurali a grafo (GNN) per rilevare il potenziale movimento laterale all'interno di una rete. Le GNN prima apprendono le interazioni tipiche che si verificano tra le risorse di una rete, quindi utilizzano queste conoscenze per predire le interazioni future. Se il comportamento di una rete devia notevolmente dal modello stabilito, viene segnalato come potenziale indicatore del movimento laterale.

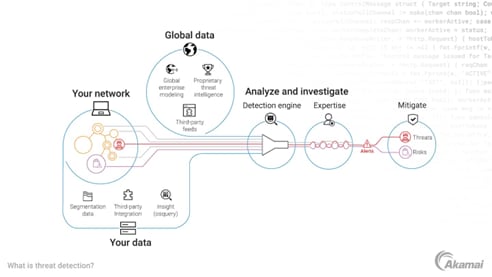

Nella Figura 2 viene illustrato il modo con cui Akamai utilizza l'AI nei suoi servizi di cybersecurity Akamai Guardicore Segmentation e Akamai Hunt.

Dare priorità alle minacce e automatizzare le risposte

Un altro ruolo di primo piano svolto dall'AI nel migliorare le operazioni di sicurezza consiste nell'automatizzare le risposte agli incidenti, ottimizzando i tempi di risposta rispetto all'intervento manuale dell'uomo. Rispondendo più rapidamente alle minacce, le funzionalità di risposta agli incidenti automatizzate e basate sull'AI aiutano le organizzazioni a mitigare i potenziali danni prima di far peggiorare il problema.

Ecco come funziona: una volta rilevata una minaccia, i sistemi basati sull'AI eseguono automaticamente le azioni predefinite per neutralizzare i rischi correlati, come isolare una risorsa compromessa o impedire al traffico dannoso di accedere ad una rete. Inoltre, gli algoritmi basati sull'AI con apprendimento automatico valutano e stabiliscono la gravità delle minacce, dando priorità alle risposte in base alla loro urgenza.

A causa della loro straordinaria velocità e della loro capacità di affrontare più minacce simultaneamente, i sistemi basati sull'AI offrono alle organizzazioni un approccio alla gestione dei rischi più efficiente ed efficace perché possono affrontare le nuove minacce in tempo reale su larga scala.

Potenziare l'intelligence sulle minacce predittiva

Gli addetti alla cybersecurity possono utilizzare l'intelligenza artificiale per predire e prevenire potenziali minacce in base ai trend storici, che possono incrementare l'accuratezza delle loro funzionalità di rilevamento delle minacce.

I modelli di AI con apprendimento automatico analizzano grandi dataset provenienti da una varietà di origini. Tramite questa analisi delle informazioni ricavate da precedenti rapporti sugli incidenti, registri della sicurezza, modelli del traffico di rete e molto altro, i team addetti alla cybersecurity possono iniziare ad identificare tendenze e modelli, perfezionando la loro comprensione delle minacce informatiche più comuni.

I sistemi basati sull'AI possono quindi usare queste tendenze per predire quando e come le future minacce si verificano e come configurare l'automazione prima ancora che si materializzi una minaccia.

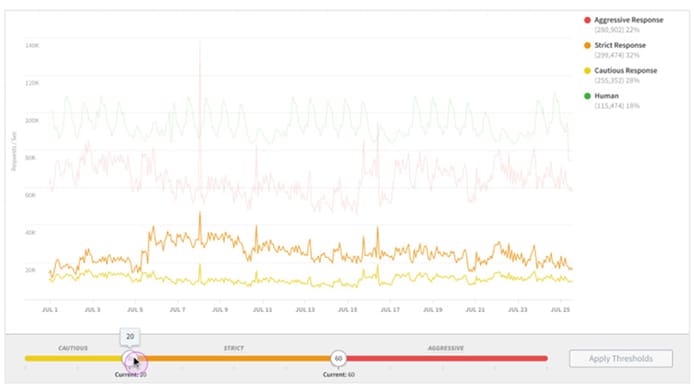

Ad esempio, Akamai Bot Manager utilizza un sistema basato sull'AI per monitorare il traffico dei bot e per rilevare le minacce sull'edge della rete su larga scala e in tempo reale (Figura 3).

Capire i limiti: quando l'AI non serve

Anche se l'AI offre notevoli miglioramenti in termini di cybersecurity, è importante ricordare i suoi limiti.

I sistemi basati sull'AI apprendono esclusivamente dai dati ricevuti, ma non dispongono della capacità propria dell'uomo di considerare un contesto più ampio. A causa di questa limitazione, i sistemi basati sull'AI possono trovare difficoltà nel prendere le decisioni in situazioni complesse e sfaccettate. Se un sistema basato sull'AI viene addestrato con informazioni incomplete o fuorvianti, mostrerà le stesse caratteristiche di incertezza o mancanza di contesto nei suoi processi decisionali.

Questa mancanza di sfumature può anche portare i sistemi di intelligenza artificiale a segnalare occasionalmente il traffico legittimo come potenziali minacce, causando falsi positivi. I falsi positivi possono impedire agli utenti legittimi di completare le transazioni e far perdere affari alle organizzazioni, che vedono così diminuire la soddisfazione dei loro clienti.

Infine, poiché l'AI si basa su grandi quantità di dati per apprendere, la privacy e la sicurezza dei dati sono a rischio. Senza misure di sicurezza adeguate, le aziende rischiano che i criminali riescano ad accedere in modo non autorizzato a quantità di dati sensibili potenzialmente grandi nel caso di una violazione dei dati.

Si prevede che l'utilizzo dell'AI crescerà in tutti i settori. In un recente sondaggio condotto da McKinsey sullo stato dell'AI, il 71% degli intervistati ha riferito che le loro organizzazioni utilizzano regolarmente l'AI generativa almeno in un'attività aziendale, salendo al 65% l'anno scorso con un notevole incremento dal 33% registrato nel 2023.

Poiché i sistemi basati sull'AI diventano sempre più avanzati, si prevede che il loro ruolo sarà ancora più importante nella difesa informatica nei prossimi anni. L'AI porterà probabilmente ulteriori progressi nel rilevamento e nella mitigazione delle minacce, consentendo ai team addetti alla cybersecurity di ampliare continuamente le loro attività e reagire più rapidamente alle minacce.

Adottare l'AI per un mondo digitale più sicuro

L'AI svolge un ruolo sempre più cruciale negli attacchi informatici e nella cybersecurity. Per rispondere ad uno scenario delle minacce in continua espansione e altamente sofisticato, Akamai è all'avanguardia nell'implementazione dell'AI in modo strategico e trasparente per rafforzare la sicurezza.

Gli strumenti di cybersecurity basati sull'AI che vengono offerti da Akamai possono eseguire varie attività critiche. Le innovative soluzioni basate sull'AI come Akamai Hunt consentono alle organizzazioni di rilevare e rispondere alle minacce in modo più veloce e accurato che mai prima d'ora. La piattaforma Akamai Guardicore unisce innovative funzionalità basate sull'AI con le competenze di Akamai per aiutare i clienti ad adottare il modello Zero Trust, a ridurre il rischio di attacchi ransomware e a soddisfare i requisiti di conformità.

Migliorate il livello di sicurezza della vostra organizzazione con soluzioni di cybersecurity che utilizzano l'AI in modo responsabile ed efficace.