AI 推論とは、キュレーションされたデータセットでトレーニングを行った AI モデルが、入力データを取得し、予測や決定などの出力を生成するプロセスのことです。トレーニングフェーズで学習した知識を新しい未知のデータに適用します。

人工知能(AI)は、システムがデータに基づいてインテリジェントな意思決定を行えるようにすることで、ヘルスケアから自動運転車まで、さまざまな業界に変革をもたらしてきました。これらの AI システムの中心にあるのが、AI 推論のプロセスです。AI 推論は、トレーニングされた AI モデルを展開してリアルタイムで予測や意思決定を行う重要なフェーズです。このプロセスは、即時応答を必要とするアプリケーション(チャットボットや自動運転車など)において不可欠で、こうしたケースで安全性と効率性に関わっているのは、入力データを処理して出力を迅速に生成する機能です。

AI 推論の概要

AI 推論とは、トレーニングされた機械学習モデルが入力データを取得し、予測や決定などの出力を生成するプロセスです。大規模なデータセットをアルゴリズムにフィードしてパターンや関係を学習するトレーニングフェーズとは異なり、推論はその学習した知識を新たな未知のデータに適用するものです。この点を区別しておくことは、実際のアプリケーションにおける AI 推論の役割を理解するうえで重要です。たとえば、自律走行車では、モデルはセンサーデータをリアルタイムで処理して、ステアリング、ブレーキ、アクセルに関する判断を行う必要があり、これらすべてで低レイテンシーかつ高精度であることが求められます。

チャットボットの分野では、AI 推論により、自然言語処理(NLP)が対話方式でユーザーのクエリーを理解し、応答できるようになります。このリアルタイムの意思決定のおかげで、チャットボットや仮想アシスタントなどの AI アプリケーションは強力で使いやすいものになっています。見たことのないデータを処理し、正確な予測を行う能力は、トレーニングされた AI モデルの堅牢性と推論プロセスの効率性の証です。

AI トレーニングと AI 推論

AI システムの開発には、AI のトレーニングフェーズと推論という 2 つの主要なフェーズがあります。AI トレーニングフェーズでは、大規模なデータセットを AI モデルにフィードし、パターンの学習と特定を行います。多くの場合、モデルではエラーを最小限に抑えるためにパラメーターを反復的に調整する必要があるため、このプロセスには膨大な計算リソースと時間が必要になります。ディープラーニングにおけるニューラルネットワークなど、トレーニングで使用されるアルゴリズムは、トレーニングデータに対してモデルのパフォーマンスを最適化するように設計されています。

一方、AI 推論は、トレーニングされたモデルを使用して、新しい受信データに基づく予測や意思決定を行う展開のフェーズです。自律走行車やリアルタイムの意思決定システムなどのアプリケーションにおいては、遅延が悪影響を及ぼす可能性があるため、低レイテンシーとリアルタイムパフォーマンスに重点が置かれます。一般的に、推論用の計算要件はトレーニング用の要件よりも低いですが、GPU(画像処理装置)や CPU(中央処理装置)などのプロセッサーを効率的に使用して、高いパフォーマンスと短い応答時間を確保する必要があります。AI のトレーニングと推論の詳細については、機械学習のトレーニングと推論の概要をご覧ください。

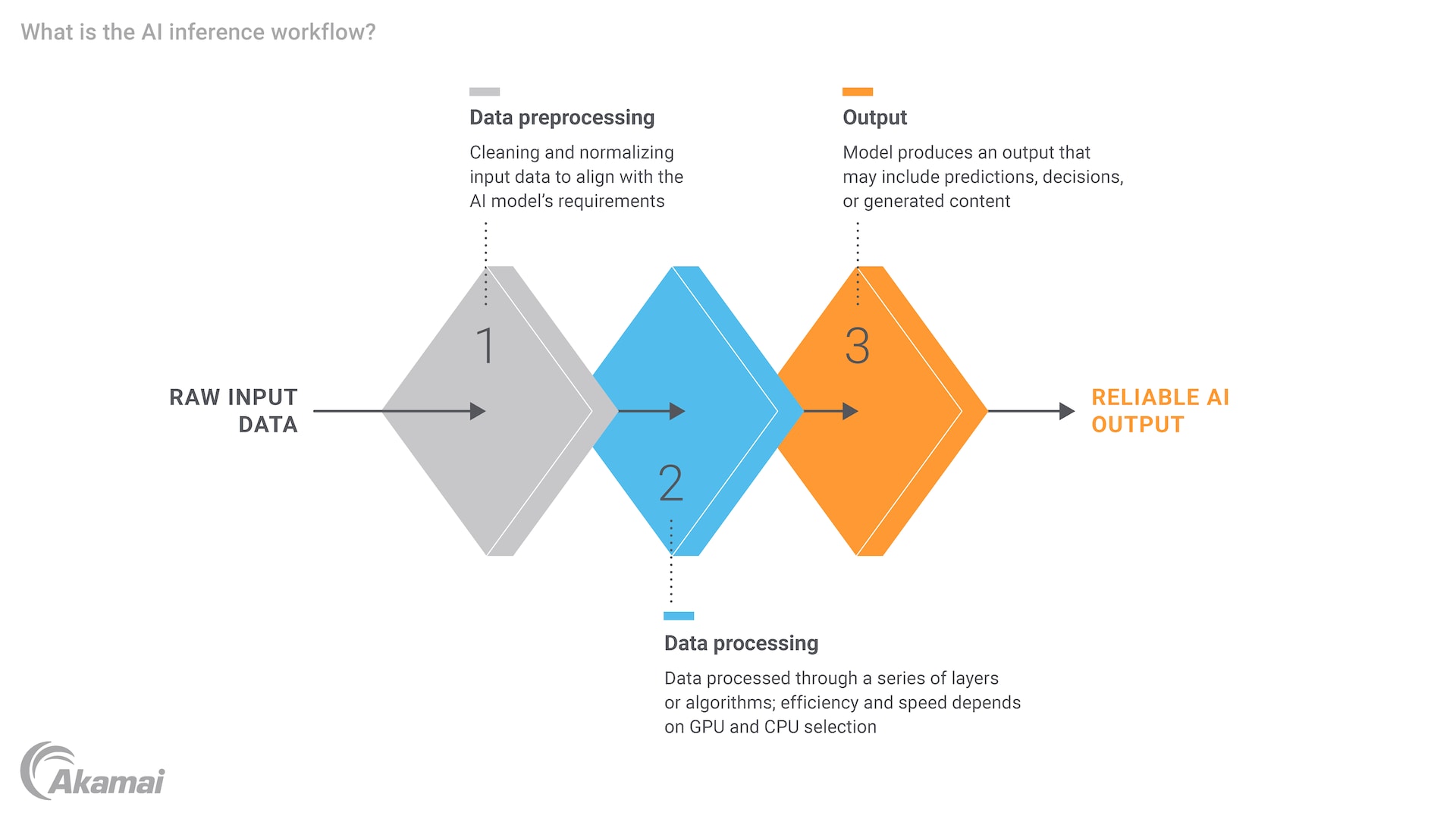

AI 推論のステップ

AI 推論のプロセスにはいくつかの重要なステップがあり、それぞれに計算リソースと効率性を慎重に考慮する必要があります。まず、入力データがモデルに適した形式となるように、入力データを前処理する必要があります。これには、データの正規化、テキストの数値ベクトルへの変換、画像のサイズ変更などが含まれます。データの準備が整うと、トレーニング済みの AI モデルにフィードされ、入力が処理されて出力が生成されます。出力は予測、分類、決定などで、アプリケーションに応じて異なります。

たとえば、ヘルスケア分野であれば、医療画像を基に病気を診断するよう AI モデルをトレーニングすることも可能です。推論中に、モデルは患者の新しい画像を処理して診断を提供し、ヘルスケア専門家がそれを精査するというものです。遅延やエラーは深刻な結果を招く可能性があるため、プロセス全体が効率的かつ正確でなければなりません。特に、モデルが大規模なデータセットや複雑なタスクを処理しなければならないシナリオでは、計算能力と計算リソースの必要性は明白です。

AI 推論エンジンの役割

AI 推論エンジンは、トレーニングされた AI モデルの実行を管理し、低レイテンシーと高パフォーマンスのワークロードを最適化するソフトウェアコンポーネントです。このエンジンは、入力データの処理と出力の生成というコンピューティング負荷の高いタスクを処理するように設計されており、モデルがリアルタイム環境で効率的に動作できるようにします。GPU や CPU などのハードウェアの進歩により、推論エンジンの機能が大幅に強化され、ますます複雑かつデータ量の多いタスクを処理できるようになりました。

たとえば、NVIDIA は GPU を使用して AI 推論の分野に大きく貢献しており、特に並列処理タスクに適しています。これらの GPU は推論のレイテンシーを大幅に低減できるため、リアルタイムの意思決定を必要とするアプリケーションに最適です。さらに、エッジコンピューティングの台頭により、AI 推論の可能性は一層拡大しました。データソースの近くで処理を実行できるようになり、データを集約型データセンターに移動する必要性が低くなり、全体的なパフォーマンスが向上しました。

AI 推論の例とユースケース

AI 推論には、さまざまなセクターにわたる幅広いアプリケーションがあり、それぞれがトレーニングされた AI モデルの能力を活用して特定の問題を解決します。医療業界では、AI 推論は病気の診断、創薬、患者の監視に使用されます。たとえば、医療画像データに関するトレーニングを行ったディープ・ラーニング・モデルを使用すれば、がんや肺炎などの病気を迅速かつ正確に診断でき、医療の専門家に貴重な知見を提供できます。

モノのインターネット(IoT)では、AI 推論はスマートデバイスが自律的な判断を行えるようにするうえで重要な役割を果たします。たとえば、スマート・ホーム・システムでは、AI 推論を使用して、居住パターンに基づいて冷暖房を調整し、スマートシティでは交通の流れの最適化や渋滞の軽減に AI 推論を利用します。AI 機能、特にオブジェクト検知の進歩により、こうしたシステムはさらに強化されています。これらのシステムをシームレスに運用するためには、データをリアルタイムで処理して対応する能力が不可欠です。

AI 推論の応用としてもう 1 つ注目すべきは、生成 AI と大規模言語モデル(LLM)の分野です。ディープラーニングやニューラルネットワークに基づく ChatGPT のようなモデルは、推論を使用して、ユーザーの入力に応答して人間のようなテキストを生成します。これにより、自然言語処理の新たな可能性が開かれました。今後さらに、AI システムとの関わり方に変革をもたらし、AI システムがより直感的で使いやすいものとなっていく可能性があります。

結論

AI 推論は、最新の AI ソリューションの重要なコンポーネントであり、リアルタイムの意思決定と、トレーニングされたモデルの未知の新しいデータへの適用を可能にします。トレーニングと推論の各フェーズに固有の要件と課題があるため、それぞれの違いを理解しておくことは非常に重要です。トレーニングにはモデルの構築と最適化が含まれますが、推論では、これらのモデルを展開して正確かつタイムリーな予測を行うことに重点を置いています。

GPU やエッジコンピューティングなどのハードウェアの進歩と、最適化された推論エンジンの開発により、AI 推論の未来は明るいと考えられます。これらの進歩は、AI システムのスケーラビリティを向上させるだけでなく、データに関する新たな課題や複雑化するタスクへの対応も可能にします。AI の進化に伴い、さまざまな業界でイノベーションが推進され、新たな可能性が開拓されているとともに、効率的で低レイテンシーの推論の重要性は高まり続けています。

よくあるご質問

AI モデルのトレーニングでは、大規模なデータセットをアルゴリズムにフィードしてパターンの学習と特定を行います。これには膨大な計算リソースと時間が必要です。一方、AI 推論は、トレーニングされたモデルが新しいデータを処理して予測や意思決定を行う展開フェーズであり、低レイテンシーとリアルタイムパフォーマンスに重点を置いています。

AI 推論では、入力データを適切な形式になるよう前処理し、データをトレーニング済みモデルにフィードして、予測、分類、決定などの出力を生成するというステップが重要になります。各ステップでは、計算リソースと効率性を慎重に考慮する必要があります。AI が効果的に動作し、さまざまなデータ入力とやり取りできるようにするためには、適切なアーキテクチャとデータシステムを実装することが不可欠です。

AI 推論エンジンは、トレーニングされた AI モデルの実行を管理し、低レイテンシーと高パフォーマンスのワークロードを最適化するソフトウェアコンポーネントです。入力データの処理や出力の生成というコンピューティング負荷の高いタスクを処理し、多くの場合 GPU を使用して効率的なリアルタイム運用を実現します。

自律走行車、チャットボット、スマートデバイスなど、リアルタイムの意思決定を必要とするアプリケーションでは遅延が悪影響を及ぼす可能性があるため、AI 推論では低レイテンシーであることが重要になります。短い応答時間により、システムはスムーズかつ安全に動作します。

AI 推論は、医療(病気の診断、創薬など)、IoT(スマート・ホーム・システム、スマートシティなど)、生成 AI(たとえば ChatGPT などの LLM)など、さまざまなセクターで使用されています。これらのアプリケーションは、トレーニングされた機械学習モデルの能力を活用して、特定の問題をリアルタイムで解決します。

GPU と CPU は、入力データを処理して効率的に出力を生成するために必要な計算能力を提供するため、AI 推論に不可欠です。特に GPU は並列処理タスクに適しており、推論のレイテンシーを大幅に低減できます。

エッジコンピューティングにより、AI 推論をデータソースの近くで実行できるため、データを集約型データセンターに移動する必要性が低くなります。これにより、レイテンシーが短縮され、AI システムのリアルタイム機能が強化されることで、全体的なパフォーマンスが向上し、効率性と応答性が向上します。

はい、AI 推論は医療業界で広く活用されており、病気の診断、創薬、患者監視などのアプリケーションに使用されています。たとえば、医療画像データに関するトレーニングを行ったディープ・ラーニング・モデルを使用すれば、がんや肺炎などの病気を迅速かつ正確に診断でき、医療の専門家に貴重な知見を提供できます。

AI 推論は、IoT デバイスがリアルタイムデータに基づいて自律的に意思決定できるようにすることで、IoT デバイスの機能を強化します。たとえば、スマート・ホーム・システムでは、AI 推論を使用して、居住パターンに基づいて冷暖房を調整し、スマートシティでは交通の流れの最適化や渋滞の軽減に AI 推論を活用することができます。

Akamai が選ばれる理由

Akamai は、オンラインビジネスの力となり、守るサイバーセキュリティおよびクラウドコンピューティング企業です。市場をリードするセキュリティソリューション、優れた脅威インテリジェンス、そして世界中の運用チームが、あらゆるところで企業のデータとアプリケーションを多層防御で守ります。Akamai のフルスタック・クラウドコンピューティング・ソリューションは、世界で最も分散されたプラットフォーム上で、パフォーマンスと手頃な価格を両立します。安心してビジネスを展開できる業界トップクラスの信頼性、スケール、専門知識の提供により、Akamai は、あらゆる業界のグローバル企業から信頼を獲得しています。