La inferencia de IA es el proceso mediante el cual un modelo de IA entrenado con conjuntos de datos seleccionados toma los datos de entrada y produce un resultado, como una predicción o una decisión. Es la aplicación de los conocimientos adquiridos en la fase de entrenamiento a datos nuevos y no vistos.

La inteligencia artificial (IA) ha revolucionado numerosos sectores, desde la atención sanitaria hasta los vehículos autónomos, al permitir que los sistemas tomen decisiones inteligentes basadas en datos. En el núcleo de estos sistemas de IA se encuentra el proceso de inferencias de IA, una fase crítica en la que se implementan modelos de IA entrenados para realizar predicciones o decisiones en tiempo real. Este proceso es esencial para aplicaciones que requieren respuestas inmediatas, como chatbots y coches autónomos, donde la capacidad de procesar datos de entrada y generar resultados rápidamente puede ser una cuestión de seguridad y eficiencia.

Introducción a la inferencia de IA

La inferencia de IA es el proceso mediante el cual un modelo de aprendizaje automático entrenado toma los datos de entrada y genera un resultado, como una predicción o una decisión. A diferencia de la fase de entrenamiento, que implica introducir grandes conjuntos de datos en un algoritmo para aprender patrones y relaciones, la inferencia es la aplicación de ese conocimiento aprendido a datos nuevos y no vistos. Esta distinción es crucial para comprender el papel de la inferencia de IA en las aplicaciones del mundo real. Por ejemplo, en los vehículos autónomos, el modelo debe procesar los datos del sensor en tiempo real para tomar decisiones sobre la dirección, el frenado y la aceleración, lo que requiere una latencia baja y una precisión alta.

En el ámbito de los chatbots, la inferencia de IA permite que el procesamiento del lenguaje natural (NLP) comprenda y responda a las consultas de los usuarios de forma conversacional. Esta toma de decisiones en tiempo real es lo que hace que las aplicaciones de IA, como chatbots y asistentes virtuales, sean tan potentes y fáciles de usar. La capacidad de gestionar datos no vistos y realizar predicciones precisas es un testimonio de la solidez del modelo de IA entrenado y de la eficiencia del proceso de inferencia.

Entrenamiento de IA frente a inferencias de IA

El desarrollo de sistemas de IA implica dos fases principales: la fase de entrenamiento de IA y las inferencias. Durante la fase de entrenamiento de IA, los modelos de IA se alimentan de grandes conjuntos de datos para aprender e identificar patrones. Este proceso a menudo requiere importantes recursos computacionales y tiempo, ya que el modelo debe ajustar iterativamente sus parámetros para minimizar los errores. Los algoritmos utilizados en el entrenamiento, como las redes neuronales de aprendizaje profundo, están diseñados para optimizar el rendimiento del modelo en los datos de entrenamiento.

Por el contrario, las inferencias de IA son la fase de implementación en la que el modelo entrenado se utiliza para realizar predicciones o decisiones basadas en nuevos datos entrantes. La atención se centra en la baja latencia y el rendimiento en tiempo real, ya que los retrasos pueden ser perjudiciales en aplicaciones como los vehículos autónomos y los sistemas de toma de decisiones en tiempo real. Las exigencias computacionales para las inferencias son generalmente inferiores a las del entrenamiento, pero todavía requieren un uso eficiente de procesadores, como GPU (unidades de procesamiento gráfico) y CPU (unidades de procesamiento central), para garantizar un alto rendimiento y unos tiempos de respuesta rápidos. Para obtener más información sobre la inferencia y el entrenamiento de IA, lea nuestra introducción al entrenamiento y la inferencia en el aprendizaje automático.

Pasos en la inferencia de IA

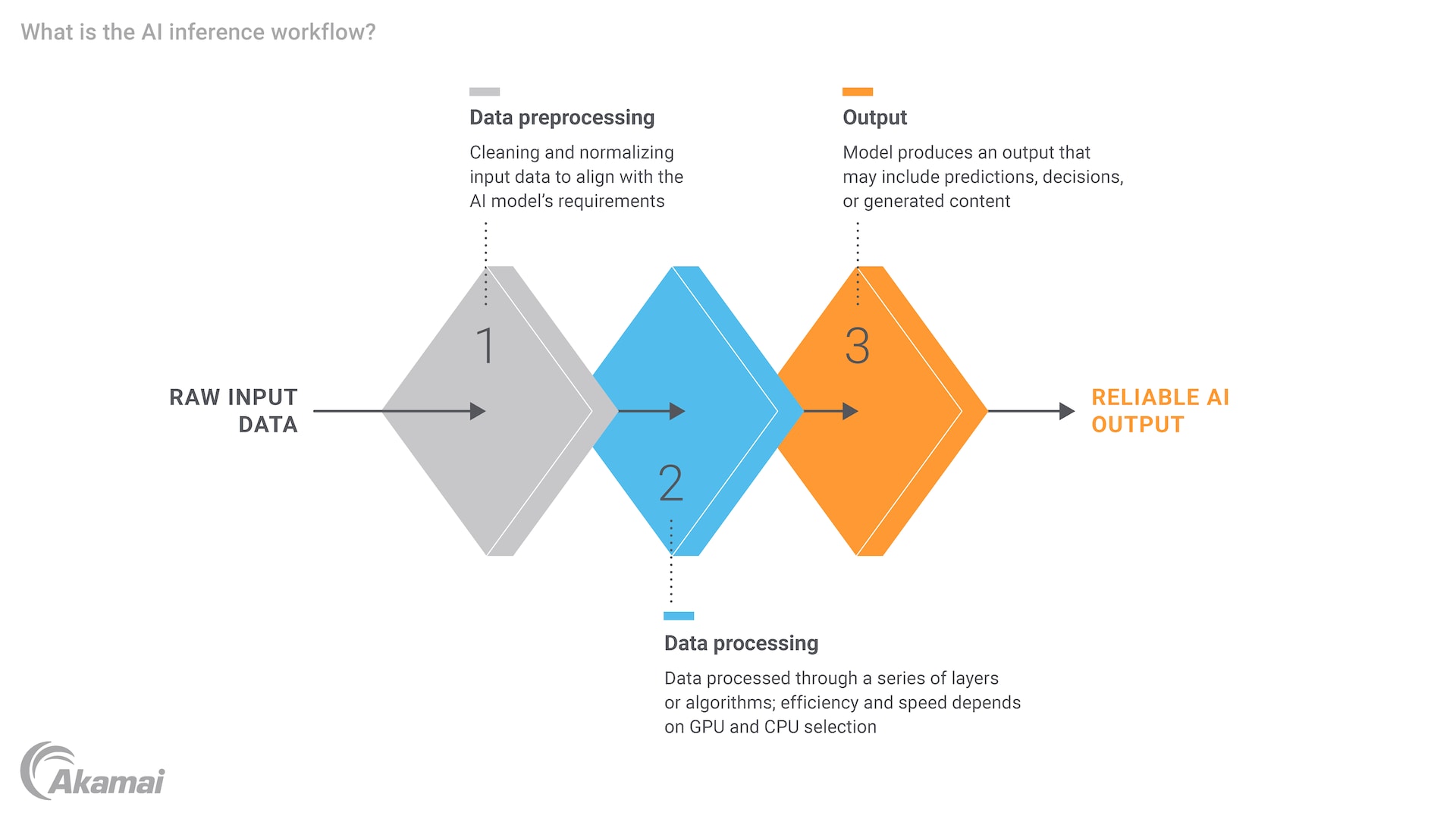

El proceso de inferencia de IA implica varios pasos clave, cada uno de los cuales requiere una cuidadosa consideración de los recursos computacionales y su eficiencia. En primer lugar, los datos de entrada deben procesarse previamente para garantizar que están en un formato adecuado para el modelo. Esto puede implicar la normalización de datos, la conversión de texto en vectores numéricos o el cambio de tamaño de las imágenes. Una vez preparados los datos, se introducen en el modelo de IA entrenado, que procesa la entrada y genera un resultado. Este resultado podría ser una predicción, una clasificación o una decisión, en función de la aplicación.

Por ejemplo, en un entorno sanitario, se podría entrenar un modelo de IA para diagnosticar enfermedades a partir de imágenes médicas. Durante la inferencia, el modelo procesaría la imagen de un nuevo paciente y proporcionaría un diagnóstico, que luego podría ser revisado por un profesional de la salud. Todo el proceso debe ser eficiente y preciso, ya que los retrasos o errores pueden tener consecuencias graves. La necesidad de potencia de cálculo y recursos informáticos es evidente, especialmente en situaciones en las que el modelo debe gestionar grandes conjuntos de datos y tareas complejas.

El papel de los motores de inferencia de IA

Un motor de inferencia de IA es un componente de software que gestiona la ejecución de modelos de IA entrenados, optimizando las cargas de trabajo de baja latencia y alto rendimiento. Estos motores están diseñados para gestionar las tareas de procesamiento intensivo de los datos de entrada y la generación de resultados, lo que garantiza que el modelo pueda funcionar de forma eficiente en entornos en tiempo real. Los avances en el hardware, como las GPU y las CPU, han mejorado significativamente las capacidades de los motores de inferencia, permitiéndoles gestionar tareas cada vez más complejas y con un uso intensivo de datos.

Por ejemplo, NVIDIA ha realizado contribuciones significativas en el campo de la inferencia de IA con sus GPU, que son especialmente adecuadas para tareas de procesamiento en paralelo. Estas GPU pueden reducir significativamente la latencia de inferencia, lo que las hace ideales para aplicaciones que requieren una toma de decisiones en tiempo real. Además, el auge del edge computing ha ampliado aún más el potencial de la inferencia de IA, lo que permite que el procesamiento se produzca más cerca de la fuente de datos, reduciendo la necesidad de que los datos se desplacen a los centros de datos centralizados y mejorando el rendimiento general.

Ejemplos y casos de uso de inferencia de IA

La inferencia de IA tiene una amplia gama de aplicaciones en varios sectores, cada una de las cuales aprovecha la potencia de los modelos de IA entrenados para resolver problemas específicos. En la atención sanitaria, la inferencia de IA se utiliza para el diagnóstico de enfermedades, el descubrimiento de fármacos y la monitorización de los pacientes. Por ejemplo, un modelo de aprendizaje profundo entrenado en datos de imágenes médicas puede diagnosticar de forma rápida y precisa enfermedades como el cáncer o la neumonía, lo que proporciona información valiosa a los profesionales sanitarios.

En el Internet de las cosas (IoT), la inferencia de IA desempeña un papel crucial a la hora de permitir que los dispositivos inteligentes tomen decisiones autónomas. Por ejemplo, un sistema domótico inteligente podría utilizar la inferencia de IA para ajustar la calefacción y la refrigeración en función de los patrones de ocupación, o una ciudad inteligente podría utilizarla para optimizar el flujo de tráfico y reducir los atascos. Los avances en las capacidades de IA, especialmente en la detección de objetos, han mejorado aún más estos sistemas. La capacidad de procesar y responder a los datos en tiempo real es esencial para el funcionamiento perfecto de estos sistemas.

Otra aplicación notable de la inferencia de IA es en el ámbito de la IA generativa y los modelos lingüísticos grandes (LLM). Modelos como ChatGPT, que se basan en el aprendizaje profundo y las redes neuronales, utilizan la inferencia para generar texto similar al humano en respuesta a las entradas de los usuarios. Esto ha abierto nuevas posibilidades para el procesamiento del lenguaje natural y tiene el potencial de transformar la forma en que interactuamos con los sistemas de IA, haciéndolos más intuitivos y fáciles de usar.

Conclusión

La inferencia de IA es un componente fundamental de las soluciones de IA modernas, que permite la toma de decisiones en tiempo real y la aplicación de modelos entrenados a datos nuevos e invisibles. Es esencial entender la distinción entre entrenamiento e inferencia, ya que cada fase tiene su propio conjunto de requisitos y desafíos. Aunque el entrenamiento implica la creación y optimización de modelos, la inferencia se centra en la implementación de estos modelos para realizar predicciones precisas y puntuales.

El futuro de las inferencias de IA parece prometedor, con avances en hardware, como las GPU y el edge computing, y el desarrollo de motores de inferencia optimizados. Estos avances no solo mejorarán la escalabilidad de los sistemas de IA, sino que también les permitirán afrontar nuevos desafíos relacionados con unos datos y tareas cada vez más complejos. A medida que la IA siga evolucionando, la importancia de la inferencia eficiente y de baja latencia no hará más que crecer, impulsando la innovación y abriendo nuevas posibilidades en diversos sectores.

Preguntas frecuentes

El entrenamiento de un modelo de IA implica introducir grandes conjuntos de datos en un algoritmo para aprender e identificar patrones, lo que requiere una cantidad significativa de recursos computacionales y tiempo. Por otro lado, la inferencia de IA es la fase de implementación en la que el modelo entrenado procesa nuevos datos para realizar predicciones o decisiones, centrándose en la baja latencia y el rendimiento en tiempo real.

Los pasos clave en la inferencia de IA incluyen el procesamiento previo de los datos de entrada para garantizar que están en un formato adecuado, la introducción de los datos en el modelo entrenado y la generación de un resultado, como una predicción, clasificación o decisión. Cada paso requiere una cuidadosa consideración de los recursos computacionales y su eficiencia. Implementar la arquitectura y los sistemas de datos adecuados es esencial para garantizar que la IA pueda operar e interactuar de forma eficaz con diversas entradas de datos.

Un motor de inferencia de IA es un componente de software que gestiona la ejecución de modelos de IA entrenados, optimizando las cargas de trabajo de baja latencia y alto rendimiento. Gestiona las tareas intensivas de procesamiento de datos de entrada y generación de resultados, a menudo utilizando las GPU para garantizar un funcionamiento eficiente en tiempo real.

La baja latencia es crucial en la inferencia de IA, ya que los retrasos pueden ser perjudiciales en aplicaciones que requieren una toma de decisiones en tiempo real, como vehículos autónomos, chatbots y dispositivos inteligentes. Los tiempos de respuesta rápidos garantizan que el sistema pueda funcionar sin problemas y de forma segura.

La inferencia de IA se utiliza en varios sectores, incluidos el de la atención sanitaria (p. ej., diagnóstico de enfermedades, descubrimiento de fármacos), el IoT (p. ej., sistemas domésticos inteligentes, ciudades inteligentes) y la IA generativa (p. ej., los LLM como ChatGPT). Estas aplicaciones aprovechan la potencia de los modelos de aprendizaje automático entrenados para resolver problemas específicos en tiempo real.

Las GPU y CPU son esenciales para la inferencia de IA, ya que proporcionan la potencia computacional necesaria para procesar los datos de entrada y generar resultados de forma eficiente. Las GPU, en particular, son adecuadas para tareas de procesamiento en paralelo, que pueden reducir significativamente la latencia de inferencia.

El edge computing permite que la inferencia de IA se produzca más cerca de la fuente de datos, lo que reduce la necesidad de que los datos se desplacen a centros de datos centralizados. Esto mejora el rendimiento general al reducir la latencia y mejorar las capacidades en tiempo real de los sistemas de IA, lo que los hace más eficientes y con mayor capacidad de respuesta.

Sí, la inferencia de IA se utiliza ampliamente en la atención sanitaria para aplicaciones como el diagnóstico de enfermedades, el descubrimiento de fármacos y la monitorización de pacientes. Por ejemplo, un modelo de aprendizaje profundo entrenado en datos de imágenes médicas puede diagnosticar de forma rápida y precisa enfermedades como el cáncer o la neumonía, lo que proporciona información valiosa a los profesionales sanitarios.

La inferencia de IA mejora las capacidades de los dispositivos IoT al permitirles tomar decisiones autónomas basadas en datos en tiempo real. Por ejemplo, un sistema domótico inteligente puede utilizar la inferencia de IA para ajustar la calefacción y la refrigeración en función de los patrones de ocupación, o una ciudad inteligente puede optimizar el flujo de tráfico y reducir los atascos.

Por qué los clientes eligen Akamai

Akamai es la empresa de ciberseguridad y cloud computing que potencia y protege los negocios online. Nuestras soluciones de seguridad líderes en el mercado, nuestra inteligencia ante amenazas consolidada y nuestro equipo de operaciones globales proporcionan una defensa en profundidad para proteger los datos y las aplicaciones empresariales. Las soluciones integrales de cloud computing de Akamai garantizan el rendimiento y una buena relación calidad-precio en la plataforma más distribuida del mundo. Las grandes empresas confían en Akamai, ya que les ofrece una fiabilidad, una escalabilidad y una experiencia inigualables en el sector, idóneas para crecer con seguridad.