Inferência de IA é o processo pelo qual um modelo de IA treinado em conjuntos de dados selecionados coleta dados de entrada e produz um resultado, como uma previsão ou uma decisão. É a aplicação do conhecimento aprendido da fase de treinamento em novos dados não observados.

A inteligência artificial (IA) revolucionou vários setores, da saúde aos veículos autônomos, permitindo que os sistemas tomem decisões inteligentes com base em dados. No centro desses sistemas de IA está o processo de inferência de IA, uma fase crítica em que modelos de IA treinados são implantados para fazer previsões ou decisões em tempo real. Esse processo é essencial para aplicações que exigem respostas imediatas, como chatbots e carros autônomos, em que a capacidade de processar dados de entrada e gerar resultados rapidamente pode ser uma questão de segurança e eficiência.

Introdução à inferência de IA

Inferência de IA é o processo pelo qual um modelo de aprendizado de máquina treinado obtém dados de entrada e produz um resultado, como uma previsão ou uma decisão. Ao contrário da fase de treinamento, que envolve a alimentação de grandes conjuntos de dados em um algoritmo para aprender padrões e relacionamentos, a inferência é a aplicação desse conhecimento aprendido a dados novos e invisíveis. Essa distinção é crucial para entender o papel da inferência de IA em aplicações reais. Por exemplo, em veículos autônomos, o modelo deve processar dados do sensor em tempo real para tomar decisões sobre direção, frenagem e aceleração, tudo isso exigindo baixa latência e alta precisão.

No campo dos chatbots, a inferência de IA permite que o processamento de linguagem natural (PLN) entenda e responda às perguntas dos usuários de forma conversacional. Essa tomada de decisões em tempo real é o que torna aplicações de IA como chatbots e assistentes virtuais tão poderosos e fáceis de usar. A capacidade de lidar com dados invisíveis e fazer previsões precisas é um testemunho da robustez do modelo de IA treinado e da eficiência do processo de inferência.

Treinamento de IA vs. Inferência de IA

O desenvolvimento de sistemas de IA envolve duas fases principais: a fase de treinamento de IA e a inferência. Durante a fase de treinamento de IA, os modelos de IA recebem grandes conjuntos de dados para aprender e identificar padrões. Esse processo geralmente requer recursos computacionais e tempo significativos, pois o modelo deve ajustar iterativamente seus parâmetros para minimizar erros. Os algoritmos usados no treinamento, como redes neurais de aprendizagem profunda, são projetados para otimizar o desempenho do modelo nos dados de treinamento.

Por outro lado, a inferência de IA é a fase de implantação em que o modelo treinado é usado para fazer previsões ou decisões com base em dados novos e recebidos. O foco aqui é a baixa latência e o desempenho em tempo real, pois os atrasos podem ser prejudiciais em aplicações como veículos autônomos e sistemas de tomada de decisões em tempo real. Os requisitos computacionais para inferência são geralmente menores do que os do treinamento, mas ainda exigem uso eficiente de processadores, como GPUs (unidades de processamento gráfico) e CPUs (unidades de processamento central), para garantir alto desempenho e tempos de resposta rápidos. Para saber mais sobre treinamento e inferência de IA, leia nossa introdução ao treinamento de aprendizado de máquina e inferência.

Etapas na inferência de IA

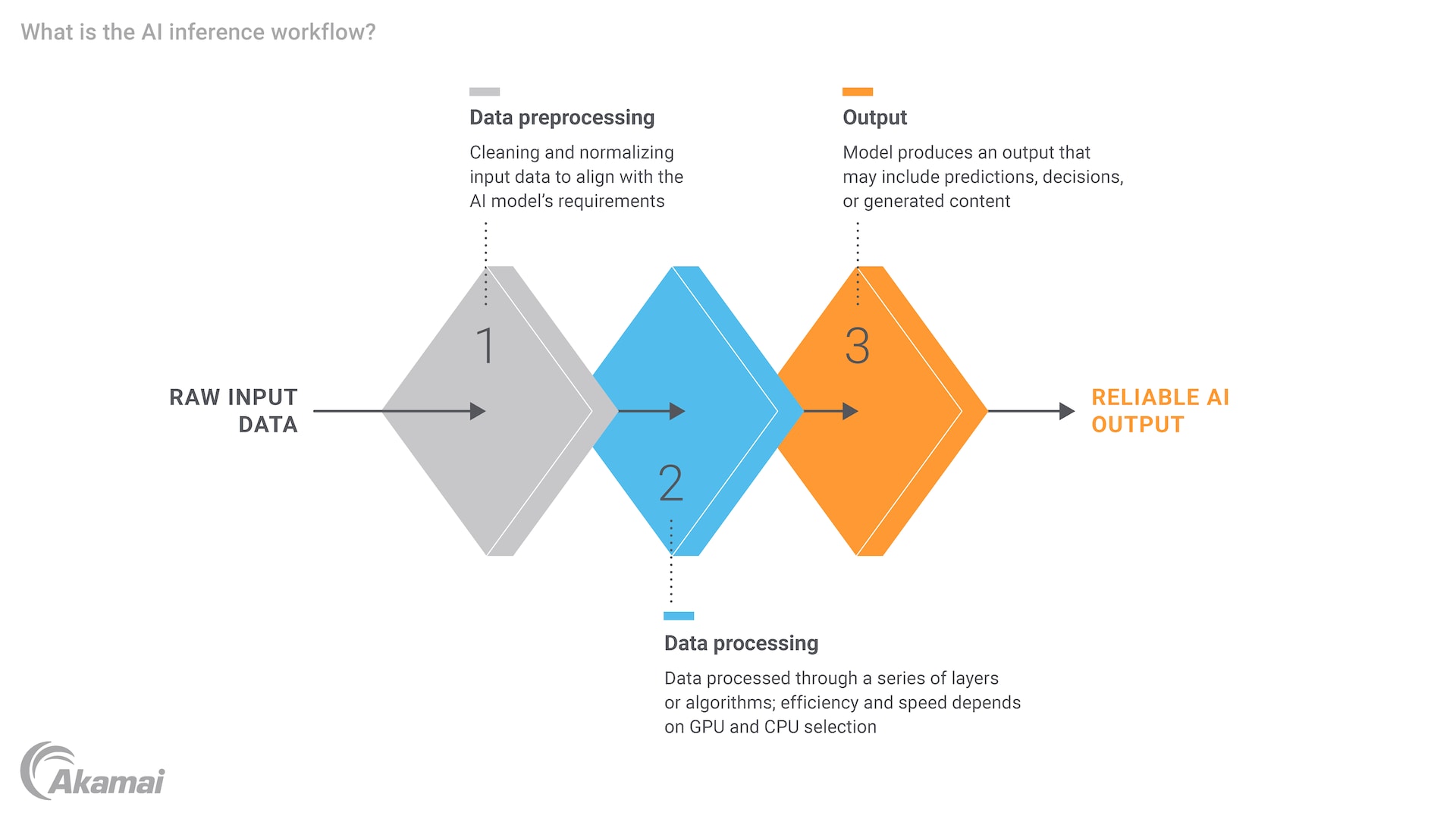

O processo de inferência de IA envolve várias etapas importantes, cada uma exigindo uma consideração cuidadosa dos recursos computacionais e da eficiência. Primeiro, os dados de entrada devem ser pré-processados para garantir que estejam em um formato adequado para o modelo. Isso pode envolver a normalização de dados, a conversão de texto em vetores numéricos ou o redimensionamento de imagens. Depois que os dados são preparados, eles são inseridos no modelo de IA treinado, que processa a entrada e gera uma saída. Esse resultado pode ser uma previsão, uma classificação ou uma decisão, dependendo da aplicação.

Por exemplo, em um ambiente de saúde, um modelo de IA pode ser treinado para diagnosticar doenças com base em imagens médicas. Durante a inferência, o modelo processaria a imagem de um novo paciente e forneceria um diagnóstico, que poderia então ser revisado por um profissional de saúde. Todo o processo deve ser eficiente e preciso, pois atrasos ou erros podem ter consequências graves. A necessidade de poder e recursos de computação é evidente, especialmente em situações em que o modelo deve lidar com grandes conjuntos de dados e tarefas complexas.

O papel dos mecanismos de inferência de IA

Um mecanismo de inferência de IA é um componente de software que gerencia a execução de modelos de IA treinados, otimizando cargas de trabalho de baixa latência e alto desempenho de workload. Esses mecanismos são projetados para lidar com as tarefas de processamento intensivo de dados de entrada e geração de resultados, garantindo que o modelo possa operar de forma eficiente em ambientes em tempo real. Os avanços no hardware, como GPUs e CPUs, melhoraram significativamente os recursos dos mecanismos de inferência, permitindo que eles lidem com tarefas cada vez mais complexas e com uso intenso de dados.

Por exemplo, a NVIDIA fez contribuições significativas para o campo de inferência de IA com suas GPUs, que são particularmente adequadas para tarefas de processamento paralelo. Essas GPUs podem reduzir significativamente a latência de inferência, tornando-as ideais para aplicações que exigem tomada de decisões em tempo real. Além disso, o aumento da edge computing expandiu ainda mais o potencial de inferência de IA, permitindo que o processamento ocorra mais próximo da fonte de dados, reduzindo a necessidade de os dados viajarem para data centers centralizados e melhorando o desempenho geral.

Exemplos e casos de uso de inferência de IA

A inferência de IA tem uma grande variedade de aplicações em vários setores, cada um aproveitando o poder de modelos de IA treinados para resolver problemas específicos. Na área da saúde, a inferência de IA é usada para diagnóstico de doenças, descoberta de medicamentos e monitoramento de pacientes. Por exemplo, um modelo de aprendizagem profunda treinada em dados de imagens médicas pode diagnosticar de forma rápida e precisa condições como câncer ou pneumonia, fornecendo informações valiosas aos profissionais de saúde.

Na Internet das coisas (IoT), a inferência de IA desempenha um papel crucial ao capacitar os dispositivos inteligentes a tomar decisões autônomas. Por exemplo, um sistema de casa inteligente pode usar inferência de IA para ajustar o aquecimento e o resfriamento com base em padrões de ocupação, ou uma cidade inteligente pode usá-lo para otimizar o fluxo de tráfego e reduzir o congestionamento. Os avanços nos recursos de IA, particularmente na detecção de objetos, melhoraram ainda mais esses sistemas. A capacidade de processar e responder aos dados em tempo real é essencial para a operação contínua desses sistemas.

Outra aplicação notável da inferência de IA é no campo da IA generativa e dos grandes modelos de linguagem (LLMs). Modelos como ChatGPT, que são baseados em aprendizagem profunda e redes neurais, usam inferência para gerar texto semelhante ao humano em resposta às entradas do usuário. Isso abriu novas possibilidades para o processamento de linguagem natural e tem o potencial de transformar a forma como interagimos com sistemas de IA, tornando-os mais intuitivos e fáceis de usar.

Conclusão

A inferência de IA é um componente essencial das soluções de IA modernas, permitindo a tomada de decisões em tempo real e a aplicação de modelos treinados a dados novos e não observados. A distinção entre treinamento e inferência é essencial para entender, pois cada fase tem seu próprio conjunto de requisitos e desafios. Embora o treinamento envolva a criação e a otimização de modelos, a inferência se concentra na implantação desses modelos para fazer previsões precisas e oportunas.

O futuro da inferência de IA parece promissor, com avanços em hardware, como GPUs e edge computing, e o desenvolvimento de mecanismos de inferência otimizados. Esses avanços não só melhorarão a escalabilidade dos sistemas de IA, como também permitirão que eles lidem com novos desafios de dados e tarefas cada vez mais complexas. À medida que a IA continua a evoluir, a importância da inferência eficiente e de baixa latência só crescerá, impulsionando a inovação e abrindo novas possibilidades em vários setores.

Perguntas frequentes

O treinamento de um modelo de IA envolve a alimentação de grandes conjuntos de dados em um algoritmo para aprender e identificar padrões, o que requer recursos computacionais e tempo significativos. Por outro lado, a inferência de IA é a fase de implantação em que o modelo treinado processa novos dados para fazer previsões ou decisões, concentrando-se em baixa latência e desempenho em tempo real.

As principais etapas na inferência de IA incluem o pré-processamento de dados de entrada para garantir que estejam em um formato adequado, a alimentação dos dados no modelo treinado e a geração de um resultado, como previsão, classificação ou decisão. Cada etapa requer uma consideração cuidadosa dos recursos computacionais e da eficiência. A implementação da arquitetura e dos sistemas de dados corretos é essencial para garantir que a IA possa operar e interagir com eficiência com várias entradas de dados.

Um mecanismo de inferência de IA é um componente de software que gerencia a execução de modelos de IA treinados, otimizando cargas de trabalho de baixa latência e alto desempenho de workload. Ele lida com as tarefas de processamento intensivo de dados de entrada e geração de saídas, frequentemente utilizando GPUs para garantir uma operação eficiente em tempo real.

A baixa latência é crucial na inferência de IA porque os atrasos podem ser prejudiciais em aplicações que exigem tomada de decisões em tempo real, como veículos autônomos, chatbots e dispositivos inteligentes. Os tempos de resposta rápidos garantem que o sistema possa funcionar de forma tranquila e segura.

A inferência de IA é usada em vários setores, incluindo setor de saúde (por exemplo, diagnóstico de doenças, descoberta de medicamentos), Internet das coisas (por exemplo, sistemas de casas inteligentes, cidades inteligentes) e IA generativa (por exemplo, LLMs como o ChatGPT). Essas aplicações aproveitam o poder de modelos de aprendizado de máquina treinados para resolver problemas específicos em tempo real.

GPUs e CPUs são essenciais para a inferência de IA, pois fornecem a potência computacional necessária para processar dados de entrada e gerar resultados com eficiência. As GPUs, em particular, são adequadas para tarefas de processamento paralelo, o que pode reduzir significativamente a latência de inferência.

A edge computing permite que a inferência de IA ocorra mais perto da fonte de dados, reduzindo a necessidade de os dados viajarem para data centers centralizados. Isso melhora o desempenho geral, pois reduz a latência e aprimora os recursos em tempo real dos sistemas de IA, tornando-os mais eficientes e responsivos.

Sim. A inferência de IA é amplamente usada no setor de saúde para aplicações como diagnóstico de doenças, descoberta de medicamentos e monitoramento de pacientes. Por exemplo, um modelo de aprendizagem profunda treinada em dados de imagens médicas pode diagnosticar de forma rápida e precisa condições como câncer ou pneumonia, fornecendo informações valiosas aos profissionais de saúde.

A inferência de IA aprimora os recursos dos dispositivos de Internet das coisas, permitindo que eles tomem decisões autônomas com base em dados em tempo real. Por exemplo, um sistema de casa inteligente pode usar inferência de IA para ajustar o aquecimento e o resfriamento com base em padrões de ocupação, ou uma cidade inteligente pode otimizar o fluxo de tráfego e reduzir o congestionamento.

Por que os clientes escolhem a Akamai

A Akamai é a empresa de cibersegurança e computação em nuvem que potencializa e protege negócios online. Nossas soluções de segurança líderes de mercado, a inteligência avançada contra ameaças e a equipe de operações globais oferecem defesa completa para garantir a segurança de dados e aplicações empresariais em todos os lugares. As abrangentes soluções de computação em nuvem da Akamai oferecem desempenho e acessibilidade na plataforma mais distribuída do mundo. Empresas globais confiam na Akamai para obter a confiabilidade, a escala e a experiência líderes do setor necessárias para expandir seus negócios com confiança.