L'inférence IA est le processus par lequel un modèle d'IA entraîné sur des jeux de données sélectionnés traite les données et produit une sortie, comme une prédiction ou une décision. Il s'agit de l'application des connaissances acquises lors de la phase d'entraînement à de nouvelles données inconnues.

L'intelligence artificielle (IA) a révolutionné de nombreux secteurs, de la santé aux véhicules autonomes, en permettant aux systèmes de prendre des décisions intelligentes basées sur des données. Au cœur de ces systèmes d'IA se trouve le processus d'inférence IA, une phase critique au cours de laquelle des modèles d'IA entraînés sont déployés pour faire des prédictions ou prendre des décisions en temps réel. Ce processus est essentiel pour les applications qui nécessitent des réponses immédiates, telles que les chatbots et les voitures autonomes, où la capacité à traiter rapidement les données d'entrée et à générer des sorties peut être une question de sécurité et d'efficacité.

Introduction à l'inférence IA

L'inférence IA est le processus par lequel un modèle d'apprentissage automatique entraîné traite les données et produit une sortie, comme une prédiction ou une décision. Contrairement à la phase d'entraînement, qui consiste à entrer de grands ensembles de données dans un algorithme pour en déduire des modèles et des relations, l'inférence est l'application de ces connaissances acquises à de nouvelles données encore jamais vues. Cette distinction est cruciale pour comprendre le rôle de l'inférence IA dans les applications réelles. Par exemple, dans les véhicules autonomes, le modèle doit traiter les données des capteurs en temps réel pour prendre des décisions concernant la direction, le freinage et l'accélération, qui nécessitent toutes une faible latence et une grande précision.

Dans le domaine des chatbots, l'inférence IA permet au traitement du langage naturel (NLP) de comprendre et de répondre aux requêtes des utilisateurs de manière conversationnelle. Cette prise de décision en temps réel est ce qui rend les applications d'IA telles que les chatbots et les assistants virtuels si performantes et conviviales. La capacité à traiter des données inconnues et à faire des prédictions précises témoigne de la robustesse du modèle d'IA entraîné et de l'efficacité du processus d'inférence.

Entraînement d'IA vs inférence IA

Le développement de systèmes d'IA implique deux phases principales : la phase d'entraînement de l'IA et l'inférence. Au cours de la phase d'entraînement de l'IA, les modèles sont alimentés par de grands ensembles de données pour apprendre et identifier des modèles. Ce processus nécessite souvent des ressources et un temps de calcul importants, car le modèle doit ajuster ses paramètres de manière itérative pour minimiser les erreurs. Les algorithmes utilisés pour l'entraînement, tels que les réseaux neuronaux d'apprentissage profond, sont conçus pour optimiser les performances du modèle sur les données d'entraînement.

En revanche, l'inférence IA est la phase de déploiement dans laquelle le modèle entraîné est utilisé pour faire des prédictions ou prendre des décisions basées sur de nouvelles données entrantes. Dans ce cas, l'accent est mis sur la faible latence et les performances en temps réel, car les retards peuvent être préjudiciables dans des applications telles que les véhicules autonomes et les systèmes de prise de décision en temps réel. Les exigences de calcul pour l'inférence sont généralement inférieures à celles de l'entraînement, mais elles nécessitent tout de même une utilisation efficace des processeurs, tels que les GPU (processeurs graphiques) et les CPU (processeurs centraux), afin de garantir des performances élevées et des temps de réponse rapides. Pour en savoir plus sur l'entraînement et l'inférence d'IA, consultez notre introduction à l'entraînement et à l'inférence en apprentissage automatique.

Étapes de l'inférence IA

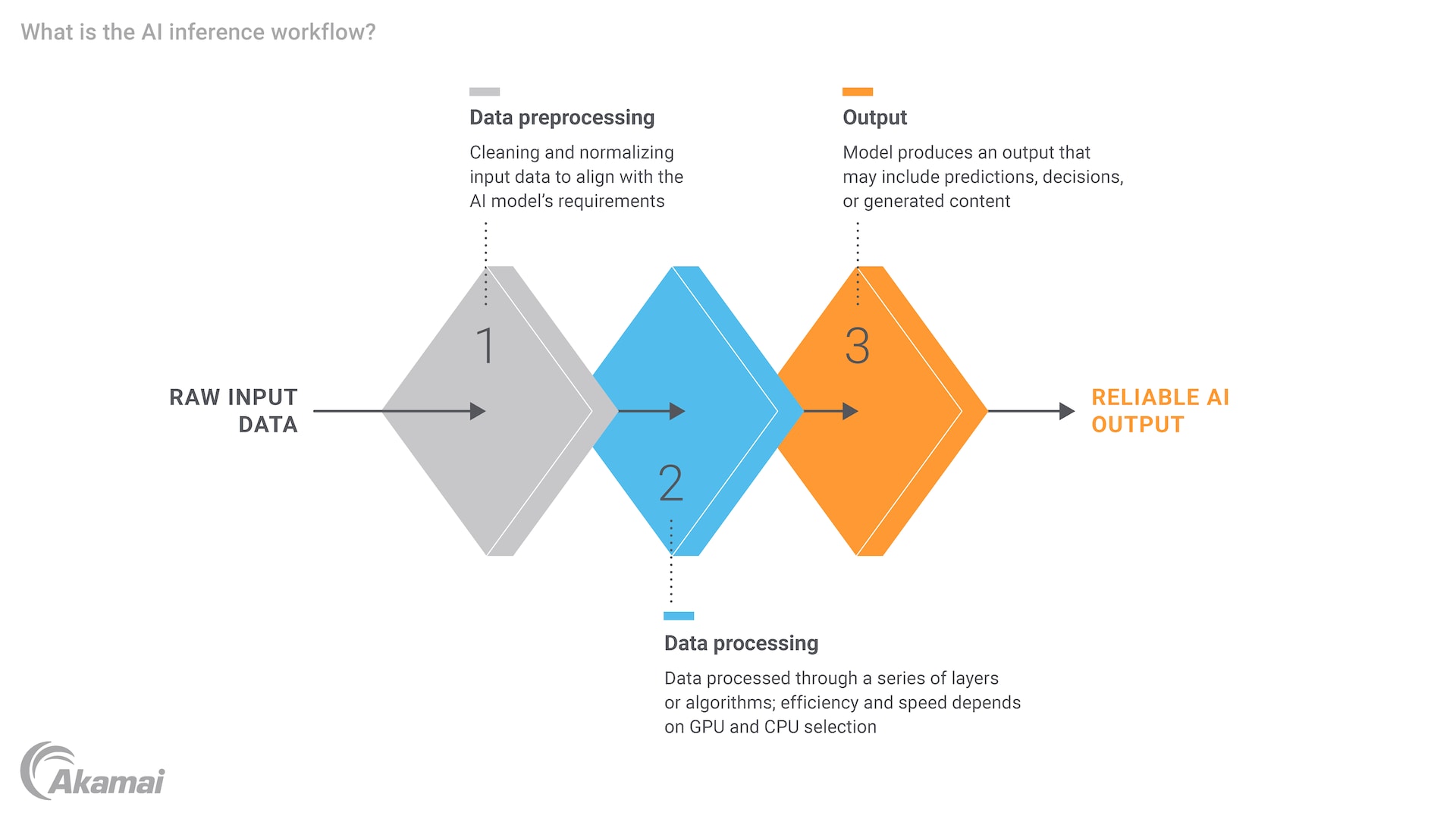

Le processus d'inférence IA comprend plusieurs étapes clés, chacune nécessitant une réflexion approfondie sur les ressources de calcul et leur efficacité. Tout d'abord, les données d'entrée doivent être prétraitées afin de s'assurer qu'elles sont dans un format adapté au modèle. Ce processus peut impliquer la normalisation des données, la conversion du texte en vecteurs digitaux ou le redimensionnement des images. Une fois les données préparées, elles sont transmises au modèle d'IA entraîné, qui traite les données d'entrée et génère une sortie. Cette sortie peut être une prédiction, une classification ou une décision, selon l'application.

Par exemple, dans le domaine de la santé, un modèle d'IA peut être entraîné à diagnostiquer des maladies à partir d'images médicales. Lors de l'inférence, le modèle traiterait l'image d'un nouveau patient et fournirait un diagnostic, qui pourrait ensuite être examiné par un professionnel de santé. L'ensemble du processus doit être efficace et précis, car tout retard ou erreur pourrait avoir de graves conséquences. Le besoin en puissance de calcul et en ressources informatiques est évident, en particulier dans les scénarios où le modèle doit traiter de grands ensembles de données et des tâches complexes.

Le rôle des moteurs d'inférence IA

Un moteur d'inférence IA est un composant logiciel qui gère l'exécution de modèles d'IA entraînés, en optimisant les charges de travail à faible latence et hautes performances. Ces moteurs sont conçus pour gérer les tâches de traitement des données d'entrée et de génération des sorties, qui nécessitent une puissance de calcul importante, afin de garantir le fonctionnement efficace du modèle dans des environnements en temps réel. Les progrès matériels, tels que les GPU et les CPU, ont considérablement amélioré les capacités des moteurs d'inférence, leur permettant de traiter des tâches de plus en plus complexes et gourmandes en données.

Par exemple, NVIDIA a largement contribué au domaine de l'inférence IA grâce à ses GPU, particulièrement adaptés aux tâches de traitement parallèle. Ces GPU permettent de réduire considérablement la latence de l'inférence, ce qui les rend idéaux pour les applications nécessitant une prise de décision en temps réel. En outre, l'essor de l'Edge Computing a encore élargi le potentiel de l'inférence IA, en permettant le traitement des données plus proche de leur source. Le transfert de données vers des centres de données centralisés est ainsi réduit et les performances globales améliorées.

Exemples et cas d'utilisation de l'inférence IA

L'inférence IA a de nombreuses applications dans divers secteurs, chacun tirant parti de la puissance des modèles IA entraînés pour résoudre des problèmes spécifiques. Dans le domaine de la santé, l'inférence IA est utilisée pour le diagnostic des maladies, la découverte de médicaments et la surveillance des patients. Par exemple, un modèle d'apprentissage profond entraîné sur des données d'imagerie médicale peut diagnostiquer rapidement et avec précision des maladies telles que le cancer ou la pneumonie, fournissant ainsi des informations précieuses aux professionnels de santé.

Dans l'Internet des objets (IoT), l'inférence IA joue un rôle crucial en permettant aux terminaux intelligents de prendre des décisions autonomes. Par exemple, un système domotique peut utiliser l'inférence IA pour régler le chauffage et la climatisation en fonction des habitudes des occupants, ou une ville intelligente peut l'utiliser pour optimiser la circulation et réduire les embouteillages. Les avancées en matière de capacités de l'IA, en particulier dans le domaine de la détection d'objets, ont encore amélioré ces systèmes. La capacité à traiter les données et à y répondre en temps réel est essentielle au bon fonctionnement de ces systèmes.

Une autre application notable de l'inférence IA concerne le domaine de l'IA générative et des modèles linguistiques à grande échelle (LLM). Les modèles tels que ChatGPT, qui reposent sur l'apprentissage profond et les réseaux neuronaux, utilisent l'inférence pour générer des textes semblables à ceux rédigés par des humains en réponse aux entrées des utilisateurs. Cette technologie a ouvert de nouvelles possibilités en matière de traitement du langage naturel et pourrait transformer notre interaction avec les systèmes d'IA, en les rendant plus intuitifs et plus conviviaux.

Conclusion

L'inférence IA est un composant essentiel des solutions d'IA actuelles, permettant la prise de décision en temps réel et l'application de modèles entraînés à des données nouvelles et inconnues. Il est essentiel de comprendre la distinction entre l'entraînement et l'inférence, car chaque phase comporte ses propres exigences et défis. L'entraînement concerne la création et l'optimisation de modèles, tandis que l'inférence se concentre sur le déploiement de ces modèles pour fournir des prévisions précises et opportunes.

L'avenir de l'inférence IA semble prometteur, grâce aux progrès réalisés dans le domaine du matériel, tels que les GPU et l'Edge Computing, et au développement de moteurs d'inférence optimisés. Ces avancées vont non seulement améliorer l'évolutivité des systèmes d'IA, mais aussi leur permettre de relever de nouveaux défis en matière de données et de tâches de plus en plus complexes. À mesure que l'IA poursuit son évolution, l'importance d'une inférence efficace et à faible latence ne fera que croître, stimulant l'innovation et ouvrant de nouvelles possibilités dans divers secteurs.

Foire aux questions

L'entraînement d'un modèle IA consiste à alimenter un algorithme avec de grands ensembles de données afin qu'il apprenne et identifie des modèles, ce qui nécessite des ressources et un temps de calcul importants. L'inférence IA est quant à elle la phase de déploiement au cours de laquelle le modèle entraîné traite de nouvelles données pour fournir des prédictions ou prendre des décisions, en mettant l'accent sur la faible latence et les performances en temps réel.

Les étapes clés de l'inférence IA incluent le prétraitement des données pour s'assurer qu'elles sont dans un format approprié, l'entrée de ces données dans le modèle entraîné et la génération d'une sortie, telle qu'une prédiction, une classification ou une décision. Chaque étape nécessite une réflexion approfondie sur les ressources de calcul et leur efficacité. La mise en œuvre d'une architecture et de systèmes de données adaptés est essentielle pour garantir le bon fonctionnement de l'IA et son interaction avec diverses entrées de données.

Un moteur d'inférence IA est un composant logiciel qui gère l'exécution de modèles d'IA entraînés, en optimisant les charges de travail à faible latence et hautes performances. Il gère les tâches de traitement des données d'entrée et de génération des sorties, qui nécessitent une puissance de calcul importante, en utilisant souvent des GPU pour garantir un fonctionnement efficace en temps réel.

Une faible latence est cruciale dans l'inférence IA, car tout retard peut être préjudiciable dans les applications qui nécessitent une prise de décision en temps réel, telles que les véhicules autonomes, les chatbots et les terminaux intelligents. Des temps de réponse rapides garantissent le bon fonctionnement et la sécurité du système.

L'inférence IA est utilisée dans divers secteurs, notamment les soins de santé (par exemple, le diagnostic des maladies, la découverte de médicaments), l'IoT (par exemple, les systèmes domestiques intelligents, les villes intelligentes) et l'IA générative (par exemple, les LLM comme ChatGPT). Ces applications exploitent la puissance des modèles d'apprentissage automatique entraînés pour résoudre des problèmes spécifiques en temps réel.

Les GPU et les CPU sont essentiels à l'inférence IA, car ils fournissent la puissance de calcul nécessaire pour traiter les données d'entrée et générer des sorties de manière efficace. Les GPU, en particulier, sont particulièrement adaptés aux tâches de traitement parallèle, ce qui peut réduire considérablement la latence de l'inférence.

L'Edge Computing permet de mettre en œuvre l'inférence IA au plus près de la source des données, ce qui réduit les besoins de transfert vers des centres de données centralisés. Cela améliore les performances globales en réduisant la latence et en renforçant les capacités en temps réel des systèmes IA, qui gagnent ainsi en efficacité et en réactivité.

Oui, l'inférence IA est largement utilisée dans le domaine de la santé dans des applications telles que le diagnostic des maladies, la découverte de médicaments et la surveillance des patients. Par exemple, un modèle d'apprentissage profond entraîné sur des données d'imagerie médicale peut diagnostiquer rapidement et avec précision des maladies telles que le cancer ou la pneumonie, fournissant ainsi des informations précieuses aux professionnels de santé.

L'inférence IA améliore les capacités des terminaux IoT en leur permettant de prendre des décisions autonomes basées sur des données en temps réel. Par exemple, un système domotique peut utiliser l'inférence IA pour régler le chauffage et la climatisation en fonction des habitudes des occupants, ou une ville intelligente peut optimiser la circulation et réduire les embouteillages.

Pourquoi les clients choisissent-ils Akamai ?

Akamai est l'entreprise de cybersécurité et de Cloud Computing qui soutient et protège l'activité en ligne. Nos solutions de sécurité leaders du marché, nos informations avancées sur les menaces et notre équipe opérationnelle internationale assurent une défense en profondeur pour protéger les données et les applications des entreprises du monde entier. Les solutions de Cloud Computing complètes d'Akamai offrent des performances de pointe à un coût abordable sur la plateforme la plus distribuée au monde. Les grandes entreprises du monde entier font confiance à Akamai pour bénéficier de la fiabilité, de l'évolutivité et de l'expertise de pointe nécessaires pour développer leur activité en toute sécurité.