El big data hace referencia a conjuntos de datos extremadamente grandes y complejos que no se pueden gestionar, procesar ni analizar de forma eficaz con las herramientas tradicionales. Incluye datos estructurados, semiestructurados y no estructurados generados a partir de diversas fuentes, como redes sociales, dispositivos IoT y sistemas transaccionales.

El big data ha transformado el mundo moderno y lo ha impulsado todo, desde recomendaciones personalizadas de productos hasta avances en el sector sanitario. Cada clic, deslizamiento y transacción que realizamos contribuye a una huella digital de información en constante crecimiento. Esta explosión de datos promete un mundo más conectado, eficiente e inteligente. A diferencia de los sistemas de datos tradicionales, que tienen dificultades con conjuntos de datos complejos, el big data prospera gracias a la diversidad, la escala y la velocidad. Desde el avance de los algoritmos de aprendizaje automático hasta la toma de decisiones en tiempo real, las aplicaciones para utilizar el big data con el fin de resolver problemas y mejorar experiencias son tan amplias y variadas como sus fuentes.

Big data: una definición

Big data hace referencia a las grandes cantidades de datos (estructurados, semiestructurados y no estructurados) que el mundo digital genera a gran velocidad y que requieren herramientas avanzadas para su almacenamiento, análisis y procesamiento. Abarca conjuntos de datos que los sistemas de datos tradicionales, como las hojas de cálculo o las bases de datos relacionales, no pueden gestionar de forma eficaz. En su lugar, el big data se basa en plataformas especializadas como Hadoop, los lagos de datos y el cloud computing.

La importancia del big data

El big data es una herramienta esencial para las organizaciones que les permite tomar decisiones mejores, más rápidas y más fundamentadas. Mediante el análisis de grandes conjuntos de datos procedentes de diversas fuentes, las empresas pueden identificar tendencias, detectar correlaciones puntuales y comprender preferencias de los clientes que antes eran indetectables. Esta valiosa información no solo mejora la toma de decisiones, sino que también permite a las organizaciones predecir los cambios del mercado, adaptar las estrategias y obtener ventaja competitiva. En sectores como el financiero, el sanitario y el comercio minorista, el big data impulsa la innovación, reduce los riesgos y garantiza que las organizaciones mantengan la agilidad en un mundo en constante cambio.

Tipos de big data

El big data se presenta en tres formas principales, cada una de las cuales ofrece desafíos y oportunidades únicos para el procesamiento y el análisis.

- Datos estructurados: este tipo de datos está muy organizado y se almacena en formatos predefinidos, normalmente en bases de datos relacionales. Los datos estructurados son fáciles de buscar, consultar y analizar mediante herramientas tradicionales como SQL. Entre los ejemplos se incluyen registros de clientes, transacciones financieras y datos de inventario. Su naturaleza bien organizada los hace adecuados para sistemas que dependen de formatos de datos coherentes y predecibles, como plataformas de inteligencia empresarial y almacenes de datos.

- Datos no estructurados: los datos no estructurados no siguen un formato o esquema específico, lo que dificulta su almacenamiento y análisis. Entre los ejemplos se incluyen archivos de texto, imágenes, vídeos, correos electrónicos y publicaciones en redes sociales. Este tipo de datos representa la mayoría de los grandes volúmenes de información que se generan a diario y requiere herramientas especializadas como algoritmos de aprendizaje automático o procesamiento del lenguaje natural (NLP) para extraer información significativa. Los datos no estructurados son fundamentales para sectores como los medios de comunicación, el marketing y la atención sanitaria, donde la información contextual enriquecida es fundamental.

- Datos semiestructurados: los datos semiestructurados representan un punto intermedio entre los datos estructurados y los no estructurados. Contienen elementos de ambos, como campos identificables o etiquetas dentro de un formato flexible. Entre los ejemplos se incluyen archivos XML y JSON, y datos de sensores de dispositivos IoT. Aunque carecen de la estricta organización de los datos estructurados, los datos semiestructurados son más fáciles de procesar que los datos puramente no estructurados y suelen utilizarse en aplicaciones web, comercio electrónico e iniciativas de integración de datos.

Fuentes de big data

El big data se genera a partir de una amplia variedad de fuentes de datos que abarcan tanto el ámbito digital como el físico.

- Plataformas de redes sociales: plataformas como Facebook, Twitter, Instagram y LinkedIn generan grandes cantidades de datos brutos diariamente a través de publicaciones, comentarios, likes y contenido multimedia. Estos datos no estructurados ofrecen información sobre el comportamiento de los usuarios, el análisis de opiniones y las tendencias de interacción, lo que ayuda a las empresas a perfeccionar su experiencia de cliente y sus estrategias de marketing.

- Dispositivos IoT (Internet de las cosas): miles de millones de dispositivos conectados, como sistemas domésticos inteligentes, dispositivos portátiles y sensores industriales, generan datos de sensores de forma continua. Estos datos de máquinas permiten aplicaciones de mantenimiento predictivo, supervisión medioambiental y planificación urbana inteligente, con procesamiento en tiempo real que garantiza una información oportuna.

- Datos de comercio electrónico y transacciones: las plataformas de venta minorista online, los sistemas bancarios y los terminales de punto de venta generan datos transaccionales, incluidos detalles de compra, comportamiento de los clientes y tendencias de precios. Estos datos ayudan a las empresas a optimizar el inventario, crear recomendaciones personalizadas y mejorar la eficiencia operativa.

- Fuentes de datos de streaming: los flujos de datos de sistemas en tiempo real, como los mercados financieros, la monitorización meteorológica y las actualizaciones deportivas en directo, proporcionan información dinámica.

- Medios de comunicación y web: los medios de comunicación, las plataformas de vídeo y los sitios web aportan enormes cantidades de datos no estructurados en forma de artículos, vídeos, imágenes y comentarios. Además, los datos sobre el tráfico web, incluidos los flujos de clics y los registros de sesiones, ofrecen información sobre el comportamiento y las tendencias de los usuarios, que son esenciales para mejorar las interfaces de usuario y las estrategias de marketing digital.

- Código abierto: los datos disponibles públicamente de bases de datos gubernamentales, estudios de investigación y plataformas de acceso abierto proporcionan una gran cantidad de información para su análisis. Por ejemplo, las organizaciones pueden utilizar datos como las estadísticas demográficas, los datos climáticos y los repositorios de investigación científica para la formulación de políticas, la innovación y las iniciativas sociales.

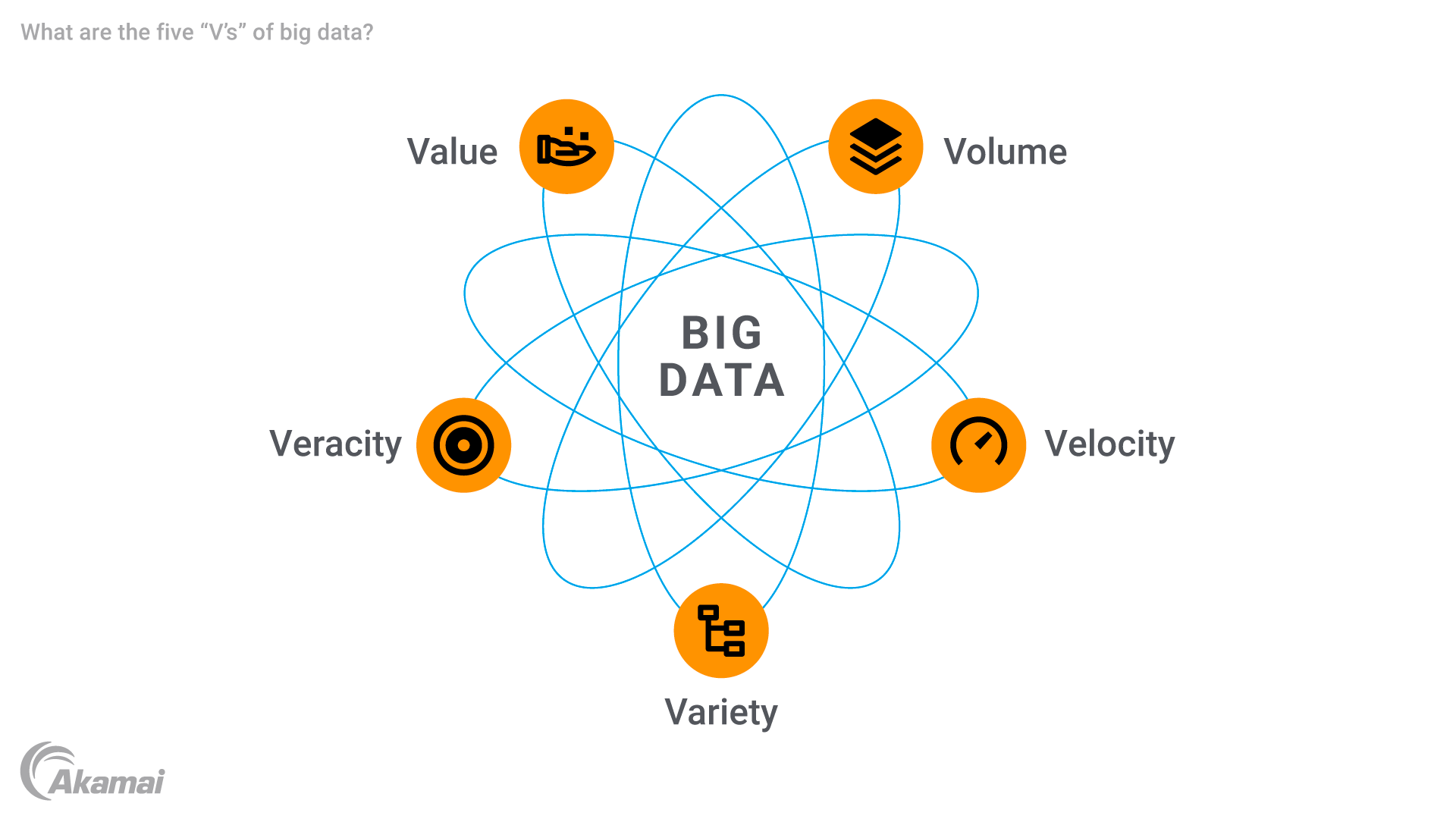

Las cinco "V" del big data

El big data se caracteriza por cinco atributos primarios, a menudo denominados las cinco "V".

- Volumen: la característica más determinante del big data es su inmenso tamaño. Las organizaciones gestionan volúmenes de datos que se miden en terabytes, petabytes o incluso exabytes de información. Esa enorme cantidad de datos requiere soluciones avanzadas de almacenamiento de datos para almacenar y procesar la información de forma eficaz.

- Velocidad: el big data se genera y procesa a una velocidad increíble, a menudo en tiempo real. Ya sea en streaming desde dispositivos IoT, feeds de redes sociales o transacciones financieras, un flujo de datos rápido requiere tecnologías robustas que puedan manejar el procesamiento de datos a alta velocidad para garantizar la entrega de información oportuna. La velocidad es especialmente importante en aplicaciones como la detección de fraudes y el mantenimiento predictivo, donde los retrasos pueden provocar importantes pérdidas.

- Variedad: el big data también se caracteriza por una amplia gama de tipos de datos. Los ejemplos van desde registros de bases de datos relacionales tradicionales hasta contenido multimedia, datos de sensores y metadatos. Esta diversidad requiere herramientas sofisticadas para la integración y el análisis de datos, ya que los sistemas tradicionales no están preparados para manejar conjuntos de datos tan complejos.

- Veracidad: con la enorme cantidad de datos sin procesar recopilados, garantizar la calidad y la precisión de los mismos supone un reto importante. Los datos incoherentes, incompletos o imprecisos pueden socavar la fiabilidad de los análisis predictivos y otras conclusiones. La veracidad destaca la importancia de limpiar, validar y gestionar los datos para generar confianza en los resultados de los análisis.

- Valor: el objetivo final del big data es obtener información valiosa que pueda impulsar la toma de decisiones, optimizar las operaciones y crear oportunidades. El uso del big data permite a las organizaciones obtener información sin procesar y desarrollar resultados prácticos que puedan mejorar la experiencia del cliente, aumentar la eficiencia operativa o impulsar innovaciones en campos como la atención sanitaria y el comercio minorista.

La historia y la evolución del big data

El concepto de big data surgió en la década de los 90, cuando las organizaciones se enfrentaron al reto de gestionar y analizar grandes conjuntos de datos que superaban las capacidades de los sistemas tradicionales, como las bases de datos relacionales. En los primeros debates se hizo hincapié en la necesidad de un almacenamiento y procesamiento escalables, a medida que las empresas recopilaban cada vez más datos sin procesar de diversas fuentes.

El desarrollo de tecnologías como Hadoop en 2006 aceleró la evolución del big data. El marco distribuido de Hadoop permitió el almacenamiento y procesamiento de conjuntos de datos masivos en varios servidores, superando las limitaciones de los sistemas centralizados. Al mismo tiempo, se introdujeron bases de datos NoSQL para gestionar datos no estructurados y semiestructurados con mayor flexibilidad y velocidad, lo que sentó las bases para el análisis moderno de big data.

El auge del cloud computing.en la década de 2010 transformó aún más la gestión del big data. Plataformas como AWS y Google Cloud permitieron a las empresas ampliar el almacenamiento y el procesamiento de datos sin necesidad de realizar inversiones significativas en infraestructura.

La llegada del Internet de las cosas (IoT) trajo consigo un aumento repentino de los datos de sensores en tiempo real, lo que incrementó exponencialmente la producción de datos globales. Para gestionar esta complejidad, se desarrollaron tecnologías avanzadas como el análisis de streaming, las herramientas basadas en IA y los algoritmos de aprendizaje automático.

Hoy en día, el big data sigue evolucionando gracias a las innovaciones en inteligencia artificial, edge computing y ciencia de datos.

Desafíos del big data

El big data ofrece enormes oportunidades, pero también plantea desafíos técnicos, organizativos y financieros.

- Gestión e integración de datos: la integración de diversas fuentes de datos en plataformas de big data unificadas, como lagos de datos, almacenes de datos y sistemas de streaming, es compleja. Una gestión deficiente conduce a ineficiencias, duplicación y pérdida de información.

- Calidad y variabilidad de los datos: el big data a menudo contiene información incoherente o incompleta, especialmente de datos no estructurados, como las redes sociales. Mantener la calidad y gestionar la variabilidad de los puntos de datos es crucial para evitar errores en el análisis de los datos.

- Demanda de mano de obra calificada: la necesidad de contar con expertos en análisis de big data, aprendizaje automático y ciencia de datos ha dado lugar a un déficit de competencias, lo que requiere una inversión significativa en la contratación o formación de científicos de datos y analistas de datos.

- Costes de infraestructura: la gestión de grandes volúmenes de datos requiere soluciones costosas como cloud computing, Hadoop y bases de datos NoSQL, especialmente para el procesamiento y el almacenamiento en tiempo real.

- Seguridad y privacidad: garantizar la seguridad de los datos sensibles de los dispositivos IoT y otras fuentes es esencial. Las organizaciones se enfrentan a desafíos relacionados con el cifrado, el cumplimiento de las normativas de privacidad y el almacenamiento seguro.

- Escalabilidad y flexibilidad: a medida que los datos crecen, los sistemas deben escalarse sin que ello afecte al rendimiento. Las organizaciones deben adaptarse a la evolución de las tecnologías y los requisitos de big data.

Cómo funciona el big data

El big data funciona a través de una serie de pasos que permiten a las organizaciones recopilar, almacenar, procesar y analizar una gran cantidad de información, transformando los datos sin procesar en información procesable.

- Recopilación de datos: el proceso comienza con la recopilación de datos de fuentes como dispositivos IoT, que generan datos de sensores en tiempo real, y las plataformas de redes sociales, que producen datos no estructurados, como publicaciones y vídeos. Otras fuentes incluyen sistemas transaccionales, aplicaciones móviles y datos de streaming de eventos en directo. Esto garantiza la integridad de los datos para realizar análisis avanzados.

- Almacenamiento de datos: los datos recopilados se almacenan en lagos de datos diseñados para formatos diversos y sin procesar, incluidos datos estructurados, semiestructurados y no estructurados. Los almacenes de datos organizan los datos para necesidades analíticas específicas, mientras que las plataformas de cloud computing ofrecen un almacenamiento escalable y rentable para gestionar grandes volúmenes de datos.

- Datos procesados: herramientas como Hadoop y Spark gestionan el procesamiento distribuido dividiendo los datos en fragmentos gestionables. Las plataformas de nube también proporcionan recursos para limpiar, transformar e integrar los datos con el fin de garantizar su calidad. Este paso prepara los datos para el análisis predictivo y otras aplicaciones avanzadas.

- Visualización de datos: los datos procesados se presentan a través de herramientas como Tableau y Power BI, que utilizan paneles de control y ayudas visuales como gráficos y mapas de calor. Estos simplifican los conjuntos de datos complejos, lo que permite a los responsables de la toma de decisiones explorar tendencias y correlaciones para facilitar una toma de decisiones más rápida y segura.

Aplicaciones y casos de uso del big data

El big data está transformando sectores de todo el mundo, ofreciendo información procesable, mejorando la eficiencia e impulsando la innovación.

- Atención sanitaria: el big data permite modelos predictivos y la monitorización de pacientes en tiempo real a través de los datos de sensores de dispositivos portátiles, como los relojes inteligentes. Los hospitales utilizan grandes conjuntos de datos para personalizar los planes de tratamiento, analizar la información genética y optimizar las operaciones, lo que reduce los tiempos de espera de los pacientes y mejora la atención.

- Inteligencia empresarial y comercio minorista: las empresas utilizan análisis de big data para perfeccionar las estrategias de precios, prever la demanda y personalizar el marketing. Las plataformas de comercio electrónico como Amazon optimizan el inventario y ajustan los precios de forma dinámica, mientras que los datos transaccionales ayudan a detectar fraudes en los servicios financieros.

- IA y big data: los sistemas de IA se basan en grandes conjuntos de datos para entrenar modelos para el reconocimiento de imágenes, el procesamiento del lenguaje natural y la detección de fraudes. Los coches autónomos y los asistentes virtuales como Alexa utilizan el big data para mejorar la toma de decisiones y la personalización.

- Internet de las cosas (IoT): los dispositivos IoT generan flujos de datos en tiempo real para optimizar el rendimiento y el mantenimiento predictivo. Los termostatos inteligentes recomiendan ajustes de ahorro de energía, y la agricultura utiliza sensores IoT para controlar la humedad del suelo y mejorar la eficiencia.

- Cadena de suministro y logística: los flujos de datos de los sensores GPS y RFID mejoran el seguimiento de los envíos, la optimización de las rutas y la gestión del inventario. El análisis predictivo garantiza que se almacenen los productos adecuados, lo que ahorra costes y mejora la precisión de las entregas.

- Finanzas y banca: el big data ayuda a detectar fraudes, así como a mejorar la gestión de riesgos y la puntuación crediticia. Los algoritmos analizan los historiales de transacciones en busca de anomalías, mientras que los bancos de inversión lo utilizan para el comercio algorítmico y la predicción de precios.

- Multimedia y entretenimiento: plataformas como Netflix utilizan el big data para recomendar contenido, lo que mejora la interacción mediante el análisis de las preferencias del usuario. Las empresas de medios de comunicación optimizan sus estrategias publicitarias dirigiéndose al público a través del análisis de las redes sociales.

- Fabricación: los datos de los sensores de equipos se analizan en tiempo real para predecir fallos y programar el mantenimiento. El big data también sirve de base al diseño de productos mediante la evaluación de los comentarios de los clientes y los patrones de uso.

- Educación: el big data personaliza las experiencias de aprendizaje mediante el análisis de evaluaciones y métricas de participación. Ayuda a las universidades a optimizar la previsión de matriculaciones y a asignar recursos de forma eficiente.

- Energía y servicios públicos: el big data optimiza el consumo de energía e integra fuentes renovables. Las redes inteligentes utilizan la monitorización en tiempo real y las empresas petroleras analizan los datos sísmicos para reducir los costes y el impacto medioambiental.

Soluciones y tecnologías esenciales del big data

La gestión eficaz del big data requiere herramientas y tecnologías avanzadas de almacenamiento, procesamiento, análisis y visualización para extraer información procesable de conjuntos de datos grandes y complejos.

- Las soluciones de almacenamiento de datos constituyen la base de la gestión del big data. Los lagos de datos almacenan datos sin procesar, ya sean estructurados, semiestructurados o no estructurados, mientras que los almacenes de datos organizan los datos para facilitar las consultas y la generación de informes. Las plataformas de nube escalables y rentables gestionan el aumento de los volúmenes de datos de forma eficiente.

- Las herramientas de análisis y procesamiento de datos convierten los datos brutos en información útil. Marcos como Hadoop permiten el procesamiento distribuido de grandes conjuntos de datos, mientras que Apache Spark se especializa en el procesamiento de datos en tiempo real y admite el aprendizaje automático. Las herramientas de ETL (extracción, transformación y carga) como Talend preparan los datos para el análisis extrayéndolos, transformándolos y cargándolos de forma eficaz.

- Las bases de datos para big data admiten diversos formatos. Las bases de datos NoSQL, como MongoDB y Cassandra, gestionan datos no estructurados con escalabilidad, mientras que las bases de datos relacionales, como MySQL, gestionan datos estructurados eficazmente.

- Las herramientas de visualización de datos facilitan el acceso a la información. Herramientas como Tableau y Power BI crean paneles de control interactivos, lo que simplifica los conjuntos de datos complejos. Las visualizaciones personalizadas se crean con herramientas como D3.js para aplicaciones web específicas.

- Las plataformas de análisis de big data como Google BigQuery y Amazon Redshift permiten realizar consultas y análisis con rapidez, mientras que los sistemas integrales como Cloudera combinan almacenamiento, procesamiento y análisis en una única solución.

- Las herramientas de IA y aprendizaje automático se basan en el big data para el desarrollo de modelos. Marcos como TensorFlow y PyTorch procesan grandes conjuntos de datos, mientras que plataformas como Google AutoM hacen que la IA sea accesible para no expertos.

- Las tecnologías de streaming y en tiempo real, como Apache Kafka, gestionan flujos de datos en tiempo real procedentes de dispositivos IoT y redes sociales, mientras que Flink proporciona análisis para obtener información inmediata.

- Las soluciones de seguridad y control garantizan la seguridad y el cumplimiento normativo. Las herramientas de cifrado protegen los datos confidenciales, y las plataformas como Collibra mantienen la calidad de los datos y garantizan el cumplimiento normativo.

- Las herramientas de integración, como Apache NiFi, automatizan el movimiento de datos entre sistemas, lo que permite una colaboración fluida y una gestión eficaz de ecosistemas de datos complejos.

Preguntas frecuentes

El big data ayuda a las organizaciones a tomar decisiones fundamentadas, identificar tendencias, mejorar la experiencia del cliente y optimizar las operaciones. Permite a sectores como el sanitario, el financiero y el minorista innovar y seguir siendo competitivos.

El big data se genera a partir de diversas fuentes, como redes sociales, dispositivos IoT, plataformas de comercio electrónico, transacciones financieras, datos de streaming y bases de datos públicas.

Un lago de datos almacena datos sin procesar en su formato nativo y es flexible para diversos casos de uso. Un almacén de datos organiza los datos en formatos estructurados para facilitar las consultas y las aplicaciones de inteligencia empresarial.

Entre los retos se incluyen la gestión de la calidad de los datos, la garantía de la seguridad, la integración de diversas fuentes, la gestión de los costes de la infraestructura y la búsqueda de profesionales cualificados para analizar e interpretar los datos.

Por qué los clientes eligen Akamai

Akamai es la empresa de ciberseguridad y cloud computing que potencia y protege los negocios online. Nuestras soluciones de seguridad líderes en el mercado, nuestra inteligencia ante amenazas consolidada y nuestro equipo de operaciones globales proporcionan una defensa en profundidad para proteger los datos y las aplicaciones empresariales. Las soluciones integrales de cloud computing de Akamai garantizan el rendimiento y una buena relación calidad-precio en la plataforma más distribuida del mundo. Las grandes empresas confían en Akamai, ya que les ofrece una fiabilidad, una escalabilidad y una experiencia inigualables en el sector, idóneas para crecer con seguridad.