Le Big Data fait référence à des ensembles de données extrêmement volumineux et complexes qui ne peuvent pas être gérés, traités ou analysés efficacement avec des outils traditionnels. Il comprend des données structurées, semi-structurées et non structurées générées à partir de diverses sources telles que les réseaux sociaux, les terminaux IoT et les systèmes transactionnels.

Le Big Data a transformé le monde actuel en alimentant tout, des recommandations de produits personnalisées aux progrès dans le domaine de la santé. Chaque clic, chaque défilement et chaque transaction que nous effectuons contribue à augmenter l'empreinte digitale des informations. Cette explosion des données promet un monde plus connecté, plus efficace et plus intelligent. Contrairement aux systèmes de données traditionnels, qui sont confrontés à des ensembles de données complexes, le Big Data repose sur la diversité, l'évolutivité et la rapidité. Des algorithmes avancés d'apprentissage automatique à la prise de décision en temps réel, les applications d'utilisation du Big Data pour résoudre les problèmes et améliorer les expériences sont aussi vastes et variées que ses sources.

Le Big Data : définition

Le Big Data fait référence aux grands volumes de données (structurées, semi-structurées et non structurées) que le monde digital génère à grande vitesse et qui nécessitent des outils avancés pour le stockage, l'analyse et le traitement des données. Il englobe des ensembles de données que les systèmes de données traditionnels tels que les feuilles de calcul ou les bases de données relationnelles ne peuvent pas gérer efficacement. Le Big Data, lui, repose sur des plateformes spécialisées telles que Hadoop, des lacs de données et le Cloud Computing.

L'importance du Big Data

Le Big Data est un outil stratégique qui permet aux entreprises de prendre des décisions plus efficaces, plus rapides et plus éclairées. En analysant de grands ensembles de données provenant de diverses sources, les entreprises peuvent identifier les tendances, repérer les corrélations et comprendre les préférences des clients qui étaient auparavant indétectables. Ces précieuses informations améliorent non seulement la prise de décision, mais permettent également aux entreprises de prévoir les évolutions du marché, d'adapter les stratégies et d'obtenir un avantage concurrentiel. Dans des secteurs tels que la finance, la santé et le commerce de détail, le Big Data favorise l'innovation, réduit les risques et garantit aux entreprises une grande flexibilité dans un monde en constante évolution.

Les types de Big Data

Le Big Data se présente sous trois formes principales, chacune offrant des défis et des opportunités uniques en matière de traitement et d'analyse.

- Données structurées : ce type de données est parfaitement organisé et stocké dans des formats prédéfinis, généralement dans des bases de données relationnelles. Les données structurées sont faciles à rechercher, à interroger et à analyser à l'aide d'outils traditionnels tels que SQL. Il peut s'agir par exemple des dossiers clients, des transactions financières et des données de stock. Grâce à sa capacité d'organisation, il convient aux systèmes qui reposent sur des formats de données cohérents et prévisibles, tels que les plateformes de veille stratégique et les entrepôts de données.

- Données non structurées : les données non structurées ne suivent pas un format ou un schéma spécifique, ce qui les rend plus difficiles à stocker et à analyser. Il peut s'agir par exemple de fichiers texte, d'images, de vidéos, d'e-mails et de publications sur les réseaux sociaux. Ce type de données représente la majorité des grands volumes d'informations générés quotidiennement et nécessite des outils spécialisés tels que les algorithmes d'apprentissage automatique ou le traitement du langage naturel (NLP) pour extraire des informations pertinentes. Les données non structurées sont essentielles pour les secteurs tels que les médias, le marketing et la santé, où les informations contextuelles détaillées sont primordiales.

- Données semi-structurées : les données semi-structurées représentent un type intermédiaire entre les données structurées et non structurées. Elles contiennent des éléments des deux types, tels que des champs d'informations personnelles ou des balises dans un format flexible. Il peut s'agir par exemple de fichiers XML, JSON et de données de capteurs provenant de terminaux IoT. Bien qu'elles ne soient pas aussi organisées que les données structurées, les données semi-structurées sont plus faciles à traiter que les données purement non structurées et sont souvent utilisées dans les applications Web, l'e-commerce et les initiatives d'intégration de données.

Les sources de Big Data

Le Big Data est généré à partir d'un large éventail de sources de données qui couvrent à la fois les domaines physique et digital.

- Plateformes de réseaux sociaux : les plateformes telles que Facebook, Twitter, Instagram et LinkedIn produisent quotidiennement de grands volumes de données brutes par le biais de publications, de commentaires, de mentions J'aime et de contenus multimédias. Ces données non structurées offrent des informations sur le comportement des utilisateurs, l'analyse des sentiments et les tendances d'engagement, aidant ainsi les entreprises à affiner leur expérience client et leurs stratégies marketing.

- Terminaux IoT (Internet des objets) : des milliards de terminaux connectés, tels que les systèmes domotiques, les accessoires connectés et les capteurs industriels, génèrent des données de capteurs en continu. Ces données de machine peuvent être notamment utilisées pour la maintenance prédictive, la surveillance environnementale et la planification urbaine intelligente, avec un traitement en temps réel pour fournir des informations en temps voulu.

- E-commerce et données transactionnelles : les plateformes de vente en ligne, les systèmes bancaires et les terminaux de point de vente génèrent des données transactionnelles, notamment les détails des achats, le comportement des clients et les tendances tarifaires. Ces données aident les entreprises à optimiser les stocks, à créer des recommandations personnalisées et à améliorer l'efficacité opérationnelle.

- Sources de données en streaming : les flux de données provenant de systèmes en temps réel, tels que les marchés financiers, la surveillance météorologique et les actualités sportives en direct, fournissent des informations dynamiques.

- Médias et Web : les médias, les plateformes vidéo et les sites Web fournissent de grandes quantités de données non structurées sous forme d'articles, de vidéos, d'images et de commentaires. En outre, les données de trafic Web, y compris les flux de clics et les journaux de session, fournissent des informations sur le comportement des utilisateurs et les tendances, ce qui est essentiel pour améliorer les interfaces utilisateur et les stratégies de marketing digital.

- Infrastructures open source : les données publiques issues de bases de données gouvernementales, d'études de recherche et de plateformes en accès libre fournissent une mine d'informations à analyser. Les données telles que les statistiques démographiques, les données climatiques et les référentiels de recherche scientifique, par exemple, peuvent être utilisées par les organisations pour la création de règles, l'innovation et les initiatives sociales.

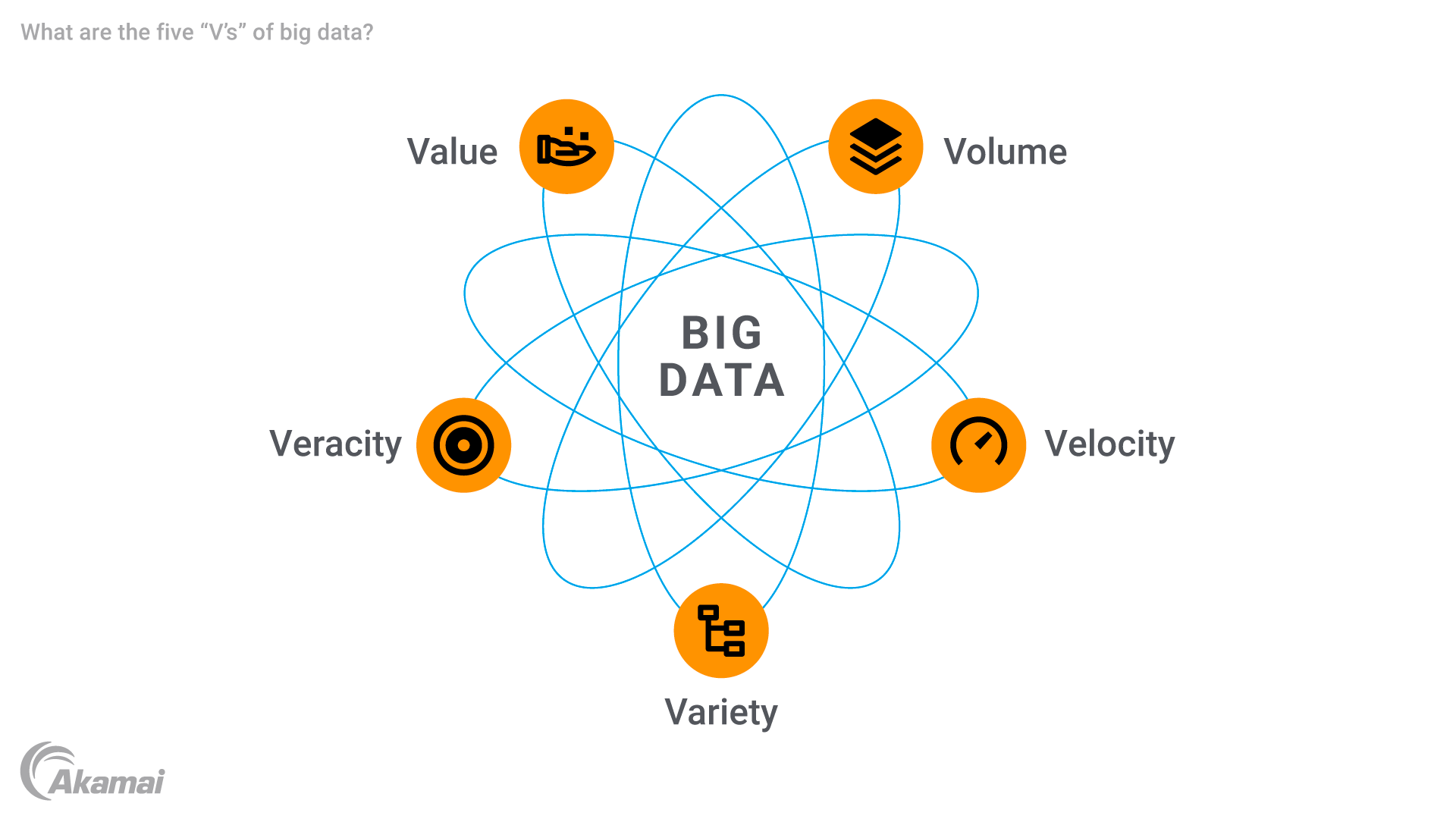

Les cinq « V » du Big Data

Le Big Data se caractérise par cinq attributs majeurs, souvent appelés les cinq « V ».

- Volume : la caractéristique la plus importante du Big Data est sa taille impressionnante. Les entreprises gèrent des volumes de données mesurés en téraoctets, pétaoctets, voire exaoctets. Cette grande quantité de données nécessite des solutions de stockage de données avancées pour stocker et traiter efficacement les informations.

- Vitesse : le Big Data est généré et traité à une vitesse incroyable, souvent en temps réel. Qu'il provienne de terminaux IoT, de fils d'actualités sur les réseaux sociaux ou de transactions financières, le flux de données rapide nécessite des technologies robustes et capables de traiter des données à toute vitesse pour fournir des informations en temps voulu. La vitesse est particulièrement importante dans les applications telles que la détection des fraudes et la maintenance prédictive, où les retards peuvent entraîner d'importantes pertes.

- Variété : le Big Data est également marqué par une grande variété de types de données. Il peut s'agir d'enregistrements de bases de données relationnelles traditionnelles, de contenu multimédia, de données de capteurs ou encore de métadonnées. Cette diversité nécessite des outils sophistiqués pour l'intégration et l'analyse des données, car les systèmes traditionnels sont mal équipés pour gérer des ensembles de données aussi complexes.

- Véracité : garantir la qualité et la précision représente un défi de taille en raison des quantités phénoménales de données recueillies. Des données incohérentes, incomplètes ou inexactes peuvent compromettre la fiabilité de l'analyse prédictive et d'autres informations exploitables. La véracité souligne l'importance du nettoyage, de la validation et de la gestion des données pour assurer des résultats d'analyse fiables.

- Valeur : l'objectif ultime du Big Data est d'obtenir des informations précieuses qui peuvent favoriser la prise de décision, optimiser les opérations et créer des opportunités. L'utilisation du Big Data permet aux entreprises de recueillir des informations brutes et de générer des résultats exploitables qui peuvent améliorer l'expérience client, optimiser l'efficacité opérationnelle ou favoriser l'innovation dans des domaines tels que la santé et le commerce de détail.

L'histoire et l'évolution du Big Data

Le concept de Big Data est apparu dans les années 1990, lorsque les entreprises ont dû faire face à des défis en matière de gestion et d'analyse de grands ensembles de données qui dépassaient les capacités des systèmes traditionnels tels que les bases de données relationnelles. Les premières discussions mettaient l'accent sur la nécessité d'un système de stockage et d'un traitement évolutifs, car les entreprises collectaient davantage de données brutes issues de sources diverses.

Le développement de technologies, telles que Hadoop en 2006, a accéléré l'évolution du Big Data. Le cadre distribué d'Hadoop a permis le stockage et le traitement d'ensembles de données volumineux sur plusieurs serveurs, surmontant les limites des systèmes centralisés. Parallèlement, les bases de données NoSQL ont été introduites pour gérer les données non structurées et semi-structurées avec plus de flexibilité et de rapidité, formant ainsi la base de l'analyse actuelle du Big Data.

L'essor du Cloud Computing dans les années 2010 a transformé encore davantage la gestion du Big Data. Les plateformes telles qu'AWS et Google Cloud ont permis aux entreprises de faire évoluer le stockage et le traitement des données sans avoir à réaliser d'investissements importants en infrastructure.

L'avènement de l'Internet des objets (IoT) a entraîné une hausse des données de capteurs en temps réel, ce qui a engendré une augmentation exponentielle de la production mondiale de données. Des technologies avancées telles que l'analyse du streaming, les outils basés sur l'IA et les algorithmes d'apprentissage automatique ont été développées pour gérer cette complexité.

Aujourd'hui, le Big Data continue d'évoluer grâce aux innovations en matière d'intelligence artificielle, d'Edge Computing et de science des données.

Les défis du Big Data

Le Big Data offre des opportunités considérables, mais présente également des défis techniques, organisationnels et financiers.

- Gestion et intégration des données : l'intégration de diverses sources de données dans des plateformes de Big Data unifiées telles que les lacs de données, les entrepôts de données et les systèmes de streaming est complexe. Une mauvaise gestion entraîne des inefficacités, des doublons et des informations manquées.

- Qualité et variabilité des données : le Big Data contient souvent des informations incohérentes ou incomplètes, en particulier lorsqu'il provient de données non structurées comme les réseaux sociaux. Le maintien de la qualité et la gestion de la variabilité des points de données sont essentiels pour éviter les erreurs dans l'analyse des données.

- Demande de main-d'œuvre qualifiée : le besoin d'expertise en matière d'analyse du Big Data, d'apprentissage automatique et de science des données a créé un déficit de compétences, nécessitant un investissement important dans le recrutement ou la formation des experts en science des données et des analystes de données.

- Coûts d'infrastructure : la gestion de grands volumes de données nécessite des solutions coûteuses telles que le Cloud Computing, Hadoop et les bases de données NoSQL, notamment pour le traitement et le stockage en temps réel.

- Sécurité et confidentialité : il est essentiel de garantir la sécurité des données brutes sensibles provenant des terminaux IoT et d'autres sources. Les entreprises sont confrontées à des défis en matière de chiffrement, de conformité relative à la confidentialité et de stockage sécurisé.

- Évolutivité et flexibilité : à mesure que les volumes de données s'amplifient, les systèmes doivent évoluer sans compromettre les performances. Les entreprises doivent s'adapter à l'évolution des technologies et des exigences du Big Data.

Le fonctionnement du Big Data

Le Big Data suit une série d'étapes qui permettent aux entreprises de collecter, stocker, traiter et analyser de grandes quantités d'informations, transformant ainsi les données brutes en informations exploitables.

- Collecte de données : Le processus commence par la collecte de données à partir de sources telles que les terminaux IoT, qui génèrent des données de capteurs en temps réel, et les plateformes de réseaux sociaux, produisant des données non structurées telles que les publications et les vidéos. Les autres sources incluent les systèmes transactionnels, les applications pour mobile et les données de streaming provenant d'événements live. Cela garantit que les données sont complètes à des fins d'analyses avancées.

- Stockage des données : les données collectées sont stockées dans des lacs de données conçus pour des formats bruts et divers, y compris des données structurées, semi-structurées et non structurées. Les entrepôts de données organisent les données pour répondre à des besoins analytiques spécifiques, tandis que les plateformes de Cloud Computing offrent un stockage évolutif et rentable pour gérer de grands volumes de données.

- Traitement des données : des outils tels que Hadoop et Spark gèrent le traitement distribué en divisant les données en fragments gérables. Les plateformes cloud fournissent également des ressources pour le nettoyage, la transformation et l'intégration des données afin de garantir la qualité des données. Cette étape prépare les données pour l'analyse prédictive et d'autres applications avancées.

- Visualisation des données : les données traitées sont présentées via des outils tels que Tableau et Power BI, à l'aide de tableaux de bord et d'aides visuelles, tels que des graphiques et des cartes thermiques. Ils simplifient les ensembles de données complexes, permettant aux décideurs d'explorer les tendances et les corrélations, facilitant ainsi une prise de décision plus rapide et plus confiante.

Les applications et cas d'utilisation du Big Data

Le Big Data transforme les industries du monde entier en fournissant des informations exploitables, en améliorant l'efficacité et en favorisant l'innovation.

- Santé : le Big Data permet de réaliser des modèles prédictifs et de surveiller les patients en temps réel grâce à des données de capteurs provenant d'accessoires connectés tels que des montres connectées. Les hôpitaux utilisent de grands ensembles de données pour personnaliser les plans de traitement, analyser les informations génétiques et optimiser les opérations, réduisant ainsi les temps d'attente des patients et améliorant les soins.

- Veille stratégique et commerce de détail : les entreprises utilisent l'analyse du Big Data pour affiner leurs stratégies de tarification, prévoir la demande et personnaliser le marketing. Les plateformes d'e-commerce comme Amazon optimisent les stocks et ajustent les prix de manière dynamique, tandis que les données transactionnelles facilitent la détection des fraudes dans les services financiers.

- IA et Big Data : les systèmes d'IA s'appuient sur de grands ensembles de données pour entraîner les modèles à la reconnaissance d'images, au traitement du langage naturel et à la détection de la fraude. Les voitures autonomes et les assistants virtuels comme Alexa utilisent le Big Data pour améliorer la prise de décision et la personnalisation.

- IoT (Internet des objets) : les terminaux IoT génèrent des flux de données en temps réel pour l'optimisation des performances et la maintenance prédictive. Les thermostats intelligents recommandent des paramètres d'économie d'énergie, et l'agriculture utilise des capteurs IoT pour surveiller l'humidité du sol et améliorer l'efficacité.

- Chaîne d'approvisionnement et logistique : les flux de données des capteurs GPS et RFID améliorent le suivi des expéditions, l'optimisation des itinéraires et la gestion des stocks. L'analyse prédictive garantit que les bons produits sont stockés, ce qui permet de réduire les coûts et d'améliorer la précision des livraisons.

- Finance et banques : le Big Data permet de détecter les fraudes, d'améliorer la gestion des risques et d'optimiser la notation de crédit. Les algorithmes analysent les historiques de transactions pour détecter les anomalies, tandis que les banques d'investissement utilisent le Big Data pour le trading algorithmique et la prévision des prix.

- Médias et divertissement : les plateformes comme Netflix utilisent le Big Data pour recommander du contenu, ce qui renforce l'engagement des utilisateurs en analysant leurs préférences. Les entreprises de médias optimisent leurs stratégies publicitaires en ciblant leurs audiences grâce à l'analyse des réseaux sociaux.

- Fabrication : les données des capteurs issus des équipements sont analysées en temps réel pour prévoir les pannes et planifier la maintenance. Le Big Data joue également un rôle crucial dans la conception des produits en analysant les retours des clients et les modèles d'utilisation.

- Enseignement : le Big Data personnalise les expériences d'apprentissage en analysant les évaluations et les indicateurs d'engagement. Il aide les universités à optimiser les prévisions d'inscription et à allouer efficacement les ressources.

- Énergie et services publics : le Big Data optimise la consommation d'énergie et intègre des sources renouvelables. Les réseaux intelligents utilisent la surveillance en temps réel et les compagnies pétrolières analysent les données sismiques pour réduire les coûts et l'impact sur l'environnement.

Les solutions et technologies essentielles issues du Big Data

La gestion efficace du Big Data nécessite des outils et des technologies avancés pour le stockage, le traitement, l'analyse et la visualisation afin de générer des informations exploitables à partir de grands ensembles de données complexes.

- Les solutions de stockage de données constituent la base de la gestion du Big Data. Les lacs de données stockent les données brutes et non traitées, prenant en charge les données structurées, semi-structurées et non structurées, tandis que les entrepôts de données organisent les données pour faciliter les requêtes et les rapports. Les plateformes cloud évolutives et rentables gèrent efficacement les volumes de données exponentiels.

- Les outils de traitement et d'analyse des données convertissent les données brutes en informations exploitables. Des cadres comme Hadoop permettent le traitement distribué de grands ensembles de données, tandis qu'Apache Spark est spécialisé dans le traitement des données en temps réel et prend en charge l'apprentissage automatique. Les outils ETL (extraction, transformation, chargement) tels que Talend préparent les données pour l'analyse en les extrayant, en les transformant et en les chargeant efficacement.

- Les bases de données pour le Big Data gèrent différents formats. Les bases de données NoSQL, telles que MongoDB et Cassandra, gèrent les données non structurées avec évolutivité, tandis que les bases de données relationnelles telles que MySQL gèrent efficacement les données structurées.

- Les outils de visualisation des données permettent d'accéder aux informations. Des outils tels que Tableau et Power BI créent des tableaux de bord interactifs qui simplifient les ensembles de données complexes. Les visualisations personnalisées sont conçues avec des outils tels que D3.js pour des applications Web spécifiques.

- Les plateformes d'analyse du Big Data, telles que Google BigQuery et Amazon Redshift, permettent des requêtes et des analyses rapides, tandis que des systèmes complets comme Cloudera combinent le stockage, le traitement et l'analyse en une seule solution.

- Les outils d'IA et d'apprentissage automatique s'appuient sur le Big Data pour le développement de modèles. Des cadres comme TensorFlow et PyTorch traitent des ensembles de données volumineux, tandis que des plateformes comme Google AutoML rendent l'IA accessible aux personnes manquant d'expertise.

- Les technologies de streaming et en temps réel, telles qu'Apache Kafka, gèrent les flux de données en temps réel depuis les terminaux IoT et les réseaux sociaux, tandis que Flink fournit des analyses pour des informations immédiates.

- Les solutions de sécurité et de gouvernance garantissent la sécurité et la conformité. Les outils de chiffrement protègent les données sensibles, et les plateformes telles que Collibra assurent la qualité des données et garantissent la conformité réglementaire.

- Les outils d'intégration, tels qu'Apache NiFi, automatisent le déplacement des données entre les systèmes, ce qui permet une collaboration fluide et une gestion efficace des écosystèmes de données complexes.

Foire aux questions

Le Big Data aide les entreprises à prendre des décisions éclairées, à identifier les tendances, à améliorer l'expérience client et à optimiser les opérations. Il permet à des secteurs tels que la santé, la finance et le commerce de détail d'innover et de rester compétitifs.

Le Big Data est issu de diverses sources, notamment les réseaux sociaux, les terminaux IoT, les plateformes d'e-commerce, les transactions financières, les données de streaming et les bases de données publiques.

Un lac de données stocke les données brutes dans leur format d'origine et s'adapte à divers cas d'utilisation. Un entrepôt de données organise les données dans des formats structurés pour faciliter les requêtes et les applications de veille stratégique.

Les défis en la matière sont nombreux : gestion de la qualité des données, garantie de la sécurité, intégration de diverses sources, gestion des coûts de l'infrastructure et recherche de professionnels qualifiés pour analyser et interpréter les données.

Pourquoi les clients choisissent-ils Akamai ?

Akamai est l'entreprise de cybersécurité et de Cloud Computing qui soutient et protège l'activité en ligne. Nos solutions de sécurité leaders du marché, nos informations avancées sur les menaces et notre équipe opérationnelle internationale assurent une défense en profondeur pour protéger les données et les applications des entreprises du monde entier. Les solutions de Cloud Computing complètes d'Akamai offrent des performances de pointe à un coût abordable sur la plateforme la plus distribuée au monde. Les grandes entreprises du monde entier font confiance à Akamai pour bénéficier de la fiabilité, de l'évolutivité et de l'expertise de pointe nécessaires pour développer leur activité en toute sécurité.