I big data sono dataset estremamente grandi e complessi che non possono essere gestiti, elaborati o analizzati in modo efficace con gli strumenti tradizionali poiché includono dati strutturati, semi-strutturati e non strutturati generati da varie fonti, come social media, dispositivi IoT e sistemi transazionali.

I big data hanno trasformato il mondo moderno, potenziando tutto, dai consigli personalizzati sui prodotti ai progressi nel settore sanitario. Ogni selezione, scorrimento e transazione che facciamo contribuisce ad ampliare continuamente l'ambiente digitale delle informazioni. Questa enorme quantità di dati mantiene la promessa di garantire un mondo più connesso, efficiente e intelligente. A differenza dei sistemi di dati tradizionali, che devono gestire complessi dataset, i big data prosperano in termini di diversità, scalabilità e velocità. Da avanzati algoritmi di apprendimento automatico alla possibilità di prendere decisioni in tempo reale, le applicazioni che utilizzano i big data per risolvere i problemi e migliorare le experience sono vaste e variegate come le loro origini.

Definizione di big data

I big data si riferiscono a grandi quantità di dati, strutturati, semi-strutturati e non strutturati, che il mondo digitale genera ad alta velocità e che richiedono strumenti avanzati per lo storage, l'analisi dei dati e l'elaborazione. I big data sono costituiti da dataset che i sistemi di dati tradizionali, come fogli di calcolo o database relazionali, non riescono a gestire in modo efficace. Al contrario, i big data si basano su piattaforme specializzate come Hadoop, i data lake e il cloud computing.

L'importanza dei big data

I big data sono uno strumento business-critical che consente alle organizzazioni di prendere decisioni migliori, più rapide e più informate. Analizzando grandi dataset provenienti da diverse origini di dati, le aziende possono identificare tendenze, individuare correlazioni e comprendere le preferenze dei clienti che, in precedenza, non riuscivano a rilevare. Queste preziose informazioni non solo migliorano i processi decisionali, ma consentono anche alle organizzazioni di prevedere i cambiamenti del mercato, adattare le proprie strategie e ottenere un vantaggio sulla concorrenza. In settori come quello finanziario/sanitario e nel retail, i big data favoriscono l'innovazione, riducono i rischi e garantiscono alle organizzazioni di rimanere agili in un mondo in rapida evoluzione.

I tipi di big data

I big data sono disponibili in tre forme principali, ciascuna delle quali offre sfide e opportunità uniche per l'elaborazione e l'analisi.

- Dati strutturati: questo tipo di dati è altamente organizzato e archiviato in formati predefiniti, in genere all'interno di database relazionali. I dati strutturati sono facili da cercare, interrogare e analizzare utilizzando strumenti tradizionali come SQL. Tra gli esempi, figurano record dei clienti, transazioni finanziarie e dati di inventario. La natura ben organizzata di questo tipo di dati lo rende adatto ai sistemi che si basano su formati di dati coerenti e prevedibili, come piattaforme di business intelligence e data warehouse.

- Dati non strutturati: i dati non strutturati non seguono un formato o uno schema specifico, il che li rende più difficile da archiviare e analizzare. Tra gli esempi, figurano file di testo, immagini, video, e-mail e post sui social media. Questo tipo di dati rappresenta la maggior parte dei grandi volumi di informazioni generate quotidianamente e richiede strumenti specializzati come algoritmi di apprendimento automatico o NLP (Natural Language Processing) per estrarre informazioni significative. I dati non strutturati sono fondamentali per settori come media, marketing e assistenza sanitaria, in cui sono fondamentali informazioni contestuali complete.

- Dati semi-strutturati: i dati semi-strutturati rappresentano una via di mezzo tra dati strutturati e non strutturati, quindi questo tipo di dati contiene elementi come campi o tag identificabili all'interno di un formato altrimenti flessibile. Tra gli esempi, figurano file XML, JSON e dati dei sensori provenienti dai dispositivi IoT. Sebbene non disponga di una rigorosa organizzazione di dati strutturati, i dati semi-strutturati sono più semplici da elaborare rispetto ai dati puramente non strutturati e vengono spesso utilizzati nelle applicazioni web, nell'e-commerce e nei progetti di integrazione dei dati.

Le origini dei big data

I big data vengono generati da un'ampia gamma di origini di dati appartenenti sia al mondo digitale che a quello fisico.

- Piattaforme di social media: piattaforme come Facebook, Twitter, Instagram e LinkedIn producono quotidianamente elevati volumi di dati non elaborati tramite post, commenti, like e contenuti multimediali. Questi dati non strutturati offrono informazioni sul comportamento, sull'analisi delle opinioni e sulle tendenze di engagement degli utenti, aiutando le aziende ad ottimizzare le customer experience e le strategie di marketing.

- Dispositivi IoT (Internet of Things): miliardi di dispositivi connessi, come sistemi domotici, dispositivi indossabili e sensori industriali, generano continuamente dati provenienti dai sensori. Questi dati informatici offrono alle applicazioni di manutenzione predittiva, monitoraggio ambientale e pianificazione urbana intelligente la possibilità di eseguire l'elaborazione in tempo reale garantendo informazioni tempestive.

- E-commerce e dati transazionali: le piattaforme di retail online, i sistemi bancari e i terminali POS generano dati sulle transazioni, tra cui dettagli degli acquisti, comportamenti dei clienti e tendenze dei prezzi. Questi dati aiutano le aziende ad ottimizzare l'inventario, creare consigli personalizzati e migliorare l'efficienza operativa.

- Origini dei dati di streaming: i flussi di dati provenienti da sistemi in tempo reale, come i mercati finanziari, il monitoraggio meteo e gli aggiornamenti sportivi live, forniscono informazioni dinamiche.

- Media e web: agenzie di stampa, piattaforme video e siti web forniscono enormi quantità di dati non strutturati sotto forma di articoli, video, immagini e commenti. Inoltre, i dati del traffico web, inclusi clickstream e registri di sessione, offrono informazioni sul comportamento e sulle tendenze degli utenti, che sono essenziali per migliorare le interfacce utente e le strategie di marketing digitale.

- Open source: i dati pubblicamente disponibili provenienti da database governativi, studi di ricerca e piattaforme ad accesso aperto forniscono una vasta gamma di informazioni da analizzare. Alcuni dati come statistiche demografiche, informazioni meteo e archivi di ricerca scientifica, ad esempio, possono essere utilizzati dalle organizzazioni per la definizione di policy, l'innovazione e iniziative sociali.

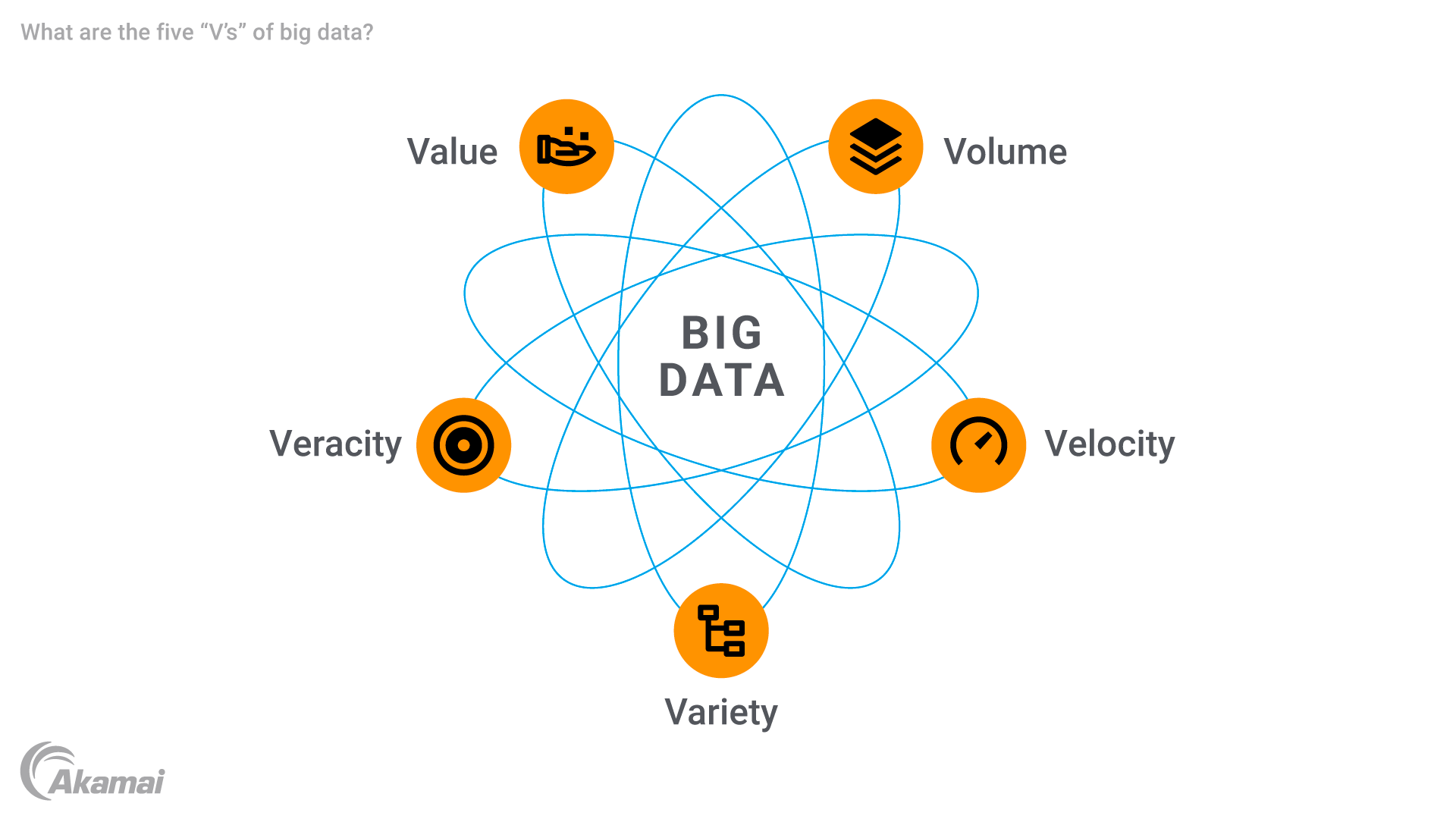

Le cinque "V" dei big data

I big data sono caratterizzati da cinque attributi principali, spesso definiti come le cinque "V".

- Volume: la caratteristica più distintiva dei big data è rappresentata dalle loro enormi dimensioni. Le organizzazioni si occupano di volumi di dati misurati in terabyte, petabyte o, persino, exabyte di informazioni. Questa enorme quantità di dati richiede avanzate soluzioni di storage dei dati per archiviare ed elaborare le informazioni in modo efficiente.

- Velocità: i big data vengono generati ed elaborati ad una velocità incredibile, spesso in tempo reale. Sia che si tratti di streaming proveniente da dispositivi IoT, feed di social media o transazioni finanziarie, questo rapido flusso di dati richiede solide tecnologie in grado di gestire l'elaborazione dei dati ad alta velocità per garantire informazioni tempestive. La velocità è particolarmente critica in applicazioni come il rilevamento delle frodi e la manutenzione predittiva, in cui i ritardi possono causare perdite significative.

- Varietà: i big data sono anche caratterizzati da un'ampia gamma di tipi di dati, che spaziano dai record di database relazionali tradizionali ai contenuti multimediali fino ai dati provenienti dai sensori e ai metadati. Questa diversità richiede strumenti sofisticati per l'integrazione e l'analisi dei dati poiché i sistemi tradizionali non sono attrezzati per gestire dataset così complessi.

- Veridicità: con le enormi quantità di dati non elaborati che vengono raccolti, garantire la qualità e l'accuratezza dei dati è una sfida non da poco. Dati incoerenti, incompleti o imprecisi possono compromettere l'affidabilità dell'analisi predittiva e di altre informazioni. La veridicità sottolinea l'importanza di pulire, confermare e gestire i dati per creare fiducia nei risultati delle analisi.

- Valore: l'obiettivo finale dei big data è ricavare preziose informazioni in grado di favorire il processo decisionale, ottimizzare le operazioni e creare opportunità. L'uso dei big data consente alle organizzazioni di raccogliere informazioni non elaborate e sviluppare risultati fruibili in grado di migliorare le customer experience, migliorare l'efficienza operativa o promuovere innovazioni in settori come l'assistenza sanitaria e il retail.

La storia e l'evoluzione dei big data

Il concetto di big data è emerso intorno al 1990 quando le organizzazioni hanno dovuto affrontare problemi di gestione e analisi di grandi dataset che superavano le funzionalità dei sistemi tradizionali, come i database relazionali. Le prime discussioni sottolineavano la necessità di scalare le funzionalità di storage e elaborazione poiché le aziende raccoglievano un maggior numero di dati non elaborati da diverse fonti.

Lo sviluppo di tecnologie come Hadoop nel 2006 ha accelerato l'evoluzione dei big data. Il framework distribuito di Hadoop ha consentito lo storage e l'elaborazione di enormi dataset su più server, superando le limitazioni dei sistemi centralizzati. Contemporaneamente, i database NoSQL sono stati introdotti per gestire dati non strutturati e semi-strutturati con un maggior livello di flessibilità e velocità, formando la base per la moderna analisi dei big data.

L'ascesa del cloud computing a partire dal 2010 ha ulteriormente trasformato la gestione dei big data. Piattaforme come AWS e Google Cloud hanno consentito alle aziende di scalare lo storage e l'elaborazione dei dati senza effettuare investimenti significativi nell'infrastruttura.

L'avvento dell'IoT (Internet of Things) ha portato ad un'impennata dei dati dei sensori in tempo reale, aumentando in modo esponenziale la produzione di dati a livello globale. Per gestire questa complessità, sono state sviluppate tecnologie avanzate come l'analisi dello streaming, gli strumenti basati sull'AI e gli algoritmi di apprendimento automatico.

Oggi, i big data continuano ad evolversi grazie alle innovazioni introdotte nell'intelligenza artificiale, nell'Edge Computing e nel data science.

Le sfide legate ai big data

I big data offrono enormi opportunità, ma presentano anche sfide tecniche, organizzative e finanziarie.

- Gestione e integrazione dei dati: l'integrazione di diverse origini di dati in piattaforme di big data unificate, come data lake, data warehouse e sistemi di streaming, è complessa. Una gestione scadente conduce ad inefficienze, duplicazioni e perdita di informazioni.

- Qualità e variabilità dei dati: i big data, spesso, contengono informazioni incoerenti o incomplete, specialmente se provenienti da dati non strutturati come i social media. Mantenere la qualità e gestire la variabilità dei dati è fondamentale per evitare di analizzarli in modo errato.

- Domanda di forza lavoro competente: la necessità di disporre delle giuste conoscenze nell'analisi dei big data, nell'apprendimento automatico e nel data science ha creato una lacuna di competenze, che ha richiesto notevoli investimenti per assumere o formare analisti di dati e data scientist.

- Costi dell'infrastruttura: la gestione di grandi volumi di dati richiede soluzioni costose come il cloud computing, i database Hadoop e NoSQL, specialmente per l'elaborazione e lo storage in tempo reale.

- Sicurezza e privacy: è essenziale garantire la sicurezza dei dati sensibili non elaborati provenienti dai dispositivi IoT e da altre fonti. Le organizzazioni devono affrontare varie sfide legate alla crittografia, alla conformità alla privacy e allo storage sicuro.

- Scalabilità e flessibilità: man mano che i dati aumentano, i sistemi devono scalare senza compromettere le performance. Le organizzazioni devono adattarsi alle tecnologie e ai requisiti dei big data in continua evoluzione.

Come funzionano i big data

I big data operano attraverso una serie di passaggi che consentono alle organizzazioni di raccogliere, archiviare, elaborare e analizzare tante informazioni, trasformando i dati non elaborati in informazioni utilizzabili.

- Raccolta dei dati: il processo inizia con la raccolta dei dati da varie origini come dispositivi IoT, che generano i dati dei sensori in tempo reale, e piattaforme di social media, che producono dati non strutturati come post e video. Altre origini includono sistemi transazionali, app mobili e dati di streaming provenienti da eventi live. Questa operazione garantisce che i dati siano completi per poter eseguire un'analisi avanzata.

- Archiviazione dei dati: i dati raccolti vengono archiviati in data lake progettati per diversi formati non elaborati, inclusi dati strutturati, semi-strutturati e non strutturati. I data warehouse organizzano i dati in base alle specifiche esigenze di analisi, mentre le piattaforme di cloud computing offrono un'archiviazione scalabile ed economica per la gestione di grandi volumi di dati.

- Elaborazione dei dati: strumenti come Hadoop e Spark gestiscono l'elaborazione distribuita suddividendo i dati in blocchi gestibili. Le piattaforme cloud forniscono anche risorse per la pulizia, la trasformazione e l'integrazione dei dati per garantirne l'elevata qualità. Questa operazione prepara i dati per l'analisi predittiva e altre applicazioni avanzate.

- Visualizzazione dei dati: i dati elaborati vengono visualizzati tramite strumenti come Tableau e Power BI, che utilizzano dashboard e ausili visivi come grafici e mappe termiche per semplificare i complessi dataset, consentendo ai responsabili decisionali di scoprire tendenze e correlazioni, il che rende il processo decisionale più semplice, rapido e sicuro.

Applicazioni e casi di utilizzo dei big data

I big data stanno trasformando i settori in tutto il mondo, fornendo informazioni utili, migliorando l'efficienza e favorendo l'innovazione.

- Settore sanitario: i big data offrono modelli predittivi e il monitoraggio dei pazienti in tempo reale tramite i dati dei sensori provenienti dai dispositivi indossabili, come gli smartwatch. Gli ospedali utilizzano grandi dataset per personalizzare i piani di trattamento, analizzare le informazioni genetiche e ottimizzare le operazioni, riducendo i tempi di attesa dei pazienti e migliorando l'assistenza sanitaria.

- Business intelligence e retail: le aziende utilizzano l'analisi dei big data per perfezionare le strategie dei prezzi, prevedere la domanda e personalizzare il marketing. Le piattaforme di e-commerce come Amazon ottimizzano l'inventario e regolano i prezzi in modo dinamico, mentre i dati sulle transazioni aiutano a rilevare le frodi nei servizi finanziari.

- AI e big data: i sistemi basati sull'AI si affidano a grandi dataset per addestrare i modelli per il riconoscimento delle immagini, l'elaborazione del linguaggio naturale e il rilevamento delle frodi. Le automobili a guida autonoma e gli assistenti virtuali come Alexa utilizzano i big data per migliorare i processi decisionali e la personalizzazione.

- IoT (Internet of Things): i dispositivi IoT generano flussi di dati in tempo reale per l'ottimizzazione delle performance e la manutenzione predittiva. I termostati intelligenti consigliano di utilizzare le impostazioni a risparmio energetico, mentre in agricoltura vengono utilizzati sensori IoT per monitorare l'umidità del suolo e migliorare l'efficienza.

- Supply chain e logistica: i flussi di dati provenienti dai sensori GPS e RFID migliorano il monitoraggio delle spedizioni, l'ottimizzazione dei percorsi e la gestione dell'inventario. L'analisi predittiva garantisce la disponibilità dei prodotti giusti, risparmiando sui costi e migliorando l'accuratezza delle consegne.

- Finanza e banking: i big data aiutano a rilevare le frodi, ottimizzare la gestione dei rischi e migliorare la valutazione dei crediti. Gli algoritmi analizzano le cronologie delle transazioni per individuare eventuali anomalie, mentre le banche per gli investimenti le utilizzano per il trading algoritmico e la previsione dei prezzi.

- Media & Entertainment: piattaforme come Netflix utilizzano i big data per consigliare i contenuti, migliorando l'engagement degli utenti mediante l'analisi delle loro preferenze. Le società che operano nel settore dei media ottimizzano le proprie strategie pubblicitarie indirizzandosi agli utenti desiderati tramite l'analisi dei social media.

- Settore manifatturiero: i dati dei sensori provenienti dalle apparecchiature vengono analizzati in tempo reale per prevedere i guasti e pianificare la manutenzione. I big data informano anche il team di progettazione dei prodotti valutando i feedback dei clienti e i modelli di utilizzo.

- Istruzione: i big data personalizzano le experience di apprendimento analizzando le valutazioni e le metriche di engagement, aiutando, nel contempo, le università ad ottimizzare la previsione delle iscrizioni e ad allocare le risorse in modo efficiente.

- Energia e servizi di pubblica utilità: i big data ottimizzano il consumo energetico e integrano le fonti rinnovabili. Le reti elettriche intelligenti utilizzano il monitoraggio in tempo reale, mentre le società petrolifere analizzano i dati sismici per ridurre i costi e l'impatto ambientale.

Tecnologie e soluzioni essenziali per i big data

Una gestione efficace dei big data richiede strumenti e tecnologie avanzati per lo storage, l'elaborazione, l'analisi e la visualizzazione, al fine di estrarre informazioni utilizzabili da dataset complessi e di grandi dimensioni.

- Le soluzioni di storage dei dati costituiscono la base della gestione dei big data. I data lake archiviano i dati non elaborati, inclusi dati strutturati, semi-strutturati e non strutturati, mentre i data warehouse organizzano i dati per facilitare l'esecuzione di query e la creazione di rapporti. Le piattaforme cloud scalabili e convenienti gestiscono in modo efficiente volumi di dati sempre maggiori.

- Gli strumenti di elaborazione e analisi dei dati convertono i dati non elaborati in informazioni utilizzabili. Vari framework come Hadoop consentono di elaborare grandi dataset in modo distribuito, mentre Apache Spark è un sistema specializzato nell'elaborazione dei dati in tempo reale, che supporta l'apprendimento automatico. Gli strumenti di estrazione, trasformazione e carico dei dati (ETL) come Talend preparano i dati per l'analisi estraendoli, trasformandoli e caricandoli in modo efficace.

- I database per i big data supportano diversi formati. I database NoSQL, come MongoDB e Cassandra, gestiscono i dati non strutturati con funzioni di scalabilità, mentre i database relazionali come MySQL gestiscono i dati strutturati in modo efficace.

- Gli strumenti di visualizzazione dei dati rendono le informazioni accessibili. Vari strumenti come Tableau e Power BI creano dashboard interattivi, semplificando i dataset più complessi. Le visualizzazioni personalizzate vengono create con strumenti come D3.js per specifiche applicazioni web.

- Le piattaforme di analisi dei big data come Google BigQuery e Amazon Redshift consentono di eseguire rapidamente query e analisi, mentre sistemi completi come Cloudera combinano funzioni di storage, elaborazione e analisi in un'unica soluzione.

- Gli strumenti di AI e apprendimento automatico si basano sui big data per lo sviluppo dei modelli. Vari framework come TensorFlow e PyTorch elaborano enormi dataset, mentre piattaforme come Google AutoML rendono l'AI accessibile agli utenti meno esperti.

- Le tecnologie di streaming e in tempo reale, come Apache Kafka, gestiscono i flussi di dati in tempo reale provenienti dai dispositivi IoT e dai social media, mentre Flink esegue le analisi necessarie per fornire informazioni immediate.

- Le soluzioni di governance e sicurezza garantiscono sicurezza e conformità. Gli strumenti di crittografia proteggono i dati sensibili, mentre le piattaforme come Collibra mantengono la qualità dei dati e garantiscono la conformità normativa.

- Gli strumenti di integrazione, come Apache NiFi, automatizzano il movimento dei dati tra i sistemi per una collaborazione ottimale e una gestione efficace di ecosistemi dei dati complessi.

Domande frequenti

I big data aiutano le organizzazioni a prendere decisioni informate, identificare le tendenze, migliorare le customer experience e ottimizzare le operazioni, consentendo a vari settori, come quello sanitario/finanziario o al retail, di innovarsi e rimanere competitivi.

I big data vengono generati da una varietà di origini, tra cui social media, dispositivi IoT, piattaforme di e-commerce, transazioni finanziarie, dati di streaming e database pubblici.

Un data lake memorizza i dati non elaborati nel suo formato nativo e può essere utilizzato per varie applicazioni. Un data warehouse organizza i dati in formati strutturati per semplificare le query e le applicazioni di business intelligence.

Tra le sfide legate ai big data, figurano la gestione della qualità dei dati, la necessità di garantire la sicurezza, l'integrazione di diverse origini, la gestione dei costi dell'infrastruttura e la ricerca di professionisti qualificati in grado di analizzare e interpretare i dati.

Perché i clienti scelgono Akamai

Akamai è l'azienda di cybersecurity e cloud computing che abilita e protegge il business online. Le nostre soluzioni di sicurezza leader del settore, l'innovativa intelligence sulle minacce e il team presente su scala globale forniscono una difesa approfondita in grado di proteggere applicazioni e dati critici ovunque. Le soluzioni complete di cloud computing offerte da Akamai assicurano performance elevate e notevoli risparmi grazie alla piattaforma più distribuita al mondo. Le maggiori aziende internazionali si affidano ad Akamai per ottenere la protezione, la scalabilità e le competenze leader del settore di cui hanno bisogno per far crescere le loro attività senza rischi.