Big Data refere-se a conjuntos de dados extremamente grandes e complexos que não podem ser gerenciados, processados ou analisados de forma eficaz com ferramentas tradicionais. Ele inclui dados estruturados, semiestruturados e não estruturados gerados a partir de várias fontes, como mídia social, dispositivos de IoT e sistemas transacionais.

O Big Data transformou o mundo moderno, potencializando desde recomendações de produtos personalizadas até avanços na saúde. Cada clique, deslize e transação que fazemos contribui para uma pegada digital cada vez maior de informações. Essa explosão de dados promete um mundo mais conectado, mais eficiente e mais inteligente. Diferentemente dos sistemas de dados tradicionais, que lutam com conjuntos de dados complexos, o Big Data prospera em diversidade, escala e velocidade. Desde o avanço dos algoritmos de aprendizado de máquina até a tomada de decisões em tempo real, os aplicativos para usar Big Data para resolver problemas e melhorar as experiências são tão vastos e variados quanto suas fontes.

Big Data: definição

Big Data refere-se às grandes quantidades de dados – estruturados, semiestruturados e não estruturados – que o mundo digital gera em alta velocidade e que exigem ferramentas avançadas para armazenamento, análise de dados e processamento. Ele engloba conjuntos de dados que os sistemas de dados tradicionais, como planilhas ou bancos de dados relacionais, podem não gerenciar com eficiência. Na realidade, o Big Data depende de plataformas especializadas, como Hadoop, data lakes e computação em nuvem.

A importância do Big Data

Big Data é uma ferramenta essencial para os negócios que permite que as organizações tomem decisões melhores, mais rápidas e mais informadas. Ao analisarem grandes conjuntos de dados de diversas fontes de dados, as empresas podem identificar tendências, identificar correlações e entender as preferências do cliente que antes eram indetectáveis. Esses insights valiosos não só melhoram a tomada de decisões, como também permitem que as organizações prevejam mudanças de mercado, adaptem estratégias e obtenham uma vantagem competitiva. Em setores como finanças, saúde e varejo, o Big Data impulsiona a inovação, reduz riscos e garante que as organizações permaneçam ágeis em um mundo em rápida mudança.

Tipos de Big Data

Big Data tem três formas principais, cada uma oferecendo desafios e oportunidades exclusivos para processamento e análise.

- Dados estruturados: São dados altamente organizados e armazenados em formatos predefinidos, normalmente em bancos de dados relacionais. Os dados estruturados são fáceis de pesquisar, consultar e analisar usando ferramentas tradicionais, como SQL. Exemplos incluem registros de clientes, transações financeiras e dados de inventário. Sua natureza bem organizada o torna adequado para sistemas que dependem de formatos de dados consistentes e previsíveis, como plataformas de business intelligence e data warehouses.

- Dados não estruturados: Os dados não estruturados não seguem um formato ou esquema específico, o que dificulta seu armazenamento e análise. Exemplos incluem arquivos de texto, imagens, vídeos, e-mails e publicações em redes sociais. Esses dados são responsáveis pela maioria dos grandes volumes de informações geradas diariamente e requerem ferramentas especializadas, como algoritmos de aprendizado de máquina ou processamento de linguagem natural (PLN), para extrair insights significativos. Os dados não estruturados são essenciais para setores como mídia, marketing e saúde, em que informações contextuais valiosas são fundamentais.

- Dados semiestruturados: Dados semiestruturados representam um ponto médio entre dados estruturados e não estruturados. Eles contêm elementos de ambos, como campos identificáveis ou marcas dentro de um formato flexível. Exemplos incluem XML, arquivos JSON e dados de sensor de dispositivos de Internet das coisas (IoT). Embora eles não tenham uma organização rigorosa de dados estruturados, os dados semiestruturados são mais fáceis de processar do que os dados puramente não estruturados e são frequentemente usados em aplicações web, comércio eletrônico e iniciativas de integração de dados.

Fontes de Big Data

O Big Data é gerado a partir de uma ampla variedade de fontes de dados que abrangem tanto o mundo digital quanto o físico.

- Plataformas de mídias sociais: Plataformas como Facebook, Twitter, Instagram e LinkedIn produzem grandes volumes de dados brutos diariamente por meio de postagens, comentários, curtidas e conteúdo multimídia. Esses dados não estruturados trazem insights sobre o comportamento do usuário, análise de sentimentos e tendências de engajamento, ajudando as empresas a refinar sua experiência do cliente e estratégias de marketing.

- Dispositivos de IoT (Internet das coisas): Bilhões de dispositivos conectados, como sistemas domésticos inteligentes, vestíveis e sensores industriais, geram dados de sensores contínuos. Esses dados de máquina permitem aplicações em manutenção preditiva, monitoramento ambiental e planejamento inteligente da cidade, com processamento em tempo real, garantindo insights oportunos.

- Dados de comércio eletrônico e transacionais: Plataformas de varejo on-line, sistemas bancários e terminais de ponto de venda geram dados transacionais, incluindo informações de compra, comportamento do cliente e tendências de preços. Esses dados ajudam as empresas a otimizar o inventário, criar recomendações personalizadas e aumentar a eficiência operacional.

- Fontes de dados de streaming: Os fluxos de dados de sistemas em tempo real, como mercados financeiros, monitoramento de clima e atualizações esportivas ao vivo, fornecem insights dinâmicos.

- Mídia e Web: Os canais de notícias, plataformas de vídeo e sites contribuem com grandes quantidades de dados não estruturados na forma de artigos, vídeos, imagens e comentários. Além disso, os dados de tráfego da Web, como clickstreams e logs de sessão, oferecem insights sobre o comportamento e as tendências do usuário, que são essenciais para melhorar as interfaces do usuário e as estratégias de marketing digital.

- Código aberto: Os dados disponíveis publicamente a partir de bancos de dados governamentais, estudos de pesquisa e plataformas de acesso aberto fornecem uma grande variedade de informações para análise. Dados como estatísticas demográficas, dados climáticos e repositórios de pesquisa científica, por exemplo, podem ser usados pelas organizações para a elaboração de políticas, inovação e iniciativas sociais.

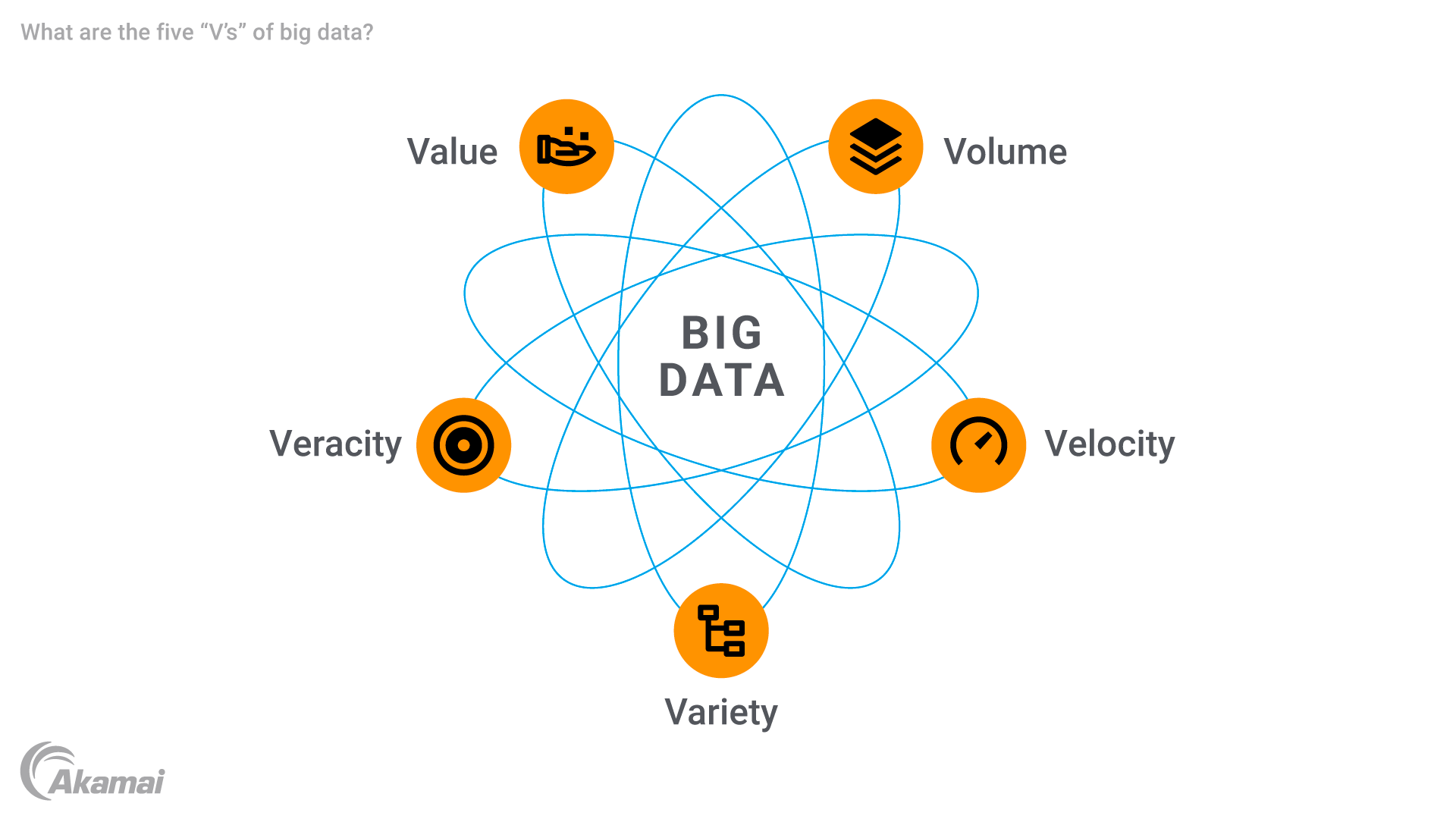

Os cinco "Vs" do Big Data

Os grandes dados são caracterizados por cinco atributos principais, frequentemente referidos como os cinco “Vs”.

- Volume: A característica mais marcante do Big Data é seu tamanho imenso. As organizações lidam com volumes de dados medidos em terabytes, petabytes ou até exabytes de informações. Essa grande quantidade de dados requer soluções avançadas de armazenamento de dados para armazenar e processar as informações com eficiência.

- Velocidade: O Big Data é gerado e processado em uma velocidade incrível, geralmente em tempo real. Seja para streaming de dispositivos de IoT, feeds de mídia social ou transações financeiras, o fluxo rápido de dados requer tecnologias robustas capazes de lidar com o processamento de dados de alta velocidade para garantir insights oportunos. A velocidade é especialmente crítica em aplicações como detecção de fraudes e manutenção preditiva, em que atrasos podem resultar em perdas significativas.

- Variedade: O Big Data também é marcado por uma ampla variedade de tipos de dados. Os exemplos variam de registros tradicionais de banco de dados relacional a conteúdo multimídia, dados de sensor e metadados. Essa diversidade requer ferramentas sofisticadas para integração e análise de dados, já que os sistemas tradicionais estão mal equipados para lidar com conjuntos de dados complexos.

- Veracidade: Com as enormes quantidades de dados brutos coletados, garantir a qualidade e a precisão dos dados é um desafio significativo. Dados inconsistentes, incompletos ou imprecisos podem prejudicar a confiabilidade da análise preditiva e de outros insights. A veracidade destaca a importância de limpar, validar e gerenciar dados para gerar confiança nos resultados da análise.

- Valor: O objetivo final do Big Data é obter insights valiosos que possam conduzir a tomada de decisões, otimizar operações e criar oportunidades. O uso de Big Data permite que as organizações usem informações brutas e desenvolvam resultados acionáveis que possam melhorar a experiência do cliente, melhorar a eficiência operacional ou impulsionar inovações em campos como saúde e varejo.

A história e a evolução do Big Data

O conceito de Big Data surgiu nos anos 90 à medida que as organizações enfrentavam desafios para gerenciar e analisar grandes conjuntos de dados que superavam os recursos de sistemas tradicionais, como bancos de dados relacionais. As primeiras discussões enfatizavam a necessidade de armazenamento e processamento escaláveis, pois as empresas coletavam mais dados brutos de diversas fontes.

O desenvolvimento de tecnologias como o Hadoop, em 2006, acelerou a evolução do Big Data. A estrutura distribuída do Hadoop permitiu o armazenamento e o processamento de conjuntos de dados massivos em vários servidores, superando as limitações dos sistemas centralizados. Ao mesmo tempo, os bancos de dados NoSQL foram introduzidos para lidar com dados não estruturados e semiestruturados com maior flexibilidade e velocidade, formando a base para a lógica analítica de Big Data moderna.

O surgimento da computação em nuvem, na época de 2010, transformou ainda mais a forma como as organizações gerenciam grandes conjuntos de dados. Plataformas como AWS e Google Cloud permitiram que as empresas dimensionassem o armazenamento e o processamento de dados sem grandes investimentos em infraestrutura.

O advento da Internet das coisas (IoT) provocou um surto nos dados dos sensores em tempo real, aumentando exponencialmente a produção global de dados. Tecnologias avançadas, como análise de streaming, ferramentas com inteligência artificial e algoritmos de aprendizado de máquina, foram desenvolvidas para lidar com essa complexidade.

Atualmente, o Big Data continua a evoluir, alimentado por inovações em inteligência artificial, edge computing e ciência de dados.

Desafios do Big Data

O Big Data gera oportunidades enormes, mas também apresenta desafios técnicos, organizacionais e financeiros.

- Gerenciamento e integração de dados: Integrar diversas fontes de dados em plataformas de Big Data unificadas, como data lakes, data warehouses e sistemas de streaming, é complexo. O gerenciamento inadequado leva a ineficiências, duplicação e insights perdidos.

- Qualidade e variabilidade dos dados: O Big Data geralmente contém informações inconsistentes ou incompletas, especialmente de dados não estruturados, como mídias sociais. Manter a qualidade e gerenciar a variabilidade nos pontos de dados é crucial para evitar erros na análise de dados.

- Demanda de mão de obra qualificada: A necessidade de expertise em análise de Big Data, aprendizado de máquina e ciência de dados criou uma lacuna de habilidades, exigindo investimentos significativos em contratação ou treinamento de cientistas de dados e analistas de dados.

- Custos de infraestrutura: O gerenciamento de grandes volumes de dados requer soluções caras, como computação em nuvem, Hadoop e bancos de dados NoSQL, especialmente para processamento e armazenamento em tempo real.

- Segurança e privacidade: É essencial garantir a segurança de dados brutos confidenciais de dispositivos de IoT e outras fontes. As organizações enfrentam desafios com criptografia, conformidade de privacidade e armazenamento seguro.

- Escalabilidade e flexibilidade: À medida que a quantidade de dados aumenta, os sistemas devem ser dimensionados sem comprometer o desempenho. As organizações devem se adaptar às tecnologias e aos requisitos de Big Data em evolução.

Como o Big Data funciona

O Big Data opera por meio de uma série de etapas que permitem que as organizações coletem, armazenem, processem e analisem grandes informações, transformando dados brutos em insights práticos.

- Coleta de dados: O processo começa com a coleta de dados de fontes como dispositivos de IoT, que geram dados de sensores em tempo real e plataformas de mídia social, produzindo dados não estruturados, como publicações e vídeos. Outras fontes incluem sistemas transacionais, aplicativos móveis e transmissão de dados de eventos ao vivo. Isso garante que os dados sejam abrangentes para análise avançada.

- Armazenamento de dados: Os dados coletados são armazenados em data lakes desenvolvidos para formatos brutos e diversos, incluindo dados estruturados, semiestruturados e não estruturados. Os data warehouses organizam dados para necessidades analíticas específicas, enquanto as plataformas de computação em nuvem oferecem armazenamento escalável e econômico para o gerenciamento de grandes volumes de dados.

- Processamento de dados: Ferramentas como Hadoop e Spark lidam com o processamento distribuído, pois quebram os dados em blocos gerenciáveis. As plataformas na nuvem também fornecem recursos para limpeza, transformação e integração de dados para garantir a qualidade dos dados. Esta etapa prepara dados para análise preditiva e outras aplicações avançadas.

- Visualização de dados: Os dados processados são apresentados por meio de ferramentas como Tableau e Power BI, usando painéis e recursos visuais, como gráficos e mapas de calor. Isso simplifica conjuntos de dados complexos, permitindo que os tomadores de decisões explorem tendências e correlações, facilitando a tomada de decisões mais rápida e confiante.

Aplicações e casos de uso de Big Data

O Big Data está revolucionando os setores em todo o mundo, pois fornece insights práticos, melhora a eficiência e impulsiona a inovação.

- Área da saúde: O Big Data alimenta modelos preditivos e monitoramento de pacientes em tempo real por meio de dados de sensores de produtos vestíveis, como os smartwatches. Os hospitais usam grandes conjuntos de dados para personalizar planos de tratamento, analisar informações genéticas e otimizar operações, reduzindo o tempo de espera do paciente e melhorando o atendimento.

- Inteligência de negócios e varejo: As empresas usam a análise de Big Data para refinar estratégias de preços, prever a demanda e personalizar o marketing. As plataformas de comércio eletrônico, como a Amazon, otimizam o inventário e ajustam os preços dinamicamente, enquanto os dados transacionais auxiliam na detecção de fraudes em serviços financeiros.

- IA e Big Data: Os sistemas de IA dependem de grandes conjuntos de dados para treinar modelos de reconhecimento de imagem, processamento de linguagem natural e detecção de fraudes. Carros autônomos e assistentes virtuais como a Alexa usam Big Data para melhorar a tomada de decisões e a personalização.

- IoT (Internet das coisas): Os dispositivos de IoT geram fluxos de dados em tempo real para otimização do desempenho e manutenção preditiva. Os termostatos inteligentes recomendam configurações de economia de energia, e a agricultura usa sensores de IoT para monitorar a umidade do solo e melhorar a eficiência.

- Cadeia de fornecedores e logística: Fluxos de dados de sensores GPS e RFID melhoram o rastreamento de remessas, a otimização de rotas e o gerenciamento de inventários. A análise preditiva garante que os produtos certos sejam armazenados, poupando custos e aumentando a precisão da entrega.

- Finanças e serviços bancários: O Big Data ajuda a detectar fraudes, melhorar o gerenciamento de riscos e melhorar a pontuação de crédito. Os algoritmos analisam os históricos de transações em busca de anomalias, enquanto os bancos de investimento o utilizam para negociação algorítmica e previsão de preços.

- Mídia e entretenimento: Plataformas como a Netflix usam Big Data para recomendar conteúdo, aumentando o engajamento por meio da análise de preferências do usuário. As empresas de mídia otimizam as estratégias de publicidade direcionando o público por meio de análises de mídia social.

- Fabricação: Os dados do sensor do equipamento são analisados em tempo real para prever falhas e programar a manutenção. O Big Data também informa o projeto do produto avaliando o feedback do cliente e os padrões de uso.

- Educação: O Big Data personaliza as experiências de aprendizagem analisando avaliações e métricas de engajamento. Ele ajuda as universidades a otimizar a previsão de matrículas e alocar recursos com eficiência.

- Energia e serviços públicos: O big data otimiza o consumo de energia e integra fontes renováveis. As redes inteligentes usam monitoramento em tempo real, e as petrolíferas analisam dados sísmicos para reduzir custos e impactos ambientais.

Soluções e tecnologias essenciais de Big Data

O gerenciamento eficaz de Big Data requer ferramentas e tecnologias avançadas para armazenamento, processamento, análise e visualização para extrair insights práticos de conjuntos de dados grandes e complexos.

- As soluções de armazenamento de dados formam a base do gerenciamento de Big Data. Os data lakes armazenam dados brutos e não processados, acomodando dados estruturados, semiestruturados e não estruturados, enquanto os data warehouses organizam os dados para facilitar a consulta e a geração de relatórios. As plataformas de nuvem escaláveis e econômicas gerenciam o aumento eficiente dos volumes de dados.

- As ferramentas de processamento e análise de dados convertem dados brutos em insights utilizáveis. Estruturas como o Hadoop permitem o processamento distribuído de grandes conjuntos de dados, enquanto o Apache Spark é especializado em processamento de dados em tempo real com suporte ao aprendizado de máquina. Ferramentas ETL (extrair, transformar, carregar), como Talend, preparam dados para análise extraindo, transformando e carregando-os com eficiência.

- Os bancos de dados para Big Data lidam com diversos formatos. Bancos de dados NoSQL, como MongoDB e Cassandra, gerenciam dados não estruturados com escalabilidade, enquanto bancos de dados relacionais como o MySQL lidam com dados estruturados de forma eficaz.

- As ferramentas de visualização de dados tornam os insights acessíveis. Ferramentas como Tableau e Power BI criam painéis interativos, simplificando conjuntos de dados complexos. As visualizações personalizadas são criadas com ferramentas como D3.js para aplicações web específicas.

- As plataformas de análise de Big Data, como o Google BigQuery e o Amazon Redshift, possibilitam consultas e análises rápidas, enquanto sistemas abrangentes, como o Cloudera, combinam armazenamento, processamento e análise em uma única solução.

- A inteligência artificial e as ferramentas de aprendizado de máquina dependem do Big Data para o desenvolvimento de modelos. Estruturas como TensorFlow e PyTorch processam grandes conjuntos de dados, enquanto plataformas como o Google AutoML tornam a IA acessível a quem não é especialista.

- Tecnologias de streaming e em tempo real, como o Apache Kafka, gerenciam fluxos de dados em tempo real a partir de dispositivos de IoT e mídia social, enquanto o Flink fornece análises para insights imediatos.

- As soluções de segurança e governança garantem a segurança e a conformidade. As ferramentas de criptografia protegem dados confidenciais, enquanto plataformas como a Collibra mantêm a qualidade dos dados e garantem a conformidade regulatória.

- Ferramentas de integração, como o Apache NiFi, automatizam a movimentação de dados entre sistemas, permitindo a colaboração otimizada e o gerenciamento eficaz de ecossistemas de dados complexos.

Perguntas frequentes

O Big Data ajuda as organizações a tomar decisões conscientes, identificar tendências, melhorar as experiências dos clientes e otimizar as operações. Ele permite que setores como saúde, finanças e varejo inovem e permaneçam competitivos.

O Big Data é gerado a partir de diversas fontes, incluindo mídia social, dispositivos de IoT, plataformas de comércio eletrônico, transações financeiras, dados de streaming e bancos de dados públicos.

O data lake armazena dados brutos em seu formato nativo e é flexível para diversos casos de uso. O data warehouse organiza os dados em formatos estruturados para facilitar a consulta e as aplicações de business intelligence.

Entre os desafios estão o gerenciamento da qualidade dos dados, a garantia da segurança, a integração de diversas fontes, o manuseio dos custos da infraestrutura e a descoberta de profissionais qualificados para analisar e interpretar os dados.

Por que os clientes escolhem a Akamai

A Akamai é a empresa de cibersegurança e computação em nuvem que potencializa e protege negócios online. Nossas soluções de segurança líderes de mercado, a inteligência avançada contra ameaças e a equipe de operações globais oferecem defesa completa para garantir a segurança de dados e aplicações empresariais em todos os lugares. As abrangentes soluções de computação em nuvem da Akamai oferecem desempenho e acessibilidade na plataforma mais distribuída do mundo. Empresas globais confiam na Akamai para obter a confiabilidade, a escala e a experiência líderes do setor necessárias para expandir seus negócios com confiança.